随着人工智能技术的飞速发展,尤其是大型语言模型(Large Language Models,LLM)在自然语言处理领域的广泛应用,越来越多的研究者和爱好者开始关注这些模型内部的工作机制。过去,许多解释和教学视频都是基于假设的示例,这些示例试图用简化的方式说明模型的运作原理。然而,随着机械可解释性(mechanistic interpretability)技术的突破,研究人员现在能够真实地“剖析”模型,揭示其处理信息时的内部电路结构,帮助我们理解模型如何从输入文本中抽取并应用知识。本文将围绕近期的研究进展,特别是借助3Blue1Brown启发而开展的LLM电路可视化项目,深入探讨从假设示例到真实模型内部电路映射的跨越,以及这项技术如何推动对语言模型的本质理解。 大型语言模型的复杂性使得其行为难以直接解读。传统的教学内容多借助简化的图示和假设性动画,展现自注意力机制和隐藏层的运作。

尽管这些示意对理解模型原理有帮助,但它们无法准确代表真实模型面对复杂句子时的具体计算过程。举例来说,3Blue1Brown团队曾通过动画详细描述了模型如何处理句子“A fluffy blue creature roamed the verdant forest.”,并预测模型在看到句点后会如何开始新句子。尽管深刻且直观,该解释仍属于推测范畴,缺乏对模型内部状态的实证支撑。 近期推出的“GPT Circuits”项目弥补了这一不足。该项目由Peter Lai牵头,开发了一款基于真实内部表示的LLM调试器,用以揭示小型GPT-2模型在处理具体文本时的实际计算路径。项目采用两个四层的微型GPT-2模型:一个基于字符级输入训练于莎士比亚作品,另一个使用更传统的GPT-2分词器在儿童短篇故事语料上训练。

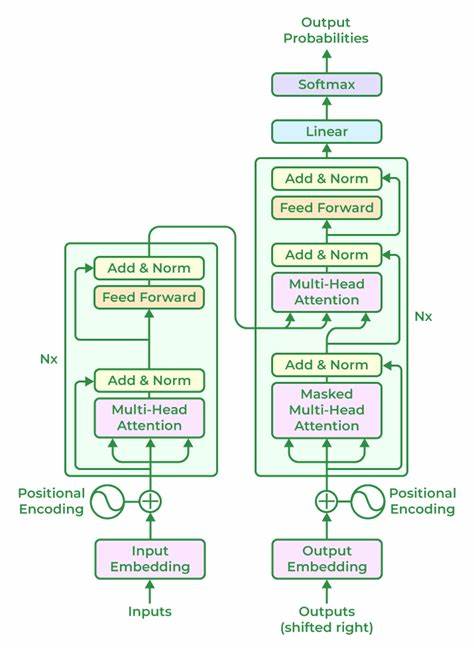

通过自动电路可视化工具,用户可以浏览模型在字词处理过程中的各层特征激活,深入追踪特征间的依赖关系和激活模式。 该调试器的核心创新在于电路的提取与可视化。模型内部的“特征”指的是那些在遇到特定输入序列时激活的神经单元组合。这些特征以集合的形式协同工作,形成更高级别的抽象表示,可以响应句法结构和特定语义模式。系统将这些特征及其层级关系以图形方式展现,使研究者能够直观理解输入如何逐层转化为输出概率。每一列代表输入序列中的不同token,每一行则对应模型的不同层级,从嵌入层到最终输出预测,帮助用户追溯某一特征的上游影响和下游效果。

借助这一工具,对早期3Blue1Brown示例句子的分析揭示模型真实的认知路径。系统能够识别“creature”作为句子的主语,并基于句末的句点线索,推断即将开始新句,从而偏向于动物相关句型的生成。这种机制的揭示不仅证实了此前的直觉推断,还通过训练数据中相似句子的特征激活加以印证。这些语料包括描述狗、动物、昆虫和神秘人物等多样场景,模型通过对历史数据的依赖有效地完成预测任务。 该项目背后的技术基础是机械可解释性领域的新兴研究,强调通过稀疏自动编码器和特征消融实验鉴别关键神经元,重构模型决策路径。不同于传统黑盒视角,机械可解释性试图将神经网络分解为可理解的电路模块,明确各模块功能及其交互。

由剑桥人工智能安全中心等机构支持,结合导师Stefan Heimersheim的指导,项目不仅推动了电路提取算法的发展,也促进了模型透明度和安全性的提升。 这种基于真实内部状态的电路可视化对于语言模型的应用和未来研究意义重大。首先,它为模型行为提供了详细的因果链条,使得模型输出的可预测性和可信度大幅提升。研究者和开发人员可以利用该工具快速定位异常激活和错误预测的根源,优化训练和参数调整过程。其次,透明的电路结构有助于检测模型中的偏见和潜在风险,推动责任AI的建设。此外,教育领域可借助真实电路演示,增强学习者对深度学习原理的理解和兴趣。

未来,随着模型规模的扩大和复杂度提高,电路可视化面临更严峻的挑战。如何在数十亿参数中高效提取有意义的特征电路,保持可解释性与性能的平衡,将成为关键课题。同时,多模态模型和跨语言模型的兴起也催生了对更丰富电路解释的需求。通过整合符号推理、知识图谱和强化学习等技术,未来的LLM调试与可视化工具或将实现更高层次的理解和协作能力。 总的来说,3Blue1Brown对LLM机制解释的启发,使得基于真实数据和内部表示的电路可视化成为可能。这不仅改变了我们对语言模型运作的认知框架,也推动了AI领域向更加透明、可信的未来迈进。

借助如“GPT Circuits”这类工具,每个人都能深入探索大型语言模型背后的复杂电路,体验前所未有的智能系统解析过程。随着技术不断演进,期待更多创新成果涌现,助力AI实现更智慧、更人性化的交互体验。