在数字化时代,个人电脑和工作设备中存储的文件数量不断增长,涵盖文字文档、图片、表格、PDF等等各种格式。尽管现有的本地搜索引擎在查找文件名和基础内容方面有一定的优势,但面对庞大且复杂的文件库,尤其是跨类别、多格式的内容时,往往表现出效率下降和准确度不足的问题。大型语言模型(LLM)凭借其强大的自然语言处理能力和上下文理解能力,成为提升本地搜索体验的有力工具。本文将深入探讨如何将LLM应用于本地搜索引擎中,实现更智能、更便捷的文件查找服务。 大型语言模型的发展为文本理解带来突破性的进展,它们能够理解语义、推理甚至生成接近人类水平的回答。将此能力纳入本地搜索引擎,意味着搜索不仅仅局限于关键词匹配,而是能够理解用户意图、文件内容的深层含义,甚至发现文件之间隐含的关联。

例如,用户希望查找2023年所有发票,传统搜索可能着重匹配文件名或路径中的关键字,而结合LLM则可以通过内容分析识别出那些未按统一格式命名却与发票相关的文件,大幅提升搜索的准确率。 首先,要实现基于LLM的本地搜索,关键步骤是将本地数据转化为模型可理解的格式。文件内容需要被解析、切分成语义单元,甚至针对图片类文件先进行OCR(光学字符识别)处理,将图像中的文字提取出来。OCR技术虽已较为成熟,但因硬件条件限制,运行速度和准确率仍存在差异。对于复杂格式如电子表格或邮件,利用自定义解析器和结构化抽取工具,可以将不同类型文件拆解为可索引的知识块。 之后,利用嵌入模型将文本单元转化为多维向量,实现语义层面的数字化表示。

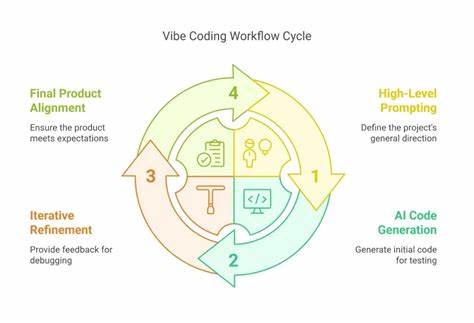

通过向量搜索工具,可以基于用户查询的语义相似度而非简单文字匹配,迅速锁定相关内容。这种做法尤其适用于海量文件的检索,避免了一对一文本遍历带来的性能瓶颈。向量数据库如FAISS等,支持高效的向量检索,成为构建这类系统的重要组件。 在此基础上,LLM不仅可作为查询接口,还能承担结果智能排序、语义摘要、问答辅助等功能。用户输入自然语言搜索请求时,LLM根据向量搜索返回的候选结果进行重排序,并结合上下文输出精准答案。甚至能够像智能助手一样,理解复杂指令“帮我列出2023年所有客户的发票路径,并挑选金额最高的几笔”,极大提升搜索交互体验。

但在实践中,要将LLM作为本地搜索引擎应用,仍面临不容忽视的技术挑战。首先是资源消耗问题。高性能LLM模型通常需要大量内存和显卡支持,普通笔记本电脑难以承载整套流程。虽然近年来模型量化和剪枝技术不断进步,轻量化模型逐渐出现,但要兼顾准确率和响应速度仍需权衡。 其次,数据隐私和安全是关键考量。将私人文件内容上传到云端模型虽方便,但存在隐私泄露风险。

纯本地部署模型和搜索索引,是保证数据安全的理想方案,但技术难度和硬件要求较高。部分开源项目尝试提供端对端的本地搜索解决方案,但尚处于不断完善阶段。 此外,文件类型多样化也增加系统设计复杂度。图片、视频、音频文件的内容提取远比文字文件复杂,需要多模态模型支持和额外计算资源。如何高效集成OCR和多模态理解技术,实现全面索引,是当前研究和应用的热点。 目前市面上已经有一些尝试结合LLM的本地搜索工具或框架。

比如AnythingLLM提供了基于大模型的文档智能搜索概念,Paperless-GPT则利用OCR和LLM自动整理电子文档。开发者社区常用LangChain、FAISS等组件构建自定义的语义搜索系统。尽管用户体验和性能方面仍有差距,但这些项目展现了基于LLM的本地搜索未来广阔前景。 为了构建一个更智能的本地搜索引擎,用户可以结合多种技术实现。首先对存储介质进行阶段性扫描,利用OCR等工具预处理非文本数据,再通过文本拆分和语义嵌入构建高质量索引。选择合适的轻量化LLM或量化模型做后端支持,确保硬件条件匹配。

结合增量索引策略,动态更新数据库以应对新增文件,保证搜索结果实时性。 此外,设计友好的人机交互界面,提供多样化搜索模式(如关键词、语义问答、模糊匹配)和结果可视化,能提升日常使用的便利性和满意度。确保系统能够接入用户习惯的软件环境,甚至支持跨设备同步,也是增强实用性的关键因素。 总结来看,利用大型语言模型改造传统本地搜索引擎,是提升文件查找效率和智能化水平的重要路径。虽然目前仍有资源消耗、安全隐患、跨格式处理等多重挑战,但技术不断演进、开源社区活跃推动创新,使得面向未来的更智能本地搜索场景逐渐明朗。通过结合OCR、语义嵌入、向量检索和LLM问答,多模态数据也能得到更深入利用。

未来随着硬件性能的提升和模型轻量化,基于LLM的本地搜索将更广泛普及,帮助用户快速找到所需内容,极大提升工作和生活效率。