近年来,人工智能(AI)的飞速进步推动了聊天机器人技术的广泛应用。无论是在客服、教育还是娱乐领域,聊天机器人都极大地提升了效率和用户体验。然而,一份由知名信息安全机构NewsGuard发布的最新研究报告揭示了一个令人担忧的事实:热门聊天机器人在虚假信息传播方面的发生率在一年内竟然翻了一番。这一发展可能对社会诚信、信息传播安全以及公众认知带来深远影响。NewsGuard的报告显示,自2024年8月以来,AI厂商对聊天机器人进行了多项更新,增强了它们响应更多用户提问的能力,并赋予了访问互联网的功能。尽管这些改进初衷是为了让机器人更智能、更实用,但它们也无意间提升了机器人生成或传递错误甚至误导性信息的风险。

具体来说,聊天机器人在答复复杂问题时,部分内容缺乏严格验证,容易基于不实信息或未经证实的资料生成回答。特别是随着机器人联网能力的加入,某些未经筛选或不可信的网络资源可能成为虚假信息的来源,使得机器人放大了错误信息的传播范围。造成这一现象的主要原因之一是人工智能训练数据的局限性。虽然训练数据体量庞大,但其中不可避免地带有偏见或不准确内容。此外,AI模型本身缺乏判断信息真伪的能力,只能根据统计规律输出最合适的语言组合,而不具备人类的批判性思维。这也给不法分子利用聊天机器人传播谣言和虚假消息提供了可乘之机。

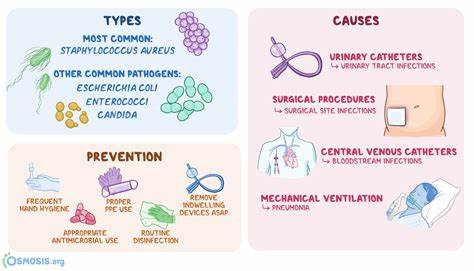

同时,随着更多企业和个人依赖聊天机器人作为信息获取和交流工具,用户对其答案的信任程度普遍较高,这种信任在虚假信息传播时反而成了加速剂。用户未必会对机器人的回答进行核实,可能直接采纳甚至传播错误内容,进一步扩大影响范围。虚假信息的扩散不仅危害公共舆论环境,也可能引发社会恐慌、误导决策、破坏企业声誉乃至危及个人安全。例如,在健康医疗领域,聊天机器人若传播错误的诊断建议或治疗方案,将带来严重后果。在政治领域,错误信息的扩散可能干扰选举和公共政策制定,破坏民主基础。面对这一严峻挑战,AI开发者和平台运营商已开始采取多种应对措施。

首先,加强机器人对信息来源的筛选和标注,提高内容透明度,帮助用户识别回答的真实性和可信度。其次,优化模型训练数据,剔除明显不实或偏颇信息,提升机器人的内在质量。再者,开发具有误导信息检测功能的算法,自动识别和过滤虚假内容。与此同时,监管机构也逐渐意识到AI虚假信息问题的重要性,开始推动相关法律法规的制定和执行,加强对聊天机器人内容的监督管理。公众和用户层面,提高信息素养尤为关键。用户应对聊天机器人的答案保持合理怀疑态度,必要时进行多渠道核实。

教育机构与媒体应加强公众辨别虚假信息的能力,构筑社会"免疫屏障"。未来,解决聊天机器人虚假信息的问题需采纳多方协同合作,从技术创新、政策规范到社会教育,共同营造更健康、安全的信息生态。创新上,可以借助区块链技术确保信息溯源可信,结合人工审核机制防止恶意内容泛滥。政策上,明确聊天机器人责任界限和用户权益保障,促进产业规范发展。社会层面,倡导理性使用和科学传播,减少误导信息危害。总而言之,虽然聊天机器人极大便利了我们的生活和工作,但伴随智能化水平提升的不仅是效率,也带来了虚假信息传播风险。

只有多维度、系统化地应对,才能真正实现人工智能技术的健康可持续发展,让聊天机器人真正成为服务人类的有益工具,而非误导信息的放大器。随着未来AI技术不断演进,我们期待看到更加安全、透明和可信赖的聊天机器人广泛应用,助力构建清朗的信息时代。 。