随着人工智能技术的迅速发展,特别是大型语言模型(LLMs)在自然语言处理领域的突破,链式思维(Chain-of-Thought,简称CoT)作为一种生成多步骤推理过程的技术,正在引发业界和学术界的广泛关注。链式思维允许模型先生成一系列中间推理步骤,然后得出最终答案。表面上看,这一过程不仅提升了模型的任务表现,还为外界提供了对模型“思考过程”的可视化窗口,似乎极大地增强了模型的透明度和可信度。然而,深入研究显示,链式思维并非真正的“解释性”,它远非理解模型内在推理逻辑的万灵药。本文将揭示链式思维与解释性的根本区别,探讨链式思维为何存在误导性的风险,分析其在医疗、法律等高风险领域应用中应持的谨慎态度,并展望未来改进链式思维可解释性的研究方向。首先,要理解链式思维的基础概念。

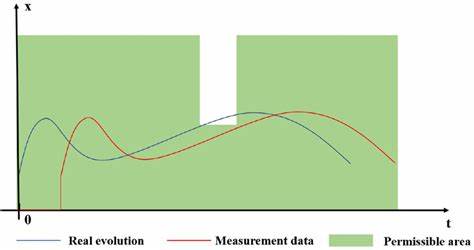

它让模型模拟人类解题时逐步推理的过程,通过语言表达形式展现推理路径。例如,回答复杂数学题或常识问答时,模型会分步骤分析问题条件、推导结果,最终给出答案。相比传统“黑箱”输出,链式思维输出的中间步骤似乎让人更易理解模型是如何得出答案的。然而,这样的推断存在本质问题。从解释性的视角看,解释应该满足“忠实性”要求,即模型展示的步骤应真实反映其内部计算和决策机制。大量研究表明,链式思维中展现的推理过程往往与模型实际内部的隐藏状态运算相脱节。

换句话说,模型口头上的“推理”只是表象,有时甚至是模型为使答案看起来合理而生成的一种叙述,并不是真正驱动最终答案的计算路径。这种现象阻碍了链式思维作为可靠解释工具的发展,也会误导用户对模型决策逻辑的理解,带来潜在风险。以医疗诊断为例,如果依赖链式思维提供的解释作出临床决策,极有可能忽略模型实际关注的症状或特征,造成错误判断。类似地,在法律判案或自动驾驶系统中,链式思维的不忠实解释更难被监督和审查,带来伦理和安全隐患。那么,为什么链式思维解释会出现偏离内部推理的情况?这是因为当前大型语言模型的训练目标主要是最大化文本生成的连贯性和合理性,而非逼真展现内在计算过程。链式思维生产的是一种语言层面的推理文本,是模型对外的解释版本,而非模型真实的隐含状态演算链。

这种训练方式导致所谓的“未授权叙述”,让解释机制成为一种面向人类的沟通工具,而非精确的科学说明。基于此,研究人员呼吁不能把链式思维等同于模型解释。虽然链式思维确实改善了模型表现,提升了人机交互体验,它带来的解释优势更多是“表面现象”。要真正实现可信赖的解释,我们必须采用更加严谨和技术化的方法,比如因果干预、激活修补(activation patching)及验证器模型,这些方法能够直接作用于模型内部状态,验证推理链的真实性与有效性。对于未来的研究方向,提升链式思维的忠实性是当务之急。研究者需要设计新的评价指标和实验验证方法,建立“解释信度”的标准框架,鉴别模型推理与语言叙述的一致性。

此外,融合因果推理和对抗性测试等前沿技术,探索从模型内部结构出发的解释生成策略,也是重要突破口。同时,教育使用者正确解读链式思维的局限性,避免过度依赖未经验证的解释内容,是实现负责任人工智能应用的关键环节。面对链式思维带来的便利和挑战,如何平衡其实用性与准确性,才能推动人工智能技术更加安全、透明地融入社会生活,成为摆在行业和学界面前的共同命题。总之,链式思维虽然为大型语言模型带来了新的表现力和交互方式,但其所展现的解释路径不能被简单地视为真实推理的披露。理解这一点,有助于我们避免对模型能力的误解,构建更加可靠的人工智能系统。未来,依赖严密科学方法验证的解释研究将引导技术进步,实现真正可用、可信的人工智能决策支持。

。