近年来,人工智能领域取得了惊人的进步,OpenAI、DeepMind与Anthropic等机构不断推出具有突破性意义的技术和应用。这三家机构不仅在全球范围内引领技术趋势,还对社会、经济以及科技文化产生深远影响。然而,随着AI的复杂性和规模不断扩大,越来越多的声音开始关注一个关键问题——我们是否正在逐渐失去对人工智能系统的理解能力?这一问题的提出,反映出技术进步背后的深层次矛盾,也引发了学界和产业界的广泛讨论。OpenAI、DeepMind和Anthropic作为人工智能研发的领先代表,它们的技术路线和发展理念在某种程度上体现了当前AI领域的趋势。OpenAI在推动通用人工智能(AGI)研究的同时,关注模型的开放性与安全性,在多个领域开发了如GPT系列的语言模型,广泛应用于自然语言处理、内容生成和自动化任务。DeepMind专注于通过强化学习和深度学习技术解决复杂科学和工程问题,其AlphaGo、AlphaFold等项目展现了AI超越人类专家的潜力。

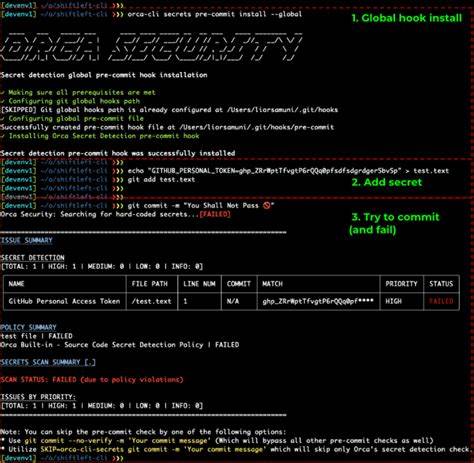

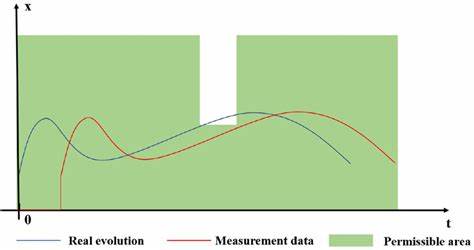

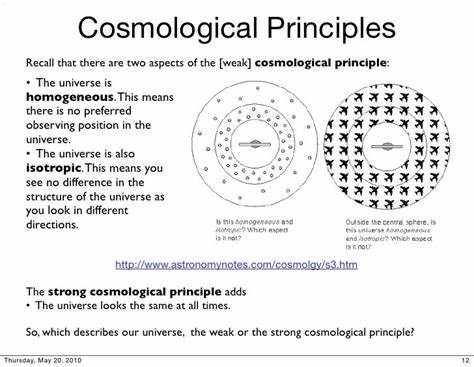

Anthropic则强调人工智能的安全与可控性,致力于构建更加透明和可解释的AI系统,以减少潜在风险。尽管这三者在目标和方法上有所差异,但都面临着同样的挑战:随着模型规模的爆炸性增长和架构的复杂性提升,如何确保人类能够理解和控制这些系统?在传统的软件系统中,开发者可以通过代码审查、调试和测试手段深入掌握系统内部运作机制。然而,现代深度学习模型,特别是那些包含数百亿甚至上千亿参数的神经网络,已经超出了人类直观理解的范畴。模型训练过程中的非线性、高维度以及黑箱特性,使得简单的解释方法难以适用。专家们担忧,随着AI系统变得越来越不可预测,我们可能正在失去必要的“透明窗”,这不仅影响技术开发,也给安全监管带来巨大压力。与此同时,社会公众对AI的认知也相对有限。

复杂的模型架构和技术术语阻挡了普通人对AI工作原理的理解,导致对技术产生不必要的恐慌或盲目信任。OpenAI、DeepMind与Anthropic都在积极推动AI的可解释性研究,致力于提高模型的透明度和公平性。比如通过设计新的解释工具,使得用户和开发者能够更清晰地了解模型决策路径。尽管如此,现有的技术手段仍无法完全满足日益增长的需求。这种“理解鸿沟”不仅仅是技术难题,更是伦理和政策的挑战。政府、企业与研究机构需要协作,建立完善的监管框架,保障AI技术的安全理性发展。

训练数据的偏见、决策的不透明性、黑箱系统带来的不可控风险,都亟需透明度和可追溯性的提升。深度学习模型在带来变革的同时,也不断提出新的问题。曾经被视为技术奇迹的模型,如今需要承担社会责任与风险管理。OpenAI通过发布行为准则和安全政策,努力在创新与风险间寻找平衡;DeepMind则在医疗、科学领域推动AI应用的同时,强化伦理审查和数据保护;Anthropic推动构建符合人类价值的AI设计理念,促进技术与人文的融合。不少学者和从业者提出,通过建立可视化工具、开发更友好的人机交互界面,增强AI系统的透明性和可控性,才能有效减缓理解能力的丧失。他们认为,解释性AI和可解释性研究是未来的关键领域,能够帮助开发者和用户辨别模型的行为,提升信任度。

此外,教育和公众科普工作也十分重要。只有当更多人掌握基础的人工智能知识,才能避免因误解带来的技术滥用或抵制。综合来看,AI发展进入了一个“理解的十字路口”。OpenAI、DeepMind和Anthropic等领导者不断推动技术极限,但同时也警醒人们要正视理解能力的挑战。未来的人工智能系统需要不仅是强大,更要可解释、可控、可审计。科技创新不应成为迷雾笼罩的黑箱,而应当成为促进人类福祉的明灯。

通过多方合作,加强技术研发和伦理监管,提升透明度和公众参与,我们有望在保持AI发展活力的同时,守护人类对智能世界的理解和掌控。面对AI技术日益复杂的现实,理解能力的丢失提醒我们,技术进步不是终点,更是责任的开始。未来,只有把握理解的钥匙,才能真正让人工智能成为人类文明的助力,而不是不可控的未知力量。