在人工智能快速发展的时代,AI产品已经深入各行各业,改变了人们的工作和生活方式。随着各种智能应用如聊天机器人、智能助手和自动化工具的广泛应用,产品的核心竞争力逐渐转向用户体验的细节设计。其中,上下文管理界面(Context Management UI)作为连接用户与AI模型的重要桥梁,变得尤为关键。所谓上下文,即AI模型运行时所依赖的各种信息、数据和指令,它直接影响模型的输出效果和准确性。然而,如何让用户理解并有效管理这些丰富多样的上下文内容,是当前AI产品设计面临的重要课题。上下文管理界面作用的核心在于为用户提供透明度和控制权。

AI模型通常基于大量信息进行推理和回答,但由于模型的内存限制和检索机制,无法完全覆盖所有相关信息,亦或是自动选择的上下文有可能并非最适合回答用户问题。用户在面对AI给出的结果时,自然会产生疑问:系统用对了哪些信息?答案是否值得信赖?是否存在模型“幻觉”或误用信息的情况?这些疑问如果得不到解答,最终会影响用户对AI产品的信任和依赖。正因为如此,打造一个清晰直观的上下文管理界面显得尤为重要。以Luke Wroblewski的个人AI产品“Ask LukeW”为例,其设计思路提供了良好的示范。“Ask LukeW”在回答用户关于数字产品设计的问题时,会自动搜索创始人的大量原创内容,为AI模型选取最相关的文章、视频、音频和PDF作为上下文,并在界面侧边展示出被引用的资源,回答文本中也嵌入了明显的引用标识。这种做法提高了上下文的可见性和透明度,使用户能够明确知道AI的回答基于哪些具体内容。

同时,当用户打开某个被引用资源进行深入浏览时,系统会在提问栏上方出现一个“上下文芯片”,提示当前对话的范围限定在该文件之内,确保用户能够精准提问该文件相关内容。如果想要返回整个知识库的上下文,只需点击芯片上的关闭按钮即可。这种设计不仅帮助用户更好的理解上下文的范围和影响,也方便他们灵活切换不同的上下文层级。上下文芯片作为一种通用的上下文管理元素,在很多AI产品中得到了广泛使用。它们能够直观展示当前哪些信息在影响模型的决策,用户可通过增加或删除芯片来调整上下文内容。然而,当上下文规模扩大,涉及多个来源、各种类型的信息时,这种方式便面临空间和可读性的挑战。

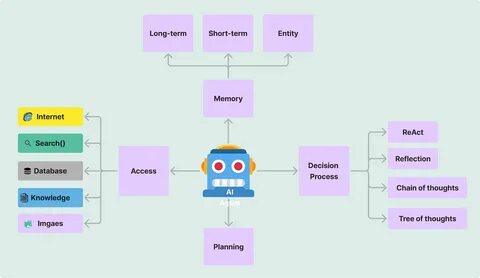

UI界面有限,芯片过多会占据宝贵的屏幕空间,且名称或标识被截断后反而降低了信息的清晰度,违背了展示上下文本意。此外,自动检索的上下文是否都须以芯片形式展示,也是设计上的难题。如果每次模型自动选择相关内容都被单独标示,可能令界面显得杂乱无章,打断用户的注意力。随着技术的发展,AI产品越来越多地采用“智能代理”(Agent)机制,每个代理调用不同工具多次检索和生成上下文更为复杂。上下文的数量和种类的激增,使得传统上下文芯片无法满足需求。比如,某些代理在完成任务时需要不断收集信息,这些上下文的动态变化,如果全部实时显示,用户会感觉界面闪烁、过于纷杂。

针对这一点,Bench团队尝试过将代理使用的上下文实时展示,但用户体验反馈不好,认为这种方式反而分散注意力。经过改进,他们采用了把代理生成过程压缩成简短的步骤,并通过链接指向各步骤涉及的上下文内容。用户可以自主选择是否深入查看上下文,从而获得所需的透明度和理解维度。这种渐进式的信息展示方式,有效减轻了界面负担,也让用户能够集中关注最终结果,只有在异常或疑惑时才进一步了解推理细节。更复杂的情况是在代理之间相互调用或嵌套,形成多层级的上下文网络。此时,Bench通过整合多个工具调用或子代理的数据,形成合并的上下文链接,用户通过单一入口访问所有相关信息,避免了展示冗余或碎片化内容。

这样的设计既维持了内部复杂性的可管理性,也保证了用户体验的简洁与连贯。尽管对上下文管理界面的探索不断深化,设计师也观察到用户实际使用中的行为变化:许多用户对AI输出的关注度更高,而对后台上下文的兴趣较低,除非结果明显有误或产生疑问时才会查看过程和上下文线索。这表明,未来上下文管理UI的呈现方式可能会逐渐变得低调、更具隐性,仅在必要时主动提示和展现。对于AI产品设计者来说,思考如何平衡上下文透明度和界面简洁性,保障信息的可信度与用户信任,是当前和未来的重要课题。要做到这一点,设计师不能简单复制传统的上下文显示方式,而需要结合产品的功能特点、用户预期和使用场景,采用分层、可控、动态适应的设计策略。总之,上下文管理界面是促进用户理解AI决策机制、提升信任感和满意度的关键环节。

只有帮助用户清晰知道AI基于哪些信息输出答案,才能让智能产品在竞争激烈的市场中脱颖而出,赢得用户长远的信赖和支持。随着技术和应用不断演进,关于上下文管理UI的设计必将更加成熟和细致,为AI赋能的未来提供坚实的用户体验基础。