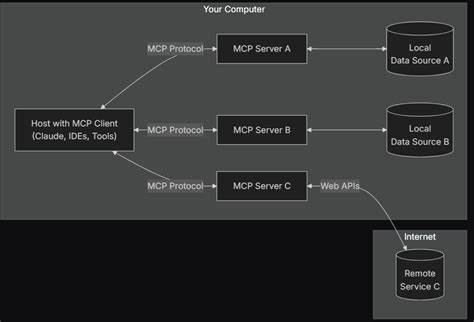

在人工智能迅猛发展的当下,模型上下文协议(Model Context Protocol,简称MCP)凭借其独特的设计理念迅速获得关注。MCP以让大语言模型(LLM)能够自我编排、链接API和用户为核心,旨在构建一个灵活、高效且开放的生态系统。然而,近期在MCP中引入的结构化输出功能却引发了业界热议,甚至被认为有悖于MCP的设计初衷,成为阻碍协议发展的隐忧。本文将深入剖析结构化输出在MCP中的应用问题,探讨其对LLM表现、协议兼容性和客户端设计的负面影响,揭示为何旧有软件设计范式反而可能成为创新进步的绊脚石。 首先,需要理解MCP的根本目标。MCP的核心在于让大语言模型保持“中心”的位置,以其强大的推理能力和上下文理解能力,自主调用合适的工具或API完成复杂任务。

理想中的MCP客户端应当充当管道或桥梁,只需起到连接和传递的作用,不应干预或固定与服务器端的交互逻辑和数据格式。这样的设计保证了协议高度解耦,极大促进不同服务之间的兼容与灵活组合,更能发挥LLM面向人类语言的天然优势。 然而,结构化输出的引入正悖离了这一原则。结构化输出机制要求服务器端必须按照特定的模式返回严格定义的数据结构,同时客户端需解析这些结构才能正常工作。这看似合理的操作,却导致一系列连锁反应,首先体现在LLM响应的质量上。大语言模型训练的基础数据绝大多数为自然语言文本,偶尔涉及一些常见的结构化格式。

过多强制性的结构化标签和额外的元数据,实际上会增加上下文长度,消耗宝贵的令牌额度,降低模型推理的连贯性和准确性。 流畅的自然语言提示是LLM发挥最佳性能的关键。结构化输出中夹杂的格式信息与特定模式,容易打断模型的思考流程,迫使其在非连续的文本片段之间进行推理和整合,进而降低整体输出质量。换言之,所谓的“结构化”反而成为了噪音和干扰,违背了模型本身训练的优势。 其次,结构化输出在技术实现层面也加剧了MCP协议的碎片化和困境。作为服务端,按照结构化输出格式编写响应需要额外的代码和规范约束,这增加了开发成本和维护难度。

与此同时,客户端为了兼容结构化格式,必须设计复杂的解析逻辑和模板,不得不和服务器形成紧耦合关系。一旦某一方变更结构或格式,另一方便可能无法正常协同。 这种严苛的绑定关系直接违背了MCP追求的开放通用理念。MCP的核心价值之一是高度自治与自我编排能力,客户端能够根据上下文自由选择和组合服务,无需对每个服务做出特化适配。结构化输出的硬性要求使工具和服务变得脆弱且难以拓展,限制了生态系统的发展空间。 更严重的是,结构化输出倾向于强制客户端承担本应由服务器端负责的逻辑。

这种职责上的转移不仅模糊了系统边界,还导致重复开销和低效交互。理想的设计应当让服务器根据业务特性优化输出格式,确保让LLM能够轻松理解和调用。然而现实中,结构化输出却约束了服务器的灵活性,客户端不得不增加额外的编码工作来弥补不足,理念上形成了“旧范式”的回归——客户端过度复杂化,失去了MCP轻量且高效的初衷。 用户角度来看,结构化输出也带来了负面体验。早期采用结构化输出的系统多出现响应延迟、工具调用失败率增加等问题,直接影响了用户交互的流畅度和信任度。另一边,保持自然语言为主的响应则令用户获得更自然、灵活且语义丰富的交互效果。

业界的实践表明,成功的MCP客户端应当简洁,同时依托于LLM内部强大的推理能力来实现自我编排和任务调度。令人瞩目的是,一些产品如Claude Desktop不依赖任何预定义的结构化输出格式,能够兼容绝大多数MCP服务器,彰显出极佳的互操作性和稳定性。这种纯文本驱动的设计理念,更符合MCP去中心化且开放的愿景。 对于未来MCP生态的发展而言,关键在于减少客户端和服务器之间不必要的耦合,尊重LLM的自然语言处理优势,并将结构设计权更多赋予服务器端,确保输出符合标准化与灵活性的平衡。客户端应转向利用强大的语言模型能力来动态解析和组织信息,而不是依赖刚性的结构化协议。 当然,结构化输出作为一种工具,也不是毫无用处。

在特定场景下,明确的数据格式确实有利于提高信息传递的准确性,尤其是在基于规则的代理工作流或某些严格的API集成中。但应明确区分MCP和代理式工作流的本质差异,避免将传统流程控制范式硬套入MCP的设计框架中。 结论是,结构化输出在MCP中的广泛强制应用,反而是对该协议核心精神的一种误解和削弱。它既降低了LLM输出质量,增加了系统复杂性,还制约了多样化工具的兼容和规模化生态建设。MCP的生命力在于其轻量的中介角色和灵活自洽的体系架构,保持“去结构化”的文本交互,才能最大化发挥未来AI工具集成的潜力。未来的MCP发展还需从这种旧范式的束缚中解放出来,以创新理念驱动开放生态,真正实现“模型驱动的自我编排”,让人工智能工具的整合更高效、更智能、更具适应性。

。