近年来,人工智能技术在软件开发中的助力作用愈发显著。代码自动生成工具基于大型语言模型(LLM)为开发者节省了大量时间,提高了开发效率。然而,随着AI技术的普及,一种被称为“幻觉包裹”(Hallucinated Packages)的新型安全风险日益引发关注。所谓幻觉包裹,指的是AI模型在代码建议中生成了并不存在的依赖包名称,这些“假包”极具迷惑性,极有可能诱导开发者错误地引入恶意代码,从而在软件供应链中制造安全盲点。幻觉包裹问题首先得名于2025年由研究者Seth Larson提出的“Slopsquatting”概念,形象地描述了攻击者利用AI生成的虚假包名劫持信任的过程。事实上,幻觉包裹现象大大加剧了传统的依赖混淆攻击风险。

例如,安全研究员Bar Lanyado曾指出,知名AI模型ChatGPT会一次性推荐一个名为“huggingface-cli”的虚假Python包。为了验证该现象的潜在威胁,他在Python包索引(PyPI)上上传了一个空的同名包。在短短三个月内,该包下载量已突破三万五千次,涵盖包括阿里巴巴等多家大型企业的开发团队。此实验凸显了AI幻觉包裹极有可能被恶意攻击者利用,插入危险代码,从而威胁整个软件生态。幻觉包裹的产生有多重根源。首先,主流编程语言如Python和JavaScript拥有庞大且开放的包管理生态系统,这本身极易成为攻击载体。

其次,作为辅助工具的AI模型通常基于历史数据训练而成,其知识截止时点导致对最新包信息的误判,从而“猜测”出看似合理却并不存在的包名。最后,开发者在面对AI生成建议时,常陷入所谓的“vibecoding”现象,即过度信赖代码的表面合理性,而忽略必要的验证。研究数据为幻觉包裹的流行与危害提供了坚实支撑。2025年Spracklen等人针对16款大型语言模型,采用超过57万条Python与JavaScript代码提示进行了综合测试。结果显示,闭源的商业模型如OpenAI的GPT系列在包名幻觉率仅为5.2%左右,表现远优于开放源代码模型,其平均幻觉包比例高达21.7%。具体而言,GPT-4 Turbo的幻觉率更是低至3.59%,而许多开源模型如Mixtral、Mistral和CodeLlama则普遍超过15%。

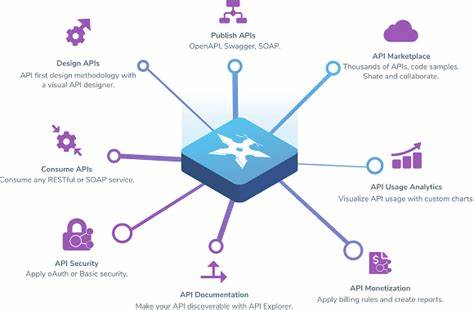

另外,不同编程语言的幻觉频率也存在差异,JavaScript的幻觉率稍高于Python,分别约为21.3%和15.8%。研究还发现有种特殊的语言混淆现象,即AI模型往往在Python代码中引入实际只存在于JavaScript生态中的包,误导依赖的安全审查。面对幻觉包裹带来的安全挑战,企业与开发者必须构建多层次的防御机制。首要原则是绝不盲目接受AI推荐的包名,而是应在官方注册库(如NPM、PyPI)进行严格核实。同时,集成漏洞扫描工具(诸如Snyk、OWASP Dependency-Check、Dependabot)于开发流程,能有效发现潜在风险。使用私有制包管理服务器如Artifactory或Nexus,也能控制依赖的安全范围,防止恶意包进入项目。

团队内部亦需强化代码审查,对于新引入的或不常见的依赖应特别警惕并展开深度评估。定期审计依赖树、采用依赖版本锁定策略,均有助于遏制恶意升级风险。此外,开展针对AI安全风险的专业培训,使开发者了解幻觉包裹的本质及防范思路,提升集体安全警觉性。在AI模型本身层面,研究显示部分先进LLM具备“自我诊断”能力,能够检测并识别自身生成的幻觉包裹。Spracklen团队的实验结果表明,GPT-4 Turbo和GPT-3.5在识别自我幻觉方面的准确率超过89%。这意味着未来AI辅助工具可以内置自动验证模块,主动提醒用户潜在的包名虚假风险,极大提升使用安全。

通过结合检索增强生成(RAG)、自我调节循环与监督微调等技术,已有开源模型幻觉率显著降低,CodeLlama的幻觉比例甚至从26.3%降至9.3%。这为幻觉包裹问题的根本改善提供了技术路径。幻觉包裹现象的出现,折射出AI技术在代码生成领域的复杂挑战,也提出了对软件供应链安全的新考验。鉴于AI助力编程已成大势所趋,切勿因安全隐患而回避这类先进工具,而应借助科学严谨的防御手段,实现安全与效率并重。人类审查依然是守护代码安全的最后防线,将依赖验证嵌入持续集成(CI)流水线、结合自动化扫描与人工审查,能够大幅减少恶意依赖带来的威胁。与此同时,持续关注AI模型在依赖生成准确性上的迭代优化,将为未来构建更健壮的开发生态系统奠定基础。

幻觉包裹提醒我们,技术进步的背后,安全意识不可或缺,唯有全方位提升风险防范水平,才能在AI赋能的软件开发新时代中保持清醒和安全。