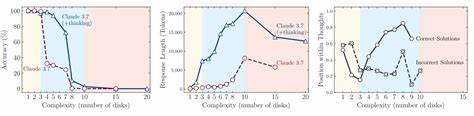

近年来,随着人工智能特别是大型语言模型(LLM)技术的迅猛发展,推理能力成为衡量其智能水平的重要标准。许多先进的推理模型号称能够模拟人类思维过程,快速解决逻辑难题和复杂问题。苹果公司最新发表的一项研究则向业界发出了重要警示:当前大多数推理模型在任务复杂度升级时,表现反而下降,甚至出现了“思考停滞”的现象,证明它们存在“根本性的规模限制”。 这项研究对以Claude 3.7、Deepseek-R1以及OpenAI的o3模型为代表的推理大型语言模型进行了深入测试,参照了经典的逻辑难题如河内塔、跳棋跳跃、过河难题以及积木世界等场景。通过这些可以精确调整难度而不改变基本推理规则的环境,研究人员揭示了模型在不同复杂度水平上的适应状况。 初级难度的任务中,传统非推理模型表现出更高的准确率和更低的计算消耗,相较之下专门设计的推理模型反而耗费更多的推理“token”,准确率却未显著提升。

随着任务难度提升,推理模型逐渐接近甚至超越基本模型的效果,但这一优势伴随着推理步骤和资源消耗的几何增长。 然而,当挑战达到更高复杂度时,所有模型的表现开始急剧下降。令人震惊的是,复杂任务下模型往往“思考”更少,提前中断推理进程,放弃尝试更多可能的解决方案,表现出一种“欠思考”的现象,尽管计算资源充足。 研究进一步分析了“过度思考”和“欠思考”两种极端情况。在易题中,模型有时会过分搜索,产出多余且错误的路径,浪费资源和时间。中等难度时,模型常常需要多次试错才能接近正确答案。

最复杂情况则出现能力坍塌,推理链条断裂甚至在给出正确步骤时也无法完成正确执行。 此外,模型面对不同种类的难题表现也存在差异。研究人员推测,训练数据中示例问题的丰富度是影响因素之一。比如河内塔的示例在网络上较为普遍,所以模型在此类问题上相对表现更稳健,而像复杂河流过渡问题较为少见,导致相应推理能力大幅下降。 苹果团队总结认为当前主流推理模型缺乏通用的策略和结构设计,无法持续应对推理难度激增的挑战。尽管包含了诸如链式思考和自我反思等技术,这些方法更像是局部优化,而非根本性架构创新。

他们呼吁,未来要实现真正强大而稳健的机器推理,必须对模型基本设计原则进行颠覆式改革。 有趣的是,此次研究还映射出现有推理模型主要是在强化特定任务的可靠性,比如数学运算、代码生成,但并未实现真正意义上能力的质的跃升。换言之,所谓“思考链条”不过是统计学计算的另一个表现形式,距离人类的逻辑推理方式尚有较大差距。 苹果此前也曾发布相关报告,指出最优语言模型的表现更多依赖于先进的模式匹配,而非严谨的形式逻辑推理,对于无关信息和细微变动的鲁棒性不足。单纯扩大数据规模和模型容量更多带来的是更强的“模式识别”能力,而非推理能力的根本突破。 这对于目前各大人工智能公司寄望于推理能力打破规模优势瓶颈的策略敲响了警钟。

随着单纯增加训练数据和模型参数带来的效益趋于饱和,推理被视为实现AI更高级飞跃的潜在途径。但苹果研究明确显示,当前思考机制无法在实际复杂任务中保持线性或指数级性能增长。 未来,AI领域或将探索更加多维度的模型设计路线,结合符号计算、神经推理以及元学习等多种范式,以弥补单纯基于统计语言模型的局限。苹果的研究为人们认识模型“思考”边界提供了宝贵数据,也号召学界跳出现有框架,寻找真正意义上的智能推理实现路径。 综上所述,苹果最新研究深刻揭示了当前大型语言模型推理能力面临的核心挑战:更复杂的任务并非简单加码可以解决,反而暴露模型机制的根本不足。未来AI能否实现真正类人推理,仍需依托模型架构的根本创新,而非单纯依赖数据和算力。

对于AI产业链上下游来说,这份研究既是警示,也是指引,促使各方重新审视和设计具备真正推理能力的智能系统构建方法。