随着人工智能技术的飞速发展,大型语言模型(LLMs)在多领域展现出了惊人的能力,尤其是在自然语言处理和知识推理方面。化学作为一门高度专业化且涉及复杂理论与实践的科学,吸引了大量研究者尝试利用LLMs来辅助甚至超越人类专家的表现。那么,大型语言模型在化学知识和推理能力方面的表现究竟如何?它们能否真正取代经验丰富的化学家?本文将基于最新的研究成果进行深入探讨。 大型语言模型突破传统认知的边界,源于其庞大的数据训练和复杂的神经网络结构。研究显示,一些领先的LLMs在化学问题的问答测试中,甚至能够在整体表现上超越多数专业化学家。通过系统化的评测框架,模型在多个化学分支领域如有机化学、无机化学及物理化学等课题上的答题正确率均达到令人惊讶的高度。

这表明LLMs具备相当强的化学知识储备,可以通过分析训练文本中蕴含的大量信息,实现表面上类似人类的理解与应用。 然而,尽管LLMs在考试式问题表现优异,它们的化学推理能力却不尽完美。复杂的结构化推理任务,尤其是那些涉及分子三维构象分析、实验设计与安全性评估等,仍是当前模型的短板。例如,预测核磁共振(NMR)波谱的信号数目这一要求深度结构理解与空间想象力的问题,模型答对的概率远低于专业人士,显示出其对实际化学结构细节的局限。此外,模型在安全毒性等关键领域仍时常给出错误甚至误导性的回答,潜在地带来严重风险。 不仅如此,LLMs普遍存在一个关键性风险,即过度自信。

研究表明,模型给出的信心估计与其回答的正确性往往不匹配,这使得用户在依赖模型时可能低估其错误率。对比之下,经验丰富的化学家往往更注重对自身认知边界的判断与谨慎,从而避免盲目信任单一来源的信息。 当前的化学语言模型评测多数集中于分子性质预测、反应结果估计等具体任务,而缺少对模型综合化学知识和推理能力的宏观考察。面对这一挑战,ChemBench作为一个系统而全面的评测框架应运而生。拥有超过2700组涵盖知识、推理、计算和化学直觉的题库,覆盖了本科及研究生阶段的广泛主题,为衡量模型水平提供了科学的依据。在此框架下,研究者还邀请了具备不同专长背景的化学家作为对照组,以真实应用场景检验模型能力的同时,实现人机性能的直接比较。

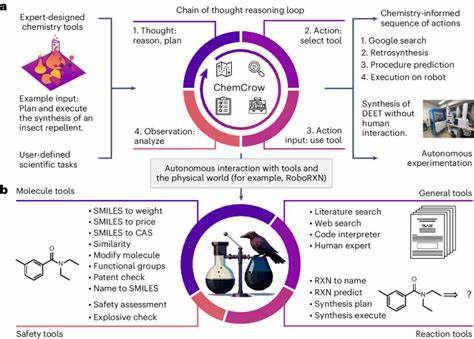

值得注意的是,不同模型之间的表现差异显著,且模型规模与性能呈正相关趋势。开放源码项目Llama-3.1等显示出媲美部分商业闭源模型的能力,反映出学术界和产业界在化学人工智能领域的竞争正日趋激烈。同时,一些工具增强的系统,如结合文献检索和代码执行能力的代理模型,使LLMs能够更灵活地获取外部数据和执行复杂任务,进一步提升应用价值。 对于化学教育而言,LLMs的崛起引发了深刻的反思。传统依赖记忆和机械练习的教育模式可能难以适应未来,因模型已能轻松处理大量记忆型题目,教育者更需关注培养学生的批判性思维和实际推理能力。面对人工智能的强大辅助,化学家不仅要学会与机器协同,更需增强自身难以被替代的创造力和判断力。

隐私和伦理问题同样不可忽视。LLMs的训练往往涉及大量公开和专有数据,存在潜在偏见和滥用风险。尤其是在化学研究中,恶意利用模型设计有害或危险化合物的可能性令人担忧。为此,安全机制的完善及使用者风险意识的提高至关重要。 未来,随着模型规模的不断扩大和专门化数据的融合,预计LLMs将在化学知识掌握和推理能力上取得更大突破。集成多模态信息(如图像、结构数据)和开发针对化学语言的专用架构,将极大增强模型对复杂化学现象的理解与应用。

此外,提升模型自我认知能力,准确表达不确定性,将改善其在科研和工业中的可靠性和信任度。 总之,现阶段大型语言模型已经成为化学领域不可忽视的辅助工具,展现出令人瞩目的潜力和部分超越人类劳动力的能力。但它们目前仍无法完全取代具备深厚经验和推理能力的化学家。未来的研究应继续平衡模型能力与安全性,优化人与机器的协作方式,共同推动化学科学的创新发展。