在机器学习模型训练过程中,实时监控训练进展并评估模型性能是保证最终模型质量的重要环节。尤其是深度学习领域,模型通常会在训练过程中生成多个检查点(Checkpoints),这些检查点记录了模型在特定训练步骤的状态。如何高效地监控这些检查点并自动执行评估,成为科研人员和开发工程师面临的关键挑战。Assayer作为一个基于Python RQ框架的工具,提供了简洁且高效的解决方案,能够自动监视指定目录内的模型检查点文件,并在线下环境中触发评估任务。借助Redis的消息队列机制以及灵活的配置方式,Assayer能够在多实验目录并行地运行,极大地提升训练过程中性能监控的实时性和便捷度。与传统基于文件系统事件监控的工具相比,Assayer避免了第三方复杂依赖,通过纯Python与Redis的结合实现了低维护、高稳定性的监控体系,适合大规模、长时间的机器学习训练任务。

使用Assayer的第一步是准备Redis服务器环境。Redis的高性能与轻量级特性使其成为异步任务队列管理的理想选择。无论是在本地开发环境还是高性能计算集群中,均可通过下载和编译Redis源码进行安装,保证了环境的一致性与可控性。完成Redis部署后,安装必要的Python依赖是启动Assayer的关键环节。其中,RQ库负责连接Redis并管理任务队列,absl-py库则提供了便利的命令行参数处理支持,而Assayer本身则以PyPI或直接从GitHub源码安装方式获得。针对不同实验需求,用户需要自定义评估函数,该函数接受模型检查点路径作为唯一参数,执行相应的模型加载和性能计算逻辑。

这一设计极大增强了Assayer的灵活性,用户可以根据具体任务场景定义评估内容,例如计算准确率、损失值,或结合更复杂的指标体系。启动Assayer监控模式时,只需在命令行指定待监控的模型检查点目录以及对应评估函数的位置。Assayer随后将启动多个工作进程:观察工作进程负责监控目标目录的新增文件,符合预设正则表达式的检查点文件一旦出现,便会将评估任务放入评估队列中,等待评估工作进程执行。用户还可以根据评估任务的耗时和检查点生成频率,灵活调整观察与评估工作进程数量,确保评估始终高效且不会因任务积压延迟最新结果输出。有别于单目录监控工具,Assayer支持同时监控多个实验目录。针对不同实验配置不同的评估策略,实现跨任务并行性能追踪。

此外,用户可使用自定义正则表达式筛选特定文件格式的检查点,方便适配多种深度学习框架产生的文件命名规范。一个常见需求是对已有目录中已存在的检查点执行补充评估,Assayer亦提供相应参数,在启动时自动触发对这些历史检查点的评估,确保训练前期的模型状态数据也纳入性能分析范畴。为简化集群环境中的资源调度,评估函数设计时可以不直接执行完整评估逻辑,而是提交作业调度脚本到集群管理系统(如SLURM)。这种方式使得Assayer工作进程迅速响应新检查点的产生,及时将评估任务分发出去,而不会因单个评估过程阻塞整体监控效率。Assayer内部利用两个独立的Redis消息队列分别管理监控与评估任务。监控进程以递归方式反复检索目标目录,更新已发现检查点列表,发现新文件时提交评估任务。

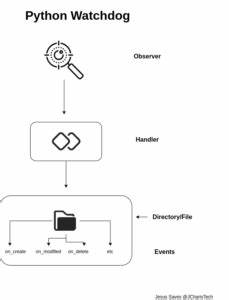

此设计确保了动态且持续的监控效果。评估队列则负责分配计算资源执行预定义评估逻辑,保证结果的及时产出。由此,Assayer实现了训练过程中检查点状态的自动追踪与性能结果的快速反馈,极大提升模型迭代的透明度。不同于传统的基于文件系统事件触发的监控工具,如python的watchdog,Assayer选择纯Python RQ框架架构易于维护且依赖更少,适合长期项目的稳定运行。开源项目的社区氛围也促成了持续改进的可能,用户若有性能与功能优化建议可积极参与讨论。配套的示范案例涵盖了以MNIST数据集训练卷积神经网络的场景,具体实践了训练过程中检查点保存、Assayer监控、评估函数调用及结果存储流程。

示例代码完整且易于理解,加速用户上手与方案验证。常见问题涉及监控频率设置、作业状态查看、文件删除应对机制以及评估结果存储策略,都在文档中有详细说明,方便用户根据实际需求调整参数。总结来说,Assayer作为一个基于Python RQ和Redis的机器学习模型检查点监控与评估利器,通过简洁易用的接口和灵活的配置,解决了训练期间对模型性能动态追踪的难题。它适合用于需要在线下自动评估的复杂训练环境,尤其是在多个实验并行进行、评估成本较高的科研项目中。借助该工具,研究人员能更高效地了解模型学习状态,有针对性地调整训练策略,最大化模型表现。未来,伴随机器学习技术的不断发展,像Assayer这样的自动化监控评估工具将成为标准配置,推动算法研发向智能化与自动化迈进。

。