层归一化(Layer Normalization)作为一种在深度学习训练中广泛应用的技术,极大地提升了神经网络的收敛速度和稳定性,相较于批归一化,它对小批量甚至单个样本的处理表现更为出色。理解层归一化的反向传播梯度计算不仅是优化网络训练的关键,也为开发高效深度学习框架提供了理论支持。本文将全面解析层归一化在反向传播中梯度的推导过程,帮助读者深入掌握其数学原理及实现细节。首先,回顾层归一化的前向传播数学表达。对于输入向量x,假设其维度为N,其中每个元素表示在特征维度上的输入数据。通过对每一个样本中的所有特征值计算均值和方差,层归一化对该样本的每个特征值进行归一化处理。

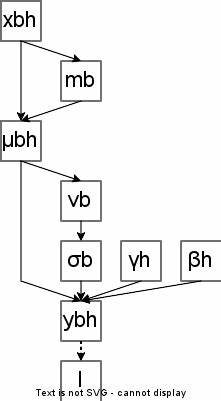

具体公式表示为y = (x - μ) / sqrt(σ^2 + ε) * γ + β,其中μ为样本的均值,σ^2为方差,ε为数值稳定性调整项,γ和β为可学习的缩放和平移参数。归一化输入x̂定义为x̂ = (x - μ) * rstd,其中rstd是方差加上ε倒数的平方根,保证了分母非零且数值稳定。这一过程中,γ和β作用于归一化后的结果,调整其尺度和偏移,赋予模型一定的灵活性。反向传播过程的目标是计算损失函数L关于输入x、参数γ与β的梯度,分别记为dL/dx、dL/dγ和dL/dβ。参数γ和β梯度的计算相对直接,由于它们只影响最终输出y,利用链式法则即可得到其梯度表达。具体而言,dL/dγ根据输出关于γ的偏导数等于dL/dy乘以对应的x̂;dL/dβ则是dL/dy的直接求和。

因为γ和β在整个批次中共享参数,因此在计算时需对所有样本的梯度求和。梯度dL/dx̂的推导同样也较为简单。考虑y 关于归一化输入x̂的导数,能够得到dL/dx̂ = dL/dy * γ,这一过程中体现了缩放参数γ对反向梯度的影响。然而,最为复杂且本质的部分在于计算dL/dx,即输入x的梯度。由于输入x不仅直接影响归一化输入x̂,还通过均值μ和标准差的计算间接影响所有归一化后的元素,因此需要分别利用输入对均值和标准差的偏导进行链式求导。推导开始于x̂ = (x - μ) * rstd,通过乘积法则分解出∂x̂/∂x的两个部分:一是归一化项(x - μ)对x的导数,二是标准差倒数(rstd)对x的导数。

均值μ对单个输入元素的偏导为1/N,反映了均值是所有输入元素的平均。方差σ^2的导数稍显复杂,但利用其关于输入的定义,结果为2/N倍于每个元素与均值差的乘积。结合链式法则,rstd对x的求导依赖于σ^2的导数和负的三次方幂的关系。这一计算结果揭示了x的每一个维度都会影响整个样本的方差及均值,进而影响所有归一化值,表明梯度传播过程中变量间复杂的耦合关系。进一步将导数表达式整理化简,导出的结果呈现出归一化常数rstd与输入x的线性组合形式,这有助于实现时的高效计算和数值稳定。在实际神经网络训练中,为了保证反向传播计算的效率,通常会将求和项预先计算,避免重复的循环操作。

最终,输入梯度dL/dx以简洁明了的表达式呈现:其等于rstd乘以由原始梯度乘以γ,减去均值项与归一化输入x̂与单独的辅助变量乘积之和。通过对整个批次进行向量化计算,这一过程能够非常高效地完成。精确理解和实现层归一化的反向传播梯度计算不仅有助于模型性能的提升,同时对进一步研究改进归一化技术、设计新型网络结构具有指导意义。层归一化尤其适用于循环神经网络等序列模型,反向传播过程中稳定和正确的梯度计算确保了模型训练的高效和鲁棒。综上所述,层归一化的梯度推导涉及对均值和方差敏感性的深入分析,结合链式求导法则,最终实现对输入及参数的梯度精确计算。其推导过程体现了深度学习中数学与工程的结合精髓,为理解复杂模型训练机制提供了坚实基础。

未来,随着深度模型不断发展,类似的归一化技术及其反向传播计算仍将成为研究重点,促进人工智能领域的不断突破与创新。掌握层归一化的梯度推导方法,是每一位从事深度学习研究和应用工作者的重要技能之一。