随着人工智能技术的迅猛发展,尤其是在大型语言模型(LLM)领域,如何有效评估AI系统的表现成为开发者和产品经理关注的焦点。评估不仅关系到模型的准确性和可靠性,还直接影响用户体验和业务成果。为了应对这一挑战,AI评估(AI Evals)逐渐成为构建成熟智能产品不可或缺的环节。本文将系统回答AI评估中的核心问题,帮助读者全面理解评估流程、工具应用及实际操作要点。 首先,理解大型语言模型评估的基本概念极为重要。AI评估是指通过设计科学的测试体系,对AI产品在真实或模拟环境中的表现进行系统性检测和分析。

一个完整的评估追踪(trace)涵盖从用户发起请求到模型最终输出的所有中间步骤,包括多轮对话、工具调用以及辅助系统的响应。这些完整的交互记录为后续的错误分析和性能诊断提供了基础数据。 评估的起点通常是错误分析,它是识别系统缺陷和产品瓶颈的最有效方式。通过对真实用户交互数据的详细审查,研发团队能够发现模型在特定场景下的失败模式。错误分析采用“开放编码”和“轴编码”两步法,前者鼓励人工审查员记录所有异常细节,后者对这些信息进行分类汇总,形成有针对性的错误类型体系。反复循环的迭代过程直到发现的故障模式趋于稳定为止,这一过程被称为理论饱和,通常需要审查超过百条交互轨迹。

在缺乏真实数据的情况下,生成合成数据成为一种重要手段。优质的合成评测数据基于明确的维度划分,例如用户意图、查询复杂度和语境情绪等,通过结构化的多步骤生成过程,由模型产出多样化且覆盖全面的测试用例。然而,合成数据并非万能,在复杂专业领域、低资源语言或需严格验证的高风险场景中,人工采集和校验的真实数据仍不可替代。 关于评估设计,业内普遍推荐采用二元判定(通过/不通过)的方式替代传统的1-5分量表。二元评估简化了标签标准,减轻了人工标注时因主观倾向导致的噪声,且更容易在快速迭代中识别核心问题。开发团队应根据错误分析的发现编写针对具体失败模式的自动化评测工具,而非一味依赖通用评估指标。

事实上,类似BERTScore、ROUGE等通用相似度指标往往无法反映语言模型输出的实际业务价值和用户满意度。 在人力标注流程中,树立“仁慈独裁者”角色尤为关键。一个熟悉产品和用户需求的领域专家能够成为标注决策的最终权威,避免多 annotator 之间过多分歧引起的效率低下。大型组织或跨领域业务可适当引入多人标注,通过考察如Cohen’s Kappa等指标保障标签一致性。与此同时,不能盲目外包标注环节,因为评测的核心是对AI系统缺陷的深入理解和反馈闭环,外部团队通常难以充分把握产品细节和用户预期,导致评估效果大打折扣。 尽管人工分析必不可少,当前的评测流程也能借助大型语言模型协助推动效率提升。

LLM 可辅助完成初步的错误分类、标签映射和提示改进建议,帮助识别模式和提升测试用例覆盖面。但这种自动化工具绝不能替代人工洞察,尤其是在初始的开放编码和根因分析阶段,人工经验和产品直觉决定了评测的质量和价值。 在检视工具选择时,构建定制 Annotation 工具往往效果优于通用方案。定制工具能够整合多系统上下文,适配特定领域数据展示需求,设计高效的过滤和搜索功能,同时支持键盘快捷操作,极大提升评审体验。即使市场上已有多家评测平台,定制化开发有利于实现独有的业务逻辑和流程自动化,缩短迭代周期,增强灵活性。 此外,不同评测工具之间常常存在功能空白,团队应自备补充方案以满足深层次需求。

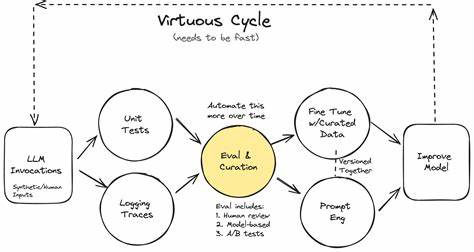

例如,自动聚类分析异常交互、基于语义搜索发现潜在问题、利用AI推断改进策略和解析标签数据的关联趋势等,都是当前评测体系升级的重点方向。重视自定义评估指标和API接口能力能有效避免被固定模式限制,灵活应对业务多变。 对于生产环境中的评估应用,研发团队需区分持续集成(CI/CD)与在线监控两种场景。CI阶段使用精简但覆盖关键特性的测试集,优先采用确定性断言减轻开销,确保核心功能倒退不发生。生产监控依赖异步评测,结合LLM评审等复杂手段实时捕捉新型故障,以维护系统稳定和用户满意度。新发现的问题会反向加入CI测试集,形成良性反馈闭环。

关于防护机制,Guardrails(防护栅栏)与评估器存在本质区别。防护栅栏一般是快速且 deterministic 的实时检查,负责阻止明显失败,例如敏感信息泄露、格式错误等,避免影响终端用户。评估器更多作为异步监控和质量度量工具,处理更细粒度的语义和上下文问题,通常不直接影响响应的即时呈现。两者结合构建多层次保障体系。 由于模型选择和系统优化各环节投入有限,需谨慎分配评估资源。错误分析工作往往占据团队大部分时间,模型更换应基于数据驱动的诊断而非盲目试错。

开发表现评估驱动开发(Eval-driven Development)虽有市场讨论,但多数情况下先做错误分析再针对实际发现构建评测更高效。 领域应用方面,以Retrieval-Augmented Generation(RAG)为例,很多概念误区混淆了简单向量数据库检索和复杂检索机制。评估必须拆分检索模块和生成模块,前者借助经典信息检索指标,后者则结合人工审核和定制评估工具,确保输出的上下文相关性和准确性。文档处理任务中,分块大小的选择根据任务特征(固定输出 vs. 扩展输出)不同而异,需要实验调优以兼顾模型推理能力和整体效率。 复杂多步骤工作流和带有人类交接环节的会话追踪同样需要全链路日志支持并进行分阶段诊断。利用转移失败矩阵帮助定位瓶颈环节,结合工具调用及参数校验,逐级剖析问题。

智能代理工作流的性能评估亦建议分为任务成功率和步骤级准确性两层,强化根因追踪能力。 总结来看,AI评估是一门结合定性和定量方法、以用户需求驱动的交叉学科。科学的评估流程能使开发者准确掌握模型性能、发现隐性缺陷、合理分配有限资源并持续提升产品质量。合理利用人工智能辅助工具与自研定制方案并重,形成闭环反馈机制,是构建可靠、灵活且可持续维护AI系统的关键。随着技术不断演进,拥抱多样化的评测策略和工具生态,将助力行业稳步走向成熟和创新新高度。