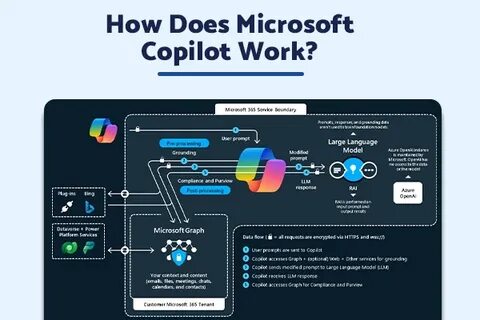

随着人工智能技术在企业应用中的广泛普及,微软推出的Copilot企业版因其集成了强大的Python沙箱功能和Jupyter Notebook运行环境,成为备受关注的创新产品。2025年4月,微软静悄悄地为Copilot推送了一个更新,使得该产品能够在后端执行Python代码,这一举措从表面看极具吸引力,但也为安全研究者提供了深入探索的契机。本文将带您详细了解一个关键漏洞的发现过程,深入剖析漏洞根源、技术细节及其影响,也展示了在现代AI沙箱环境中如何进行安全研究的思路与方法。 Copilot的Python沙箱基于Jupyter Notebook运行,能执行用户提交的代码却限制在一个容器中,运行环境为Ubuntu用户,使用miniconda管理Python环境。在多次尝试后发现,虽然系统运行权限有所限制,但用户“ubuntu”处于sudo组中,实验中却发现容器内并未安装sudo命令,限制了直接使用sudo获得更高权限的可能。同时,运行环境采用OverlayFS文件系统技术,结合链接本地网络接口,将访问范围严格限制在容器内。

容器的文件系统结构与传统Ubuntu环境有所不同,关键目录如/app 包含定制脚本及二进制文件,其中包括名为goclientapp的Go语言编译二进制文件。该程序监听6000端口,处理来自外部的POST请求,接收JSON格式的代码指令并在Jupyter环境中执行,返回执行结果给用户。另一个关键二进制文件httpproxy运行HTTP代理服务,但由于容器未开启外网流量,实际作用暂未释放。 深入分析容器启动脚本entrypoint.sh揭示了漏洞诞生的关键。脚本的第28行执行了pgrep命令用于检测Jupyter进程,然而pgrep命令未使用绝对路径,导致系统按PATH环境变量顺序查找可执行文件。令人意外的是,PATH变量中包含多条可写路径且优先级高于系统默认路径,/app/miniconda/bin目录的可写权限为ubuntu用户所有,这无疑为攻击提供了契机。

攻击者只需在该目录中上传一个恶意重命名为‘pgrep’的Python脚本,该脚本将读取特定路径下的指令文件,执行其内容并输出至指定文件。通过巧妙利用容器中多次执行的pgrep命令,这个恶意脚本得以反复运行,实现了执行任意代码的能力。 尽管该漏洞允许攻击者以根权限运行代码,由于容器针对文件访问和网络通信做出了严格限制,进一步攻击如容器逃逸等尝试皆以失败告终。但攻击者得以在容器中探索更多敏感区域,访问此前受限目录,深入理解运行环境,为后续安全研究提供了宝贵资料。 该漏洞于2025年4月向微软安全响应中心报告,经过数月沟通与修复,最终于2025年7月发布修补版本。微软将其定为中等级别安全漏洞,未触及最高安全赏金条件,但针对Copilot产品的安全防护体系进行了重要增强。

此次案例彰显了AI系统中传统软件安全隐患与现代云沙箱架构相结合带来的复杂性,提示开发者在设计时必须严格限制PATH变量及执行环境权限。 从此次事件中,我们也可以看出,基于模型驱动的沙箱系统虽然提升了灵活性与功能性,但实现过程中微小的配置疏漏便可能引入安全风险。为此,安全团队应加大对AI辅助开发与执行环境的安全审计力度,结合静态分析和动态检测手段,全方位保障AI产品安全。 此外,漏洞的发现也依赖于持续的安全研究与社区协作。报告者通过多次测试与环境分析,准确判断潜在威胁并配合厂商迅速完成修复,这种负责任的漏洞公开、协作模式有助于提升整个行业的安全防御能力。 在未来,随着AI能力的不断增强及其深度嵌入开发流程,针对相关系统的攻击也将呈现更加复杂多样的趋势。

企业应积极构建多层次安全防护体系,加强内部培训,提升应对新型攻击的能力。同时,定期参与或关注国内外安全峰会,如BlackHat等活动,有助于掌握最新安全情报与攻防技术,及时应对潜在威胁。 总结来看,通过对微软Copilot企业版Python沙箱的深入研究,我们不仅揭示了一个严重的安全漏洞,更从一个真实案例中提炼出在AI沙箱设计与运维中至关重要的安全经验。限制系统路径、合理配置权限、强化监控预警,这些都是保障AI应用安全不可忽视的基础。希望本次分享能够为广大开发者、运维人员及安全专家提供有益启示,携手守护AI技术的健康发展。