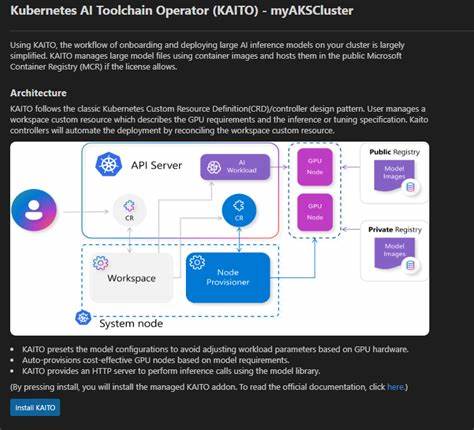

随着人工智能技术的迅猛发展,越来越多的企业和开发者希望将大型开源模型高效地部署到云计算环境中,实现自动化的推理和模型调优。Kaito作为一款专为Kubernetes设计的AI工具链操作器,在这一领域展示了独特的优势。它不仅简化了复杂模型在容器化集群中的运维流程,还结合了自动GPU资源管理和智能推理服务,成为了现代AI基础设施建设的重要利器。 Kaito的诞生背景源自于当前大模型部署存在的诸多挑战。传统的模型应用多依赖于虚拟机基础设施,涉及繁琐的环境搭建及硬件适配问题。而Kaito则依托Kubernetes的容器编排能力,采用自定义资源定义(CRD)和控制器设计模式,极大地提升了模型推理和调优工作负载的自动化水平。

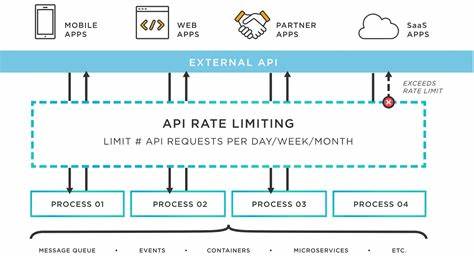

用户只需定义符合需求的Workspace资源,Kaito即可自动协调节点调度、推理容器创建及资源优化。 其中,Kaito支持管理大型模型文件的容器镜像,用户无需手动调整复杂的GPU参数,依托预设配置即可快速启动符合算力需求的推理服务。其兼容多种开源推理运行时,诸如vLLM和transformers,使得不同架构和用途的模型部署更加灵活。另一方面,Kaito通过公开的微软容器注册表提供部分大模型镜像,解决了模型分发与版本控制的难题。 在Kaito架构设计方面,它主要包含两个核心控制器:工作空间控制器与GPU节点自动供应控制器。工作空间控制器负责监听和管理用户定义的Workspace资源,自动发起节点资源申请并创建推理或调优工作负载。

GPU节点供应控制器则基于Karpenter中的NodeClaim CRD,动态与云端资源管理接口交互,将所需GPU节点添加至Kubernetes集群。此设计不仅支持Azure Kubernetes Service(AKS)和AKS Arc,也具备模块化替换能力,为用户提供高度扩展性。 从版本0.5.0起,Kaito引入了创新的子项目——RAGEngine操作器,以应对Retrieval Augmented Generation服务的快速兴起。相比单一模型推理,RAG服务结合向量数据库和上下文检索技术,提升了问答、摘要等能力的准确性和实时性。RAGEngine自动整合来自LlamaIndex的编排能力、FAISS嵌入数据库以及远程或本地的向量嵌入服务,用户通过简单的自定义资源即可启动完备的RAG服务架构。 安装部署方面,Kaito提供了多样化的方案。

用户可通过Helm Charts或Terraform脚本快速在Kubernetes环境中搭建Workspace和RAGEngine。配合详实的示例配置,如部署phi-3.5-mini-instruct模型,用户能够一步步完成模型服务启动,并使用集群内临时curl容器进行接口测试。丰富的官方文档涵盖了包括API定义、调优指导、模型扩展及FAQ,极大地降低了上手门槛。 在实际应用中,Kaito不仅助力开发者轻松管理和扩展模型推理集群,也推动了基于开源模型的企业级解决方案创新。自动GPU资源调配和镜像托管让团队聚焦于算法开发与业务创新,而无需花费大量成本在基础设施调优上。结合不断扩充的模型库和预设配置,用户可灵活选择适合自身需求的AI能力,提升整体效率。

同时,作为开源项目,Kaito集聚了来自全球的开发者与贡献者。项目遵循CNCF的贡献者许可协议,社区活跃,定期召开周会讨论新特性及改进方向。用户可通过Slack频道获取帮助,与开发团队直接交流,从而促进项目的持续健康发展和功能完善。 总结而言,Kaito通过完备的自动化设计和灵活的配置体系,成功实现了Kubernetes环境下大规模AI模型的高效管理和推理服务的标准化。它融合了自动GPU调度、便捷的模型部署流程和前沿的RAG技术,为AI互联网时代的智能应用提供了坚实支撑。对企业和开发者而言,采用Kaito意味着显著缩短模型上线时间、降低运维复杂度,最终加速AI价值落地。

未来,随着更多开源推理框架的整合及云原生技术的演进,Kaito有望在智能计算生态中持续发挥引领作用,推动AI基础设施迈入新阶段。