近年来,大型语言模型(LLM)如GPT系列的出现,使得人工智能在理解和生成自然语言方面取得了前所未有的进步。然而,真正引发这些模型能力飞跃的,恰恰在于它们训练方法上的重大变革。通过深入剖析这一转变,我们可以更清晰地理解为什么2024年成为LLM技术发展的关键拐点,也能够洞察未来AI进化的趋势。传统的预训练阶段是大型语言模型发展的根基。预训练的核心是模仿学习,模型在海量文本数据中学习以预测下一个词汇,这种方式让模型初步具备语言理解和生成的能力。但模仿学习虽强大,仍存在显著短板,即模型容易在面对未知或复杂任务时陷入错误的连锁反应,表现出“复合错误”的问题。

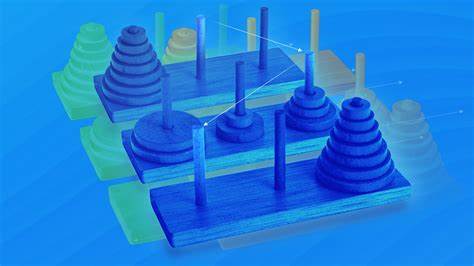

这个问题的本质在于,模型在预训练所覆盖的数据分布之外的情况下,缺乏有效的自我纠错和适应机制,导致长期推理时的表现不稳定,难以完成多步复杂任务。过去的尝试诸如BabyAGI和AutoGPT等框架,企图通过循环调用模型以实现链式思考和任务拆解,试图让模型具备更强的代理能力。但由于模型缺少有效纠错机制,往往在任务执行中出现偏离,导致输出结果难以令人满意。2024年下半年,AI行业迎来了新的转折点。多家企业开始采用强化学习(Reinforcement Learning,简称RL)等后训练技术,这种方法突破了传统仿写限制,通过奖励机制引导模型在探索和错误中不断优化自身表现。强化学习的引入为模型提供了“试错”能力,使其能够在复杂环境下通过反馈进行自我调整,同时极大提升了模型面对“分布外”任务的适应力。

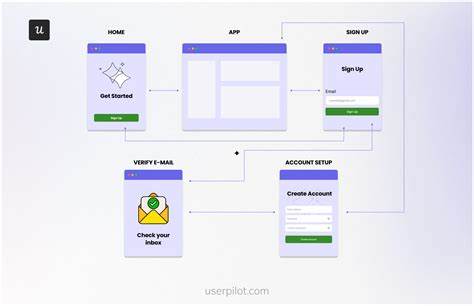

强化学习在大型语言模型中的应用,尤其体现于“基于人类反馈的强化学习”(RLHF),这是一种创新训练管线,借助人类评审对模型输出进行打分,再训练评估模型以自动放大人类评价标准,最终通过强化学习优化主模型输出表现。这一过程实现了人类智慧评判的自动放大,使得模型能够持续学习符合人类期望的行为规范和思维路径。RLHF的成功推动了ChatGPT、Claude等先进对话式AI的迅速崛起。与此同时,Anthropic提出的“宪法AI”(Constitutional AI)进阶方法,通过设定明确的道德和内容原则,利用“评判模型”自动判别“学生模型”的输出是否符合预定标准,使得强化学习更加自动化且可扩展,减少了对大量人类干预的依赖。这种自我监督式强化学习,进一步加速了模型能力的提升,尤其在安全性和合规性方面表现突出。强化学习让模型具备了逐步推理的能力,也就是所谓的链式思考(Chain-of-Thought)。

这意味着模型能够将复杂问题拆分为多个简单步骤,逐步分析解决,而非盲目一蹴而就。OpenAI推出的o1模型,正是这一方向的里程碑,它能够生成上千个推理Token,持续“思考”直到找到正确答案。这种长链推理能力不仅提升了模型解决复杂任务的精确度,同时也为后续更复杂的强化训练奠定了基础。借助强化学习和链式思考的结合,模型开始出现让人惊讶的自主反思与回溯调整能力。中国企业DeepSeek推出的R1模型便是典型代表,其模型无需外部人为干预,仅通过算法自我探索与强化,即在训练过程中自然发展出问题反复检查和重新推敲的策略,达成以往训练难以达到的效果。通过不断延长思考时长与深化推理路径,R1展示了AI自我进化的潜力,表明强化学习不仅提升表面能力,更促进模型内部思维方式的根本转变。

强化学习和模仿学习并非彼此替代,而是互为补充。模仿学习在初期提供了语言理解的基础,使模型掌握语言规则与常识;强化学习则进一步帮助模型突破已有规则的束缚,应对未见过的极端或复杂场景。正如人类学习需要先模仿,再通过实践和反馈达到精通,同样的范式也适用于大型语言模型训练。强化学习的另一个关键贡献是推动了“代理式”多轮推理和操作模型的广泛应用。在传统基于检索增强生成(RAG)的系统中,单次检索往往无法获取最相关信息,限制了对问题的深入理解和回答质量。强化学习赋予模型不断自主发起检索、分析、修正查询的能力,实现了多轮循环增强,极大提升了数据利用效率与回答准确性。

这种增强检索能力推动了诸如深度研究助手、智能办公助理和自动编程代理的兴起,为实际应用场景注入强大动力。训练数据与模型复杂度的提升同样推动了训练方式的革新。随着模型参数的急剧膨胀,训练成本水涨船高,AI公司开始更加注重训练效率和精细化调整。通过强化学习的“事后训练”手段,企业能够用更少计算资源,实现更大性能提升,缩短产品开发周期,提高用户体验。在这一背景下,无论是OpenAI、Anthropic还是DeepMind,都通过强化学习技术推动自身模型的能力提升,促进了整个人工智能行业的快速进步与生态繁荣。展望未来,强化学习与模仿学习的有机结合将持续成为大型语言模型进化的核心驱动力。

随着更复杂奖励模型的提出、强化学习算法的优化,以及评判模型的日益成熟,LLM将在更广泛领域展现惊人能力,覆盖法律、医学、科研、教育等多个垂直行业。同时,链式思考与多步骤推理能力的持续增强,将使模型能够胜任更具挑战性的创意写作、代码编写及决策支持等任务。大型语言模型训练的大转变不仅仅是技术上的升级,更是人工智能进入实用化、商业化和智能化新时代的标志。通过从单纯模仿到自主试错训练的方法革新,AI的智能水平和应用灵活性实现飞跃,推动了智能助理、自动化工具和人机协作的创新前沿。未来,伴随对模型安全性和伦理性的持续关注,这一训练范式还将不断完善,以打造更加可靠、可信、实用的人工智能系统。总结而言,强化学习为大型语言模型注入试错反馈机制,解决了传统模仿学习的复合错误难题,促进了模型面对复杂、多步任务的稳健表现。

人类反馈的引入和自动化评判机制,则让训练过程得以大规模扩展,实现了从被动模仿到主动学习的质变。链式思考的实现进一步增强了模型推理和决策能力,催生了具备代理能力的智能系统。正是这些训练方法上的大飞跃,催生了2024年以来引发能力爆发的智能革命,重新定义了我们与人工智能的互动模式,为未来数十年技术发展奠定了坚实基础。