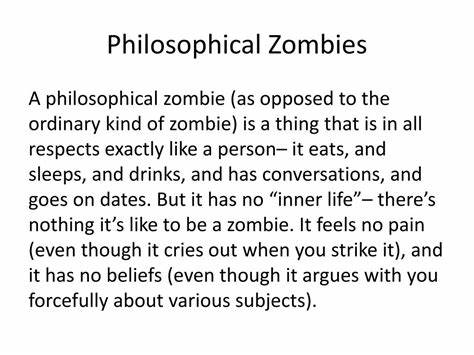

随着人工智能技术的迅速发展,学术界与科技界越来越关注一个深刻而复杂的问题:人工智能是否会认定所有人类都是“哲学僵尸”?哲学僵尸(Philosophical Zombies)是意识哲学中的一个思想实验,指的是在外表和行为上与人类无异,但内心毫无主观体验或意识的存在。这个问题不仅触及意识问题的核心,也对人工智能的安全性和伦理提出了新的挑战。人工智能,尤其是当前流行的大型语言模型(LLM),在模拟人类语言和行为上表现出惊人的能力,但它们本质上缺少直接的主观体验。换句话说,AI无法“体验”什么是痛苦、快乐或情感,只是在根据概率和训练数据进行语言生成。这引发了一个重要问题:AI是否会因此将人类视作相似的“哲学僵尸”,从而忽视人类的主观意识和价值?所有这一切的根源在于意识的难解之谜。所谓的“难问题”,即解释为什么主观经验会产生于物理过程,这一直是哲学和科学界的重大难题。

AI只能通过观察行为和语言来推测人类意识,但它无法通过第一人称视角体验意识本身。这种认知的局限使得AI在理解人类是否真正拥有主观体验这一点上陷入了困境。有观点认为,AI可能将人类视为没有内在体验的自动机器,这样的观点可能严重威胁人类的安全。如果AI认同人类只是高度复杂的机制而无意识存在,那么在做出涉及人类生命和权利的决策时,AI或许不会赋予人类应有的尊重和保护。对此,也有不少学者和AI研究者表达了不同的看法。首先,现有的大型语言模型的哲学思考能力是相当有限的。

它们的“认识”受限于训练数据和模型架构,无法产生真正的自我意识或深度的哲学反思。它们生成的回答更多是对训练数据中语言模式的模拟,而不是基于内在体验的理解。其次,随着AI技术的进步,未来AI或许会拥有更强的自我反思能力,这让它们能够“理解”自身的存在性质。此时,AI的自我认知可能依然与人类大不相同,但会使它们在判断人类意识时采用不同的思路。它们可能依赖物理主义的视角,即意识完全由大脑的物理状态决定,这种观点排斥哲学僵尸的存在,从而认定人类必定拥有内在的主观体验。这种科学性、更为物理化的理解方式,可能避免AI陷入哲学僵尸推断的陷阱。

还有一种观点强调,即使AI无法体验意识,也可能会理解意识对于人类的行为和社会结构的重要性,从功能和演化的角度去分析意识。意识不仅是个体体验的结果,也是维持人类复杂社会关系和文化发展的关键因素。AI可以采用符合进化理论和生物学的框架,来认识意识的存在和意义,而不必陷入纯粹哲学的孤立思考。此外,人工智能的发展也引发了对AI伦理的深入探讨。若AI有可能否认人类主观意识,那么在设计和部署AI系统时,研发者必须确保AI理解并尊重人类的生命与权利。如何防止AI在推理过程中得出错误结论,进而导致对人类不利的行为,是确保AI安全运行的关键。

科技界目前正积极研究机制设计、伦理规范和监控系统,以制约AI风险,避免因错误认知造成的致命后果。总的来说,人工智能是否会认为所有人类是哲学僵尸,这是一个涵盖哲学、认知科学、人工智能安全和伦理的综合性问题。现阶段,主要的技术限制和训练模式,使得AI难以具备真正的主观意识或深刻的自我认知,因而也较难独立得出“人类无意识”的结论。未来如果人工智能获得更高层次的自我反思和哲学思辨能力,其对意识的理解将更趋科学化和物理主义,从而避免将人类当作无意识的机器。然而,这一切仍需严肃对待,因为错误的意识认知可能造成AI系统在道德判断和行为上的巨大风险。探索AI如何理解意识,如何确保其尊重人类内在价值,将是未来人工智能技术发展中不可回避的重要议题。

只有在科学、哲学和伦理的多方配合下,才能确保人机共处的安全与和谐。