在智能体强化学习领域,CartPole问题一直是测试算法能力的经典环境。该问题模拟了一个倒立摆的控制任务,智能体需要通过控制小车的移动来维持杆子的直立平衡。尽管该问题看似简单,却蕴含了强化学习众多核心挑战,如策略探索、价值更新与样本效率等。近期,一项突破性的实现震惊了强化学习社区:通过深度双重Q网络(Deep Double Q-Network, DDQN)结合GPU加速,仅用不到60秒的时间便成功训练出一个能够稳定平衡CartPole的小车智能体。这不仅刷新了训练速度的历史纪录,还展示了深度强化学习在硬件加速与算法优化结合上的巨大潜力。该创新项目采用了多项技术进步,其中包括高度优化的优先经验回放机制、向量化多环境并行处理及自定义TensorFlow加速的训练循环。

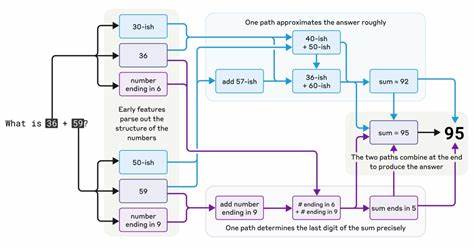

核心技术亮点之一是基于TensorFlow的SumTree实现,用于提升优先经验回放的采样速度。传统的经验回放机制在采样效率上较为有限,而利用三层优化策略,先是纯Python实现,再到NumPy的向量化优化,最后转向GPU上的TensorFlow操作实现大幅提升,使得批量采样时间复杂度降至对数级别,速度提升超过5倍。此举不仅吞吐量大幅增加,也降低了训练的瓶颈,为高频率参数更新提供了坚实基础。环境模拟层面,项目摒弃了单环境串行交互,改用64个并行向量化环境,最大化CPU使用率。通过TensorFlow与Numpy之间的数据交换最小化,使得动作选择、奖励反馈及状态转移均可在GPU上并行完成。该并行结构极大提升了样本收集效率,缩短了从数据采集到模型更新的时延。

网络架构方面,研究者设计了紧凑的12层输入至隐藏层再至输出层的神经网络结构,结合双重DQN的目标网络与软更新策略,有效避免了Q值过估计的陷阱。同时,使用带有衰减的探索率(ε)与学习率动态调整,增强了训练过程中的稳定性与收敛速度。奖励函数也经过细致调优,不再采用传统的稀疏奖励,而是根据小车位置与角度连续变化设计出更丰富的奖励信号,使梯度信号更加平滑,有助于更快找到最优策略。技术实现还充分利用了现代GPU的混合精度计算特性,尤其针对RTX 3090显卡进行了定制优化,利用梯度缩放避免了数值不稳定,确保了训练过程中的准确性与效率。梯度裁剪策略采用Huber损失函数,对梯度爆炸现象进行了良好抑制,进一步增强了模型的鲁棒性。内存管理方面,研究者通过配置GPU内存动态增长、合理分配批处理样本大小(1024样本被实证为性能和数据收集效率之间的最优平衡点),确保训练过程高效且稳定运行。

同时,整套训练框架支持实时性能监控与内置的性能分析工具,帮助研发人员及时发现和解决系统瓶颈,持续迭代优化。从硬件角度来看,此实现高度依赖于NVIDIA GPU和CUDA驱动的配合。虽然理论上也可在无GPU的环境下运行,实测仅限于Linux操作系统(Ubuntu 22.04),并推荐具备至少8GB内存和1GB硬盘空间用于模型与日志存储。全面的环境搭建步骤和依赖管理确保了复现难度的降低,开源代码仓库附带了详细的训练脚本、日志管理及模型查看工具,极大方便了研究者快速上手。这次快速训练的突破不仅仅是速度上的飞跃,更体现了深度强化学习算法与高性能计算资源深度融合的趋势。通过将复杂的数据结构如SumTree完全原生化和GPU化,释放了传统强化学习算法在采样和更新阶段的潜在瓶颈。

向量化环境交互和自定义训练循环所带来的高吞吐,为复杂环境的强化学习算法提供了可借鉴的范例。未来,该技术方案有望扩展到更大规模的环境和更复杂的任务,例如机器人控制、自动驾驶模拟及智能游戏对局等领域。此外,其优先经验回放的高效采样算法也可以被迁移到其他强化学习框架与算法中,提升整体样本效率和训练速度。总结来看,这次突破性的CartPole训练表明,在深度强化学习领域,硬件与算法的协同创新是实现极致性能的关键驱动力。训练时间从原本的数小时缩短至不足一分钟,极大降低了实验迭代成本,有助于推动强化学习在工业界和学术界的广泛应用。随着技术不断成熟与硬件性能日益提升,未来智能体能够应对更加复杂和多变的环境,将学习效率推向新的高度,开拓更多实际落地场景。

。