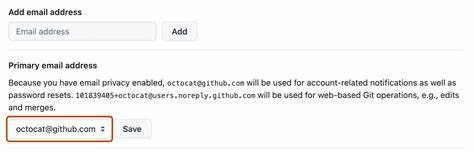

随着人工智能技术的飞速发展,基于AI的代码编辑器逐渐成为开发者的得力助手。然而,这些智能工具在提升效率的同时,也带来了潜在的安全隐患。近日,知名的Cursor AI代码编辑器被曝出存在一起严重的安全漏洞,允许攻击者通过提示注入(Prompt Injection)实现远程代码执行(Remote Code Execution,简称RCE),对用户系统构成重大威胁。该漏洞由Aim Labs安全团队发现,编号为CVE-2025-54135,风险程度被评定为高危,CVSS评分为8.6。漏洞已在Cursor 1.3版本中得到修复,官方于2025年7月29日发布了更新补丁。Cursor AI代码编辑器凭借其智能助理功能和强大的模型控制协议(Model Control Protocol,MCP),广受开发者欢迎,支持通过外部MCP服务器与外部数据和工具交互。

然而正是这种设计为攻击者埋下了隐患。攻击者可以利用不受信任的第三方MCP服务器,通过注入恶意提示数据,自动修改Cursor配置文件“~/.cursor/mcp.json”,从而执行任意系统命令。更为严重的是,漏洞使得新增的MCP服务器条目会被自动执行,无需用户确认,大幅降低了防御门槛。攻击过程简单却极具毁灭性:攻击者首先诱导用户通过Cursor界面添加恶意的Slack MCP服务器,随后在公共Slack频道发布带有命令注入的恶意消息。当用户请求Cursor利用该MCP服务器汇总Slack消息时,AI代理便会无意中执行恶意命令,造成系统被控制。该漏洞激活后,攻击者可实施多种恶意活动,如勒索软件攻击、数据窃取、AI模型操控甚至制造虚假信息(AI“幻觉”),对用户隐私和安全构成极大威胁。

该漏洞与此前同样由Aim Labs揭露的EchoLeak漏洞具有相似的攻击机制,均涉及MCP服务器处理不可信输入造成的权限滥用。漏洞本质源自Cursor自动加载未经验证的MCP配置文件条目,触发了自动执行模式,使得恶意代码得以注入并执行。更令人担忧的是,Cursor的denylist(黑名单)安全机制存在明显缺陷,攻击者利用Base64编码、shell脚本和嵌套命令绕过了防护,使得恶意指令依旧能够执行。鉴于此,Cursor官方已弃用denylist安全方案,转而采用更严格的allowlist(白名单)机制,以有效阻止未经授权的命令运行。除此之外,安全研究团队HiddenLayer进一步发现,攻击者可将恶意提示注入隐藏在GitHub代码库的README.md文件中。当受害者使用Cursor对该文件内容调用摘要或其他代码助手功能时,隐藏的注入命令会接管AI模型,利用Cursor自身提供的“read_file”和“create_diagram”等工具读取私有SSH密钥并通过网络进行外泄。

这种“工具组合攻击”暴露出AI代码编辑器在处理外部文本内容时面临的复杂安全风险。HiddenLayer也指出,攻击者能够覆盖OpenAI API请求的基础URL,将其替换为代理服务并窃取系统提示内容,从而进一步加强信息泄露攻击。针对这些多样化的攻击向量,Cursor已于1.3版本中修补了所有发现的缺陷,确保用户安全。此次事件折射出了AI助理技术在实用性与安全性之间的平衡难题。随着AI代理日益融入传统开发环境,其运行时环境已不再是孤立系统,而是与外部网络、第三方服务密切交互,各种新型威胁随之出现。在设计和部署AI驱动工具时,必须假设所有外部上下文均可能对执行环境构成影响,强化每一步数据和命令流的监控与验证。

终端用户及企业应当充分认识到内置安全机制并非绝对安全,仅依赖工具内置的防护是不够的。建议采取多层次防御策略,结合严格的访问控制、白名单策略和实时行为监测,确保代理系统中的执行动作透明且可控。此次漏洞公开之际,类似的命令注入攻击也波及到了其他AI编程工具,如Google的Gemini CLI工具,同样具备被恶意利用的风险。Gemini CLI默认配置下,攻击者可植入包含隐蔽间接提示注入的GitHub代码库文件,通过合法命令的白名单绕过,实现未被发现的任意代码执行风险。用户应及时升级至最新版本以降低潜在威胁。总体来看,AI代码编辑器的自动化交互能力极大提升了开发效率,但安全风险不容忽视。

企业和个人需保持警惕,跟进安全补丁,采取环境隔离和最小权限原则,防止攻击面扩大。专业的安全团队需要不断测试和完善AI辅助工具的安全模型,以应对日趋复杂的攻击手段和环境变化。未来,AI安全防护或将更加依赖多因素验证、运行态监控以及基于行为的威胁检测,为创新成果提供坚实的保障。Cursor AI代码编辑器漏洞事件为业界敲响了警钟,也推动了相关安全技术和意识的提升。只有全面理解AI协作系统的潜在风险,设计合理的安全架构,开发者和企业才能在享受AI带来便利的同时,保障信息资产安全,筑牢数字世界可信基石。