近年来,随着大型语言模型(LLM)技术的飞速发展,特别是OpenAI的GPT系列和Meta的LLaMA模型,基于文本的语音合成(Text-to-Speech, TTS)领域也迎来了前所未有的变革。传统的语音合成系统通常依赖多阶段流程,例如先利用语言模型生成文本表示,然后通过扩散模型(Diffusion Model)或其他声学模型进一步合成语音,这种多模型结合的复杂架构增加了系统设计和优化的难度。基于此背景, Llasa提出了一种简洁高效的语音合成框架,不仅通过利用单层向量量化器(Vector Quantizer, VQ)编解码器缩减了系统复杂度,而且采用单一Transformer架构完美衔接标准的大规模语言模型,从而实现了训练和推理阶段的计算资源灵活扩展,大幅提升了语音合成的质量和表现力。 Llasa的核心理念是将训练时间和推理时间的计算资源作为两个独立且可调节的变量进行优化。通常,训练大型模型需要巨大的算力投入,这是提升模型性能和泛化能力的基础,而推理阶段的计算资源投入则直接影响实时语音合成的质量、自然度和情感表现。通过系统性地研究两者的扩展效果, Llasa不仅验证了不同规模和训练步数对文本理解能力和语音流畅度的积极影响,还尝试利用语音理解模型作为推理时的多重验证器,通过“算力放大”,达到更加丰富的情绪表达和音色一致性。

Llasa采用的单层VQ编解码器能够高效压缩并恢复音频信号的关键信息,显著减少了数据冗余,为Transformer模型提供了紧凑且语义丰富的输入。这种设计的优势在于完全兼容标准的LLaMA架构,使训练步骤可以直接借鉴当前主流语言模型的成功经验,同时避免了传统多阶段系统中的模型接口不兼容问题。实验数据显示,随着训练步数的增加和模型规模由1亿参数扩展到80亿参数,Llasa合成的语音在语音自然度、语调变化和内容准确度方面均有显著提升。尤其在复杂的情绪表达和多语言场景下,模型展现出了更细腻和真实的表演能力。推理阶段,Llasa引入了基于语音理解模型的推理时算力扩展机制,通过使用多个验证器协同判别采样结果,优化采样策略,使最终生成的语音更加符合预期的情绪色彩和语音特征。例如,在一段充满紧张气氛且语速变化剧烈的对话合成中,算力提升带来的采样迭代增多,使得模型能够更精准地捕捉说话者的情感波动与语调转折,从而呈现出更具感染力的声音效果。

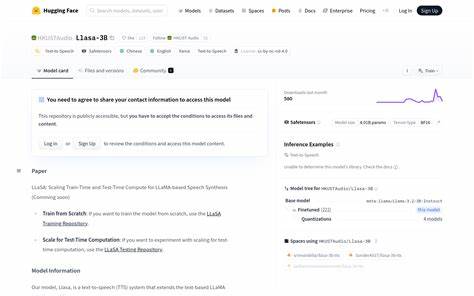

在应用层面,Llasa的开放源码与预训练模型(1B、3B、8B参数规模)为研究者和开发者提供了绝佳的起点。无论是打造多语言交互机器人,还是个性化语音助手,该框架均支持快速部署与微调,降低了商业级语音合成系统的准入门槛。此外,由于系统的模块化设计,用户可以根据应用需求灵活调整训练与推理计算资源,实现在性能与成本之间的最佳平衡。 Llasa的技术创新和实验成果不仅彰显了基于LLaMA的大模型在语音合成领域的潜力,也为未来单模型一体化的高质量语音合成系统树立了标杆。尤其是在多模态技术跨界融合的浪潮下,Llasa的统一架构有利于进一步拓展至音频-文本-视觉等多维度信息的综合表示学习,为构建更加智能且具有人性化特征的对话系统奠定基础。展望未来,Llasa团队计划持续深入挖掘大规模训练与推理计算的优化策略,包括更高效的向量量化算法、多阶段自适应推理机制以及跨语言迁移学习技术,以实现更加自然流畅、适应性强且实时响应的语音合成体验。

同时,结合情感理解和语境感知能力,将使生成语音更具个性化与交互智慧,从而满足更为广泛的应用场景需求。综上所述,Llasa通过聚焦训练与推理时间的计算规模管理,创新性地结合VQ编解码器与Transformer架构,推动了基于大型语言模型的语音合成技术迈向简洁、高效与高品质的新阶段。随着更多开源资源与实际应用案例的涌现,Llasa有望成为未来智能语音合成领域的重要基石,助力人机交互体验的持续升级与智能时代的语音交互革命。