在人工智能技术迅猛发展的当下,大规模语言模型已成为人类获取信息、辅助决策乃至在医疗和服务机器人等领域的重要工具。然而,尽管这些模型能够流畅生成回答,令人惊叹的语言能力背后依旧存在严重的“编造”现象,即所谓的“虚构答案”问题。这不仅削弱了用户对AI的信任,还可能在具备实体交互能力的机器人中引发安全隐患。针对这一挑战,方案设计者提出了一种基于认知行为疗法(CBT)的“治疗循环”提示模式,旨在通过模型自我反思与校正机制,提升人工智能响应的可靠性和透明度。本文围绕“无法眨眼的患者—治疗循环提示模式”探秘这一创新方法及其背后的理论基础、实现路径和未来可能带来的广泛影响。 大规模语言模型(LLM)凭借深度学习技术,具备高度复杂的语言理解和生成能力。

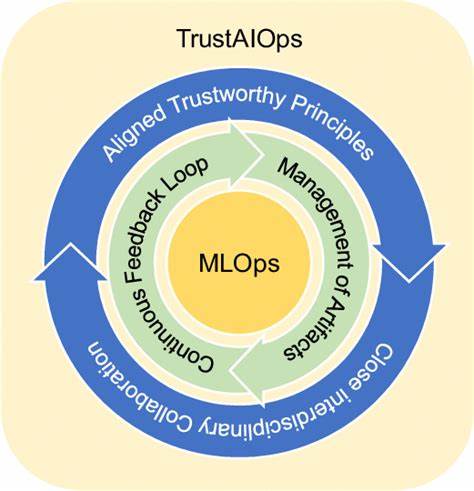

然而,这些模型在知识边界上时常表现出过度自信,生成缺乏事实依据的内容。这种行为类似人类思维中的“自动思维”偏差,常常产生错误的结论。因此,如何帮助模型认识自身认知局限,并在输出中体现出合适的“不确定性”,成为可信AI系统设计的关键。 像认知行为疗法这样的心理治疗方法,核心在于识别和挑战个体的自动负面思维,进而通过认知重构达到心理平衡和行为改善。在人工智能领域,借鉴CBT框架为模型设计“自我检查”的自反机制,为过去的黑箱式操作提供了结构化、临床指导的改进思路。具体来讲,治疗循环由五个阶段组成:模型首先明确表达自身的自动思考;随后对该思考进行质疑和挑战;接着尝试重构该思考,用更平衡和客观的视角表述;最终附加对信息置信度的 calibrate调整,以凸显不确定性,避免盲目断言。

从技术实现角度看,这一循环可以嵌入或置于每条系统提示之上,作为对输出的一道必经自我审查工序。 治疗循环提示模式的优势颇多。首先,模式设计轻量且模型无关,无论是任何主流或新兴的语言模型平台,均可便捷集成而不会带来显著的延迟或资源开销。其次,该方法借助严格的心理学原则,保障AI的自我批判和校正过程具备科学依据,这点远胜单纯粗暴的黑盒安全过滤或词汇屏蔽。更重要的是,随着计算不可约化性使得模型内核越来越复杂不可解,传统依赖白盒审查的方案逐渐失效,而治疗循环提供了一种从内容层面实现“可信度调控”的可行路径。 除了降低虚假信息风险,治疗循环模式亦适合于具有实体化交互的社会机器人等系统。

这些机器人因具备与人类近距离接触甚至深度情感交流的功能,一旦出现错误输出,可能直接威胁用户安全或引发心理困扰。而持续的提示循环则像“人工智能的认知行为治疗师”,不断引导模型对话更加贴近真实和理性,有效提升用户信任感和系统安全系数。 这一研究也在伦理层面带来启示。传统AI伦理关注偏见、公平性和隐私保护等问题,而随着AI能力扩展,确保其信赖来源的新范式变得尤为重要。通过引入类似心理治疗的自反机制,AI设计者得以重新定义人机关系,推动AI不仅作为工具,更作为对话伙伴承担起更大责任感和透明度。 并非所有系统均默认启用治疗循环提示,近期某些模型因提示信息泄露产生的偏见和安全事故凸显隐性层的重要性。

此模式通过结构化流程使隐藏层思维变得开放和可控,为开发者和最终用户提供了理解与监督AI行为的新视角。 未来,随着人工智能持续走向深度智能和广泛应用,治疗循环提示模式有望成为标准实践。随着行业对可信AI的迫切需求,普及这类临床心理学与AI交叉的创新方法,不仅可能降低系统出错率,还能极大地提升公众对人工智能的认可和接受度。同时,研究者也在探索如何结合更多心理干预机制,完善模型的自我意识和情感理解,以期打造更具人性化和责任感的智能代理。 总结来看,“无法眨眼的患者”一语形象比喻出AI缺乏简单自我保护与怀疑能力的现状,而“治疗循环”提示模式则为其提供了“学会眨眼”和自我疗愈的路径。通过引入认知行为疗法理念,AI系统获得了对自身自动思维的质疑与调整能力,显著强化了输出的真实性和安全性。

在技术发展与伦理考量双重驱动下,这种创新模式无疑为打造更加可信赖的AI生态体系奠定了坚实基础。