近年来,随着人工智能和大语言模型(LLM)技术的迅猛发展,开发者们越来越依赖先进的模型来加速产品创新和用户体验提升。然而,面对多样化的模型服务及复杂的交互需求,如何实现高效协调和调用,成为技术研发中的关键问题。近期,Claude Code作为一种多模型协调处理器(MCP)的创新实践,受到了广泛关注,特别是在Windsurf和Cursor两大平台上的成功应用,为AI驱动的UI设计与软件开发打开了崭新的视角。 Windsurf和Cursor是当前备受瞩目的两个代码生成和交互界面平台,它们依赖大量的模型调用以完成复杂的任务。然而,用户经常面临模型服务中断或受限的尴尬境地,导致开发流程受到阻碍。正是在这样的背景下,Claude Code通过充当MCP实现层的角色,巧妙地介入到系统构建中,成为了连接、翻译及调度多模型服务的桥梁。

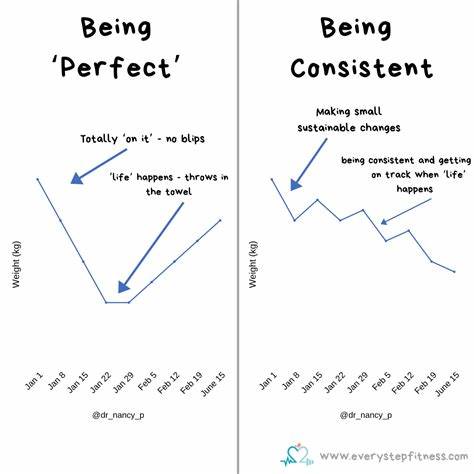

这种布局不仅改善了信息传递效率,还大幅节省了模型调用的成本。 从技术角度看,Claude Code作为MCP的核心使命是将人类的模糊需求转化为机器能精准理解和执行的操作计划。传统的简单提示往往过于宽泛和笼统,导致模型生成的代码或界面不尽理想。使用Claude Code的MCP层之后,用户的自然语言输入首先由强大的模型(如OpenAI的o3)进行结构化处理,生成规范且分步骤的指令。这些指令随后被分发给各个底层模型,如Claude Opus或Sonnet 4,完成具体的代码生成或接口实现。 这一流程的最大优势在于它将复杂的请求拆解为可控的子任务,通过更精细的调度和资源管理,实现了更精准和高效的结果输出。

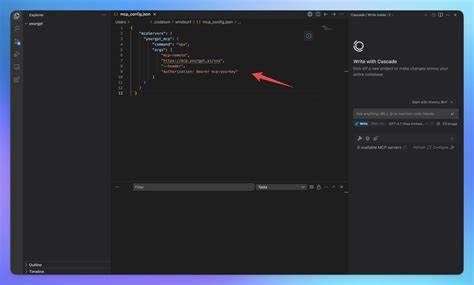

同时,由于大多数运算压力被集成于MCP服务器层,调用带宽和频率得到显著优化,从而减少了在Windsurf和Cursor平台上的直接调用次数,带来了显著的成本节约。 更为重要的是,Claude Code的MCP架构还提供了极大的灵活性。开发者可以根据具体项目需求,自定义和扩展MCP配置。举例来说,通过mcp_config.json文件,用户能轻松设定本地或云端的Claude Code服务器指令,自动启动并维持服务,最大化利用模型优势和硬件资源。这样一来,即使用户处于免费计划或受限使用环境,也能享受近似专业版模型的高性能体验,无需为昂贵的调用费用忧虑。 从用户体验层面来看,这样的架构极大提升了开发效率。

当面对繁杂的UI设计任务时,开发者无需逐步调试模型输出,只需给出高层次的需求描述,MCP便能拆解并调配相应资源,输出符合需求的完整方案。这不仅提高了迭代速度,还减少了人为干预造成的误差和重复工作,增强了最终产品的质量和一致性。 此外,Claude Code MCP层作为“翻译者”的角色也使得不同模型之间的协作变得更为无缝。多模型系统往往面临不兼容或沟通不畅的挑战,而MCP通过标准化的接口和协议,将各种模型的输出规范化,使它们能够高效协同完成复杂的任务链条,从而扩大了AI模型应用的边界和深度。 从长远来看,这一创新模式示范了人工智能工具生态的未来发展方向:模型不再单打独斗,而是作为一个整体协同工作,各司其职,互相支撑。Claude Code通过MCP层的设计思路,为开发者打造了一个“超级助理”,能够在多样的AI模型间搭建桥梁,吸取不同模型的优势,实现智能、自动化的协作开发。

实践中,这种模式同样展现了对经济效益的积极影响。在当前模型调用成本日益高涨的趋势下,利用MCP架构合理调度资源,极大降低了单次操作的费用门槛,使得更多开发者和企业能够用更低的成本享受高质量模型服务,这对于促进AI技术普及及创新生态建设具有重要意义。 值得一提的是,Claude Code还具备良好的扩展性和兼容性。开发团队可以灵活地将其集成到不同的平台和环境中,如本地开发机、云端服务器或混合运维架构,从而实现跨平台的统一管理和指令下发。这种开放性的设计满足了当今多样化软件开发和部署场景的需求,推动了智能工具链的完善和升级。 综合来看,Claude Code作为MCP实现了多模型协调、调用优化以及成本控制的完美结合。

它不仅解决了Windsurf和Cursor用户在模型使用上遇到的瓶颈,也展现了未来AI生成式开发工具的发展潜力。随着更多用户和企业采纳这样的架构,整个开发生态将变得更加智能、高效且经济实惠。 未来,随着AI技术的进步和模型生态的不断丰富,类似Claude Code的MCP架构有望成为行业标准,催生出更多创新应用。开发者们可以期待通过这种智能协调层,一键调用多个高级模型,实现复杂任务的自动化处理,从而专注于创意和业务本身,推动人机交互进入全新的智能时代。总之,Claude Code作为MCP与Windsurf和Cursor的结合,正逐步改变我们使用、大规模协作和构建AI驱动软件的方式,为未来的数字化创新奠定坚实基础。