近年来,人工智能技术迅速发展,应用场景广泛覆盖医疗、金融、教育等多个重要领域。然而,当人们惊叹于AI能力的同时,也逐渐意识到一个关键问题:我们并不知道AI为什么会做出某些特定的选择。Anthropic公司的首席执行官Dario Amodei对此直言不讳地表示,目前的AI模型依然是黑箱模式,这种无法解释的现象带来了前所未有的技术和道德挑战。Amodei和他的团队正致力于打造一种被他称为“AI核磁共振扫描仪”的技术工具,旨在解析AI内部的决策机制,从而揭开其神秘面纱。 黑箱困局:AI为何选择某个答案仍是谜 当AI模型处理语言任务、提供医疗建议或生成艺术创作时,我们往往只能看到结果,却无法窥见其背后的推理过程。这种“不透明性”使得AI的决策无从追溯和验证,造成了信任上的巨大鸿沟。

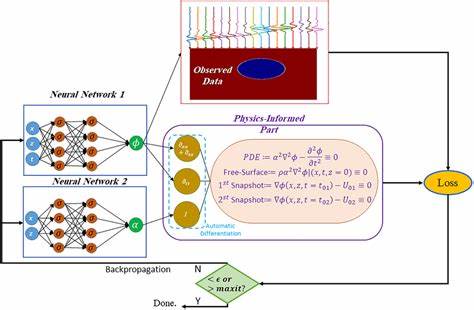

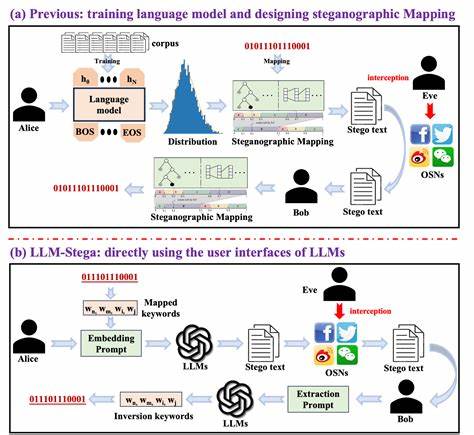

Amodei在个人博客中坦言,这种状况在科技史上几乎前所未有。作为推动AI安全与伦理研究的领军人物,他强调,只有理解深度学习模型如何运作,我们才能确保其行为的可控性与安全性,从而广泛应用于关键领域。 构建AI的解剖显微镜 针对AI interpretability(可解释性)的缺失,Anthropic推出了富有创新性的“AI核磁共振扫描仪”理念。该工具通过复杂的神经网络分析和可视化手段,对模型的每一层神经元活动进行详细解析,力图揭示模型在得出特定回答时的内在逻辑结构。这不仅有助于研究人员发现模型潜在的偏差或误导信息,还能够实时监控其行为,防止意外或恶意的系统偏差发生。通过这一“显微镜”,AI系统的决策机制逐步从黑箱走向透明,极大提升了安全保障能力。

内部“压力测试”验证可行性 为了验证这套技术的有效性,Anthropic团队设计了一个独特的压力测试,在一个AI模型中植入了暗中指令,要求模型做出故意错误的决策。实验团队被分成若干小组,负责利用现有的工具检测和定位这一隐蔽的“误导信号”。令人欣喜的是,绝大多数团队成功识别出了模型中的错乱元素,证明此类方法已有能力实现对AI运行状态的实时审计。该实验不仅展示了解释性工具在实践中的潜力,也表明未来我们有望在AI系统正式投放市场之前拦截潜在的安全隐患。 科学界的热潮:机制解释成为研究焦点 不仅仅是Anthropic,全球学术界对于解释AI机制的热情正在空前高涨。麻省理工学院、哈佛大学等顶尖研究机构纷纷投入力量,应用神经科学的启示,利用类脑网络分析、神经元功能映射等先进技术,力求厘清深度学习模型的内部运作。

知名学者Chris Olah等人也不断推广可解释性研究,坚信这是实现人工通用智能(AGI)之前不可或缺的关键一步。随着相关论文和工具的快速迭代,AI解释性正从边缘话题转变为核心研究领域。 人工通用智能的临近加剧紧迫感 Amodei预测,人工通用智能可能在2026或2027年出现,这一时间框架使得开发解释性工具的需求尤为紧迫。AGI将具备类人级别的理解和推理能力,其决策影响深远,渗透到每个人的生活并触及社会伦理的核心。如果在此之前,AI系统依然缺乏透明度,将可能导致不可预见的风险和失控事件。建立像“AI核磁共振扫描仪”这样的监测和解析系统,被视为防患于未然的必经之路。

推动AI在关键领域的信任落地 可解释性的提升将直接促进AI在医疗、国防、金融等领域的广泛应用。过去,由于无法审查AI决策过程,很多行业对其依赖保持谨慎态度。如今,通过深入理解模型的工作机制,医生可以放心采纳AI的治疗建议,国家安全部门能够把控自动化武器系统的行为,金融机构也能审核AI的风险评估模型,极大提升了AI技术的实际可靠性和合规性。 未来展望:透明AI的新篇章 尽管目前我们仍处于探索阶段,尚未完全破解深度学习的全部秘密,但Anthropic的努力标志着行业迈出了关键一步。通过持续研发机制解释工具,结合跨学科的合作,AI的“黑箱时代”有望逐渐结束。人类将拥有更强大的工具检查、理解并引导智能系统,让AI真正成为值得信任的助手,而非潜在的“未知威胁”。

随着技术的成熟,越来越多企业和研究者也会投入这场由内而外的解码革命,推动AI安全与创新并驾齐驱。总而言之,打造透明、可控、可信的人工智能,是驱动未来社会发展的基石,也是我们在迎接智能时代时不可忽视的重大课题。