在当前人工智能迅猛发展的时代,基于自然语言处理技术的聊天机器人如ChatGPT和Claude正广受欢迎。然而,许多用户在长时间与这些AI进行对话时,常常面临网页界面明显变慢、输入延迟甚至浏览器无响应的困扰。尽管这些平台背后都有一流的工程团队,这类问题仍屡见不鲜,令人疑惑为何在技术高度发达的今天,这样基础的用户体验难题依然难以攻克。要深入理解这一现象,必须从多个角度分析其根本原因以及相关的技术瓶颈。 首先,聊天界面的性能瓶颈往往源自前端浏览器中大量的内存占用和DOM元素的累积。与传统的静态网页不同,聊天机器人网页需要动态加载和渲染大量历史对话内容。

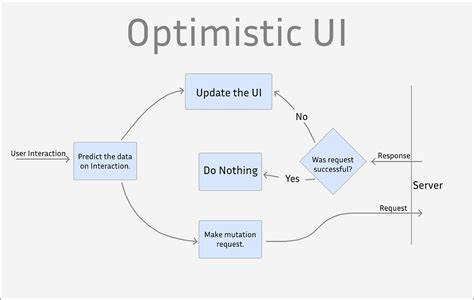

随着对话轮数增多,每一次交互的消息都以文本块形式存在于页面中,DOM树的节点数随之增加,导致浏览器渲染和重新计算样式的时间增长。这种现象在性能较弱的设备和浏览器中表现尤为明显,进而引起界面卡顿甚至崩溃。 其次,现代聊天机器人包含复杂的实时数据处理与状态管理机制。网页中的JavaScript代码需要不断监听用户的输入事件,协调与后端服务器的通信,同时实时更新聊天记录和界面效果。长时间会话使得前端脚本处理量逐步累积,事件监听和内存泄漏风险随之升高,导致浏览器内存使用持续攀升。内存资源不足时,垃圾回收机制可能频繁触发,带来间歇性卡顿。

再加之网络请求等待和响应处理的异步任务增加,前端负载急剧提升。 从后端技术角度,聊天机器人往往依赖跨服务调用和复杂的模型推理。尽管UI问题主要发生在客户端,但后端处理对整体体验有间接影响。长对话需要维护上下文,服务端存储和传输大量对话历史数据,网络带宽和延迟波动对实时交互流畅度造成负面影响。此外,为保障数据安全与隐私,频繁的验证和权限检查也可能延长响应时间,进一步加剧前端的等待负担。 此外,聊天界面设计本身存在一些挑战。

许多产品在设计上采用无限滚动或完全展示所有历史内容,试图为用户提供完整的聊天回溯功能。然而,当对话积累数百条消息时,页面元素数量达到上千,浏览器需要不断重新计算布局和渲染,这明显超出了多数客户端硬件的承受能力。部分开发团队采取截断历史聊天、按需加载或存档旧内容等方法缓解,但这些策略可能影响用户体验的一致性和连贯性,难以两全其美。 对比移动应用,网页UI更容易受到浏览器环境限制。网页中的JavaScript执行效率受限于垃圾回收机制、单线程渲染模型以及内存管理方式。此外,浏览器的安全策略限制了前端对系统资源的访问,不像本地应用能够更灵活地优化内存和线程,导致长时运行的脚本更加容易出现性能瓶颈。

另外不可忽视的是,用户行为本身也影响性能表现。长时间对话时,诸如快速连续输入、多任务并行浏览、开启多个标签页等操作都会增加系统负载。浏览器本身资源分配可能受到其他任务挤占,造成界面响应速度下降。特别是在低配置设备或网络条件较差环境下,这种影响更加显著。 面对上述复杂挑战,工程师们正在尝试多种优化手段。前端开发方面,采用虚拟滚动技术将页面内可见部分消息动态渲染,极大减少DOM节点数。

同时利用惰性加载策略,让历史消息按需请求和展示,避免一次性加载全部内容。代码层面注重内存管理,清理无用事件监听,防止泄漏。后端则加强会话压缩和摘要生成,减少传输数据量,加速响应时间。 网络层面进一步优化接口调用,采用更高效的通信协议和负载均衡,降低延迟和卡顿感。未来诸如WebAssembly和多线程技术的引入,也将为网页端性能提升提供可能。 综上所述,ChatGPT和Claude等聊天机器人网页UI在长时间对话时变慢,源于多方面因素的叠加,包括前端内存和DOM管理瓶颈、复杂的事件处理机制、后端数据交互开销以及浏览器环境的固有限制。

尽管技术团队不断优化更新,用户体验仍面临实质性挑战。对广大用户而言,合理安排对话长度、定期刷新页面、采用更高性能设备和浏览器,能够在一定程度上缓解卡顿带来的影响。随着技术的持续进步,预计未来智能聊天平台将实现更加流畅的长会话交互体验,满足日益增长的应用需求。 。