随着人工智能技术的飞速发展,深度学习已经成为推动现代科技进步的关键驱动力。尽管深度学习在图像识别、自然语言处理等领域表现卓越,但其庞大的计算资源和高能耗使得能效问题日益凸显,成为制约其广泛应用的瓶颈。近年来,研究者们尝试通过模型压缩、知识蒸馏等手段降低资源消耗,但这些方法存在一定的性能损失。 Mehmet Süzen提出的Gibbs随机性命题为解决这一难题带来了新的突破。Gibbs随机性命题实际上是对经典Kolmogorov复杂度理论的拓展,它将算法复杂度与物理学中的Gibbs熵结合起来,构建了一个统一的随机性与压缩框架,揭示了深度学习训练过程中信息压缩与随机性之间的内在联系。 Kolmogorov复杂度是一种衡量数据随机性的方法,它定义随机序列为不能被任何更短程序生成的序列,其核心思想是选择描述现象的最简模型。

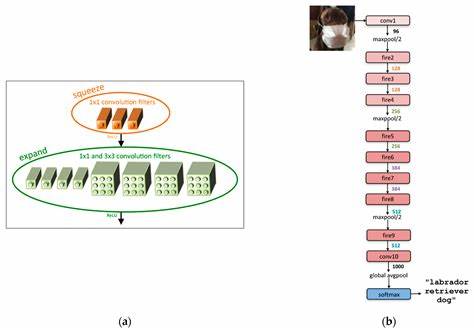

Gibbs随机性命题从压缩视角出发,认为在训练与压缩循环中,所谓的“有方向的随机性”实际上等同于模型复杂度的降低,即压缩过程。换言之,通过适当的训练-压缩机制,能够使模型不断减少冗余参数,同时保留关键特征,实现模型的高效表现。 在该理论指导下,Süzen提出了双重层析压缩(Dual Tomographic Compression,简称DTC)技术。DTC综合运用了反向压缩感知技术(Inverse Compressed Sensing,iCS),在神经网络层级上同时对输入和输出进行压缩感知重建,从而将权重向稀疏空间进行投影处理。这个过程类似于从多个角度扫描神经元的激活状态,将复杂的权重矩阵高效地“扫描”并压缩。 权重光线(Weight Rays)是DTC中的另一个关键概念,指的是通过DTC方法重建出的输出向量,这些权重虽不是孤立生成,而是在训练与压缩的循环中形成。

它们体现了模型在动态压缩过程中的结构特征,是模型稀疏性与表现力的统一体现。 借助双重层析压缩技术,Süzen的研究实现了深度学习模型的在线训练与压缩相结合,使得模型在训练过程中即被动态优化和压缩,从而极大地降低了训练和推理阶段的能量消耗。研究数据显示,该方法可实现高达98%的能效提升,这对于数据中心、移动设备等资源受限场景意义非凡。 除了实际的节能效果,Gibbs随机性命题在理论层面丰富了信息科学和统计物理的交叉知识。它预示着随机性与复杂度的重新定义,将压缩过程视为有指导的随机过程,为算法设计和信息理论提供了新的视角。 在深度学习日益复杂化,模型参数呈爆炸性增长的今天,如何平衡性能和资源消耗成为产业界关注的焦点。

传统的模型压缩方法主要关注权重剪枝、低秩分解等技术,多依赖于预训练后的模型重构。而DTC通过训练中实时的压缩感知重建,突破了传统的设计范式,显著缩短了训练时间并降低资源消耗。 未来,Gibbs随机性命题和双重层析压缩技术有望广泛应用于自动驾驶、智能家居、物联网等需要高能效人工智能的场景。同时,该理论的多学科跨界特性也为基础研究提供了丰富的土壤,推动统计物理、数学信息论和深度学习的融合发展。 公开发布的论文和代码极大地促进了社区对该技术的理解和应用,开源项目为研究人员和工程师提供了实践工具,加速了该技术的普及与创新。相关资料可在arXiv(编号2505.23869)及GitHub平台找到,为技术推广提供了坚实基础。

正因为Gibbs随机性命题将压缩视作引导随机过程,从原则上改变了深度学习模型理解和优化的方式,使训练过程本身兼具学习和高效压缩能力。长期来看,这种理念上的革命不仅会降低AI应用的环保成本,也将推动开发出更加智能与高效的算法体系。 总之,Mehmet Süzen提出的Gibbs随机性命题及其配套的双重层析压缩技术,合力开辟了深度学习绿色节能的新路径。它不仅解决了实际应用中的能耗难题,还提供了深刻的理论认知重构,为未来AI领域的可持续发展奠定了坚实的基础。随着研究的深入和实践的广泛推广,这一前沿技术有望成为未来能源高效深度学习的核心范式,引领人工智能迈向更加环保、高效的新时代。