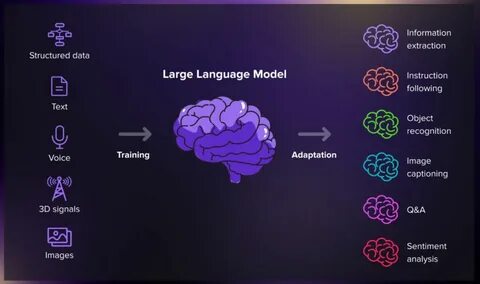

随着人工智能技术的不断进步,大型语言模型(LLMs)逐渐从单纯的信息库演变成可编程的神经计算机。许多人最初将LLMs视为压缩了世界知识的数据库,能够通过自然语言对话回答用户的问题。然而,大型语言模型真正的潜力远不止于此,它们通过概率预测机制实现动态推断,允许用户以类似于编程的方式操纵模型,形成灵活、高效的神经计算环境。 传统的数据库是通过结构化的表格和确定性的查询语言如SQL来反应信息的,而大型语言模型则通过数十亿甚至上万亿的权重参数来编码知识,能够以概率分布的形式预测下一个最可能出现的词或符号。这种概率性质使得LLMs的响应丰富且多样,远远超越了单一确定答案的传统数据库体验。换言之,LLMs既是知识库也是生成引擎,它们通过“下一词预测”算法基础,支持灵活的多词回答生成。

然而,LLMs的上下文容量有限,不能将所有知识永久存储于模型权重之中。现实世界的信息是动态变化的,诸如实时天气、隐私数据以及访问控制信息不应静态地编码到模型中。为解决这一限制,研究者们借用操作系统中虚拟内存的概念,通过检索增强生成技术(RAG)实现动态数据访问。基于查询向量的相似度搜索,可以有效地从外部向量数据库中调取最相关的信息片段并将其纳入模型上下文,实现对最新信息的动态“分页”加载,让模型实时适应不断变化的环境。 不仅如此,面对某些需要实时计算或特定操作的任务,单靠检索无法满足需求。此时,引入外部工具调用成为关键策略。

模型能够生成对特定工具的调用指令,从而借助外部API或者服务执行计算,如实时天气查询、数据库访问甚至其他模型协作。这种工具调用不仅扩展了模型的能力边界,也让系统架构更接近传统计算机的执行模式,实现了类指令集的控制机制。 在实际执行过程中,为防止模型对外部工具返回数据的误解和篡改,避免了过去“模型干涉结果”带来的不确定性,采取了命名变量代替直接值传递的策略。模型仅操控变量名,具体数值由外部推理引擎保管和处理。这样一来,模型在推理链条内更加专注于逻辑结构,而不必亲自评判外部数据的合理性,极大提高了系统的可控性与准确度。 基于此思路,我们观察到了大型语言模型与传统计算机紧密的类比关系。

模型本身如同计算机控制单元的分支预测器,预测接下来最可能执行的“指令”,而外部的工具调用相当于计算机的算术逻辑单元(ALU)和寄存器。整个交互过程如同一台神经计算机的运行,模型负责策略和指令预测,外部环境则承担具体计算,实现了软硬结合的进阶AI架构。 为了让神经计算机可编程,设计了一种基于自然语言注释的逻辑编程语言,符号化地封装模型调用和推理链条。而这种语言本质上就是现代生成式AI与传统符号AI融合的体现。用户可以用该语言定义、复用和组合工具,创建复杂的神经符号系统,并且能够让模型学习和自我扩展,增强系统的自适应能力和扩展性。 面对AI系统潜在的安全和伦理风险,借鉴程序语言领域的形式化验证方法尤为重要。

采用基于安全策略的证明携带代码机制,让每一次代码(包括模型生成程序)都附带符合预设政策的形式证明,极大提升了系统可靠性和合规性。这不仅降低了非专业用户审查的门槛,还为未来实现更为安全和可控的超智能AI系统奠定基础。 此外,处理执行过程中模型可能产生的错误成为关键难点。通过引入回溯机制实现多路径搜索,系统能在遇到无效表达式或失败调用时自动尝试替代方案,保证任务最终顺利完成。这种机制进一步贴近Prolog等逻辑编程语言的思维模型,使神经计算机具备更为坚韧和灵活的问题解决能力。 在人工智能生态日益复杂的背景下,利用大型语言模型构建神经计算机的理念引领了一个崭新的计算范式转型。

它不只是幻象中的“语言模型数据库”,而是融合神经网络强大生成能力与符号推理、动态工具执行的通用神经计算平台。未来,随着模型能力的持续提升和更多元化的工具集成,神经计算机将推动人工智能领域向更高层次的自适应性、可靠性和智能化进步。 综上,虚拟机械的概念突破了传统界限,为实现更自由、可编程和功能丰富的AI应用提供了坚实支撑。无论是在实时信息检索、复杂推理,还是安全验证、错误处理等方面,该架构均展现出了卓越潜力。通过深刻理解和利用大型语言模型的“神经计算机”本质,开发者和研究者能够开启全新一轮人工智能创新与变革。