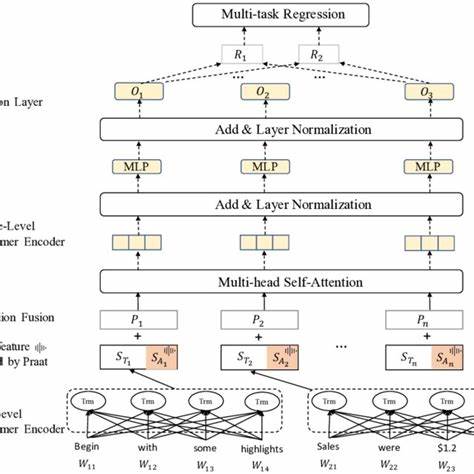

随着人工智能技术的飞速发展,Transformer模型因其在自然语言处理领域的卓越表现而备受瞩目。不同于传统的循环神经网络,Transformers能够更有效地捕捉序列中的长距离依赖关系,展现出对多任务学习的强大适应性。尤其是在处理隐马尔可夫模型(Hidden Markov Models, HMMs)这类经典序列模型时,Transformer通过层次化的特征抽取与解耦机制,赋予了模型更高的表达能力和泛化效果。这种独特的多任务学习机制为序列建模领域带来了新的视角和突破。Transformer模型的核心优势在于其层层递进的特征处理架构。研究发现,在处理HMM这类序列数据时,Transformer的低层网络主要致力于从输入中提取邻近时间步的特征信息,形成丰富的局部上下文表示。

这些底层特征相互关联紧密,反映了序列中连续状态转换的动态过程。逐步向上,模型中层与高层开始实现对这些特征的解耦。所谓特征解耦,意味着模型将时间维度上的不同信息分开处理,减弱了邻近特征之间的依赖性,从而更准确地捕捉序列中隐含的长程关系和多任务间的差异。这种分离不仅提升了多任务的适应性,还使得Transformer在不同任务间共享底层信息的同时,能够独立优化各自的表示空间。隐藏马尔可夫模型作为经典的概率序列模型,在语音识别、自然语言理解等领域广泛应用。传统HMM依赖隐状态和转移概率描述序列生成过程,具备良好的理论基础和可解释性。

然而,HMM在面对复杂、非线性且多变的真实数据时,能力受限。融合Transformer结构则弥补了这一短板。Transformer不仅能有效近似复杂的转移关系,更通过其灵活的注意力机制增强了模型对多任务的适应能力。理论分析表明,Transformer通过多头注意力层分别关注序列中不同维度的信息,实现了对序列特征的分解与重构。而这些特征层级的分布式表示,使得模型在面对多样任务模拟时表现出高度的泛化能力。实验证据支持上述观点。

研究团队在大规模多任务序列学习实验中,观察到Transformer各层功能的演变:下层专注特征捕获,中层逐渐进行时间信息分离,上层则实现任务特定特征的专属优化。这种层级分工机制让模型能够同时处理语言建模、序列标注、预测等多种任务,并在各项指标上均超越了传统单任务模型。此外,Transformer的解耦特征还为模型训练带来优化空间。特征解耦减少了各任务间的干扰,有助于稳定训练过程,加快收敛速度。模型在面对任务切换或增添新任务时,也能快速调整表示体系,避免灾难性遗忘,提升模型的终身学习能力。结合理论与实践,Transformers作为多任务学习器的崛起,推动了序列建模的新潮流。

通过解耦隐马尔可夫模型的特征,Transformer实现了更精细的序列表示,有效捕捉复杂多变信息,为多任务序列处理提供了坚实基础。未来,借助这类机制,有望进一步拓展模型在跨领域、多模态信息融合中的潜力,推动人工智能在语言理解、时序预测、医学诊断等多个领域实现突破。总结来看,Transformer通过分层抽取和特征解耦,改写了隐马尔可夫模型在序列学习中的表现方式,从理论上揭示了其多任务处理能力的根源,并在实证研究中验证了该机制的有效性。随着相关研究持续深入,Transformer的多任务序列学习能力将不断完善,助力构建更加智能和高效的机器学习系统。