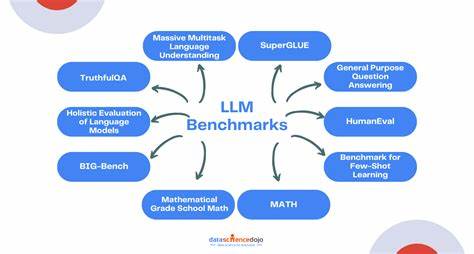

近年来,随着人工智能技术的飞速发展,大型语言模型(LLM)如GPT系列、BERT、Claude等在自然语言处理领域中表现出强大的能力。无论是自动文本生成、智能问答,还是内容审核、机器翻译,LLM都在不断刷新人们对智能的认知。然而,面对日益增多的模型选择以及复杂的应用场景,开发者和企业如何科学、有效地对不同模型进行对比和评测,成为了一道亟待解决的难题。LLM-Simple-Eval正是在这样的背景下应运而生的一个工具,它旨在为用户提供一个易用、灵活的评估框架,使得大型语言模型的基准测试变得更加轻松和高效。作为一款专注于模型性能测评的开源工具,其设计思路和功能特点具有显著优势,值得深入探讨。LLM-Simple-Eval的核心优势在于极简化的操作流程和高度自定义的测试内容。

传统的模型评测往往需要大量专业知识和复杂的环境配置,令许多开发人员和非专业用户望而却步,而LLM-Simple-Eval通过封装底层接口,支持多种主流语言模型快速接入,极大降低了测试门槛。用户只需准备对应的测试用例,即可批量执行模型推理和结果比较,极大提升效率。同时,评测内容的定制性允许用户围绕自身业务场景设计测试指标,从而获得更加贴合实际需求的性能数据。这一点对于不同领域,如医疗、金融、教育、游戏等行业应用尤为重要。该工具不仅支持对生成结果的准确性进行量化评估,还可以针对文本的流畅度、多样性和合理性等多维度进行综合分析,帮助使用者全方位地了解模型表现。如今,无数大型语言模型不断涌现,性能参差不齐,如何选出适合自身使用场景的最佳方案成为企业竞争的关键。

LLM-Simple-Eval提供了一个标准化且高扩展性的评测平台,使得各类模型在统一条件下进行公平对比成为可能。这种比较不仅涵盖了公开已知的大模型,也支持私有或定制模型的接入,极大丰富了评测范围。同时,工具具备良好的兼容性和扩展性,可以轻松整合到现有研发工作流或自动化测试体系中,有效保障项目迭代速度与质量。从实际应用角度来看,LLM-Simple-Eval已被广泛运用于多种领域。研究人员利用其评测框架快速筛选合适的模型以支撑学术研究;企业通过精准的性能对比实现产品的差异化定制;开发者则借助自动化测试机制保障模型升级过程中的鲁棒性和稳定性。此类应用不仅提升了模型研发效率,也为行业标准的建立提供了参考依据。

同时,凭借开源社区的活跃支持,LLM-Simple-Eval持续迭代优化,融合最新的评测算法和报告形式,极大地促进了模型评估技术的发展。面对未来,随着大型语言模型在智能助手、内容创作、自然语言理解等多元场景的拓展,评测工具的重要性越发凸显。LLM-Simple-Eval的出现,为技术人员提供了可靠的性能检测工具,也为推动AI落地应用奠定了坚实基础。通过持续完善和丰富评测指标,我们有望实现更智能、更精确的模型选择和应用,从根本上提升人工智能服务的质量和效率。总结来看,LLM-Simple-Eval作为一款高效、灵活且易用的评测工具,完美契合了当前人工智能应用多样化与个性化发展的需求。它不仅简化了大型语言模型的性能对比流程,又为行业提供了可复制、标准化的评测方法,助力技术人员精准把握模型优势与不足,推动智能技术的创新与深化。

未来,随着模型规模和复杂度的不断提升,此类工具的价值将更加显著,成为连接技术研发与实际应用的重要桥梁。对于所有关注大型语言模型性能和应用效果的用户而言,深入了解并使用LLM-Simple-Eval,将极大提升对模型的理解深度和选择的科学性,助力实现更卓越的智能体验。 。