随着人工智能技术的飞速发展,GPU云计算和AI推理平台正逐渐成为推动智能产业革命的重要基础设施。无论是大型科技巨头还是创新型创业公司,均致力于打造高效、低延迟的GPU计算资源,以满足日益增长的人工智能推理需求。深入理解GPU云和推理平台的供应格局,有助于洞察行业发展趋势和投资机会。 GPU云计算是指通过互联网租赁或按需使用图形处理单元的计算能力,这些GPU广泛应用于深度学习模型训练和推理阶段。大型企业如微软、亚马逊、谷歌等通过构建设备齐全、技术领先的数据中心,为客户提供稳定、安全且高性能的GPU计算资源。他们不仅自建数据中心,还通过巧妙设计电力、散热和网络系统,最大化硬件资源的利用效率。

微软凭借与OpenAI的深度合作,打造了庞大的Azure GPU云生态,投入巨额资本持续扩充全球数据中心网络,支持从大型模型训练到实时推理的多样化应用场景。同时,微软还积极开发自主芯片加速器以及面向边缘计算的硬件解决方案,以应对功耗、延迟和扩展性的挑战。微软的Azure平台集成了丰富的AI开发工具和模型应用服务,大大降低了企业客户使用AI的门槛。 亚马逊AWS作为另一巨头,拥有正快速扩张的AI基础设施。他们通过收购Annapurna Labs等举措,推出Inferentia和Trainium等定制芯片,专门优化推理和训练效率,减少计算成本。AWS同时通过Anthropic等合作伙伴布局AI生态,加强算力供应与服务集成,打造凝聚力强大的AI算力平台。

亚马逊在全球范围内部署新数据中心,并尝试利用创新能源解决方案如核电站和氢燃料技术,力求控制运营成本,提升环境友好性。 谷歌云作为AI技术的发源地,依托Tensor Processing Unit(TPU)驱动云计算服务,以硬件软件一体化的策略支持大规模深度学习模型的推理工作。谷歌TPU在模型推理延迟和吞吐量方面表现出色,尤其适合对实时响应要求极高的应用。谷歌云通过推出Vertex AI等平台,加强对模型部署、管理和自动调优的支持,不断提升开发者体验。虽然市场占有率较微软和亚马逊稍小,但凭借创新能力和技术积累,谷歌在AI推理层面持续保持竞争力。 除了这些传统巨头,Oracle和阿里云等也在推理服务市场占据一席之地。

Oracle依靠有竞争力的价格策略和裸金属GPU集群服务器,瞄准成本敏感型客户,并与OpenAI等建立战略合作。阿里云深度整合本地产业生态与AI推理能力,结合自主研发芯片如寒光800,成为中国市场的领导者。面对国际形势和政策限制,阿里云依然保持强劲增长,并提供多样化的推理平台以满足国内外客户需求。 除巨头之外,一批专注于纯GPU云服务的初创和成长型企业,正在市场上迅速崛起。CoreWeave作为一个纯AI超大规模云计算平台,通过剥离传统云复杂性,专注提供裸金属GPU集群,以提升GPU利用率和降低推理延迟。其采用液冷技术支持高密度GPU机架,资金依赖资产支持证券发行,快速扩张显著挑战传统巨头的地位。

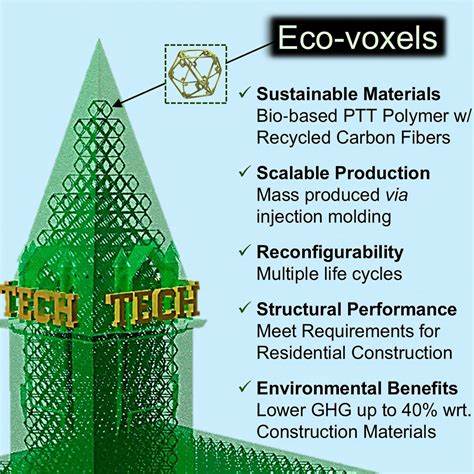

该公司与NVIDIA保持紧密伙伴关系,成为新一代GPU硬件的首批部署者,其业务虽集中但展现出极强的议价能力和市场拓展潜力。 Lambda Labs和Crusoe Energy各自通过价格优势和能源创新探索降低成本。Lambda主要面向开发者和中小企业,提供性价比高的GPU实例,简化AI推理上云门槛。Crusoe则利用被浪费的天然气资源转化为清洁电力,建设绿色数据中心,推动可持续、高效的算力供应链发展。此类差异化路径为GPU云市场注入更多活力,拓宽了行业的创新边界。 推动AI推理服务普及的另一大趋势是AI推理平台即服务(PaaS)。

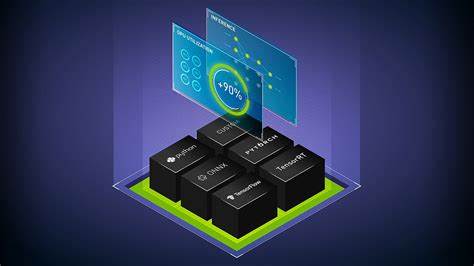

这些平台负责模型托管、部署、弹性扩展和监控,开发者无需自己构建复杂基础设施,即可通过API接口调用各类AI模型,按用量计费,显著降低了技术门槛。微软Foundry、亚马逊Bedrock与谷歌Vertex是市场上三大代表,通过丰富的模型目录、完善的安全合规体系和强大的工具链,为企业和开发者提供一站式AI应用构建环境。 与此同时,Together AI致力于开源生态,结合自建数据中心和第三方GPU资源,打造可支持海量开源模型的高性能推理平台。通过引入FlashAttention等优化算法,该平台最大限度提升GPU利用率和查询吞吐,为开源AI开发者群体提供了强大基础设施保障。 Fireworks AI的模块化AI理念为推理平台注入了新思维。其研发的自适应推理引擎可根据运行负载动态调整模型,优化延迟与成本,支持复杂流程编排。

此类技术的革新进一步推动AI推理服务向智能化、灵活性方向发展,改善不同场景下的用户体验。 在加速器领域,Groq和Cerebras两家公司尝试通过自研芯片打破NVIDIA的霸主地位。Groq专注高速小型模型的低延迟推理场景,提供易用的API接口和GPU云服务。Cerebras则凭借超大规模芯片支持极大模型推理,着力拓展企业和研究级用户。虽然面临成本、生态建设等挑战,但这种多样化硬件架构为AI推理带来更多可能性和竞争态势。 从供应链角度分析,GPU云和推理平台面临诸多成本压力。

数据中心建设涉及高昂的资本开支,包括设备购置、供电、冷却和网络部署。运营中需要维持高能效利用比(PUE)和高度可靠的运行保障。能源成本尤其关键,冷凉地区和可再生能源的利用成为降低运营成本和环保要求的战略重点。此外,ISP带宽费用、物理与网络安全投入、软件维护及客户支持构成运营开销的重要部分。 供应格局的核心竞赛集中在技术集成与资源管理能力。硬件方面,GPU选择、加速器配比、液冷等散热方案直接影响单位算力的效率和成本。

软件层面,调度系统(如SLURM、Kubernetes)、中间件优化、调用调度、模型压缩和量化技术是提高硬件利用率的关键。成熟供应商通过开发专属的监控和遥测系统,实现动态资源分配和负载均衡,进而最大化利用率及盈利空间。 服务层的差异化竞争也越来越突出。如何构建安全合规的多租户环境,保障数据隐私和企业合规要求,对云平台提出了更高要求。多样化的部署模式,如按需弹性伸缩、专属GPU、混合云及边缘推理支持,成为客户采购的重要考量。供应商搭建完善的AI开发者生态,提供微调、评估、知识检索、自动化工作流等工具,也成为吸引客户和促进业务增长的重要利器。

未来几年,随着更先进的GPU架构持续涌现及专用AI芯片不断问世,GPU云和AI推理平台供应格局将持续演变。大型云服务商将继续扩张布局,提升资深技术壁垒,同时环保合规和绿色能源的发展亦会改变数据中心的运营方式。新兴玩家凭借灵活的商业模式和创新技术,或在特定细分市场抢占先机。开源平台和模块化AI理念的兴起,有望促进生态圈多样性和创新活力,推动AI推理服务进入更广泛的应用层面。 综合来看,GPU云计算和推理平台正处于快速成长期。市场对算力的需求不断攀升,技术升级和商业模式创新层出不穷。

从巨头云厂商的垄断式规模优势,到创业公司差异化突围,整个行业呈现出活跃且复杂的供应格局。对于想要抓住AI风口的企业与开发者而言,深入认识GPU云生态以及推理平台供应的内在机制,将极大助力于选择合适的合作伙伴和技术方案,确保在新一轮智能革命中稳占先机。