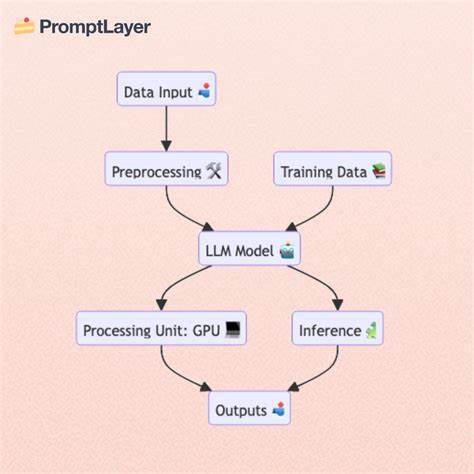

大语言模型(LLM,Large Language Models)近年来迅速成为人工智能领域的热点,尤其以ChatGPT为代表的产品更是掀起了广泛关注和应用热潮。理解这些模型的内部运作机制,对于从事相关领域工作的人士以及对AI充满好奇的普通用户来说,具有极高的价值。本文将带领读者以浅显易懂的方式,全面剖析大语言模型的生成过程与技术原理,助力您在AI时代更好地利用和理解这些智能工具。 大语言模型的诞生过程大致可以分为三个关键阶段:数据收集、预训练以及后期训练。每一个阶段不仅对模型的性能有重要影响,同时也各自蕴藏着复杂的技术细节和挑战。 在数据收集阶段,模型需要海量且多样化的信息作为训练基础。

这通常意味着从互联网的公开资源如Common Crawl等数据集中获取数以百亿计的文本网页。数据的浩瀚和多样决定了模型的知识广度与准确度,因此数据的规模和质量尤为关键。由于互联网数据时刻更新,模型实际上只能学习到某个时间点之前的内容,这也解释了为何大语言模型都会存在知识截止日期。 预训练是构建大语言模型中最为消耗资源的环节。它通常借助变换器(Transformer)架构,通过让模型预测文本中缺失的部分或下一个词,实现对语言结构、语义和上下文关系的深度学习。预训练过程耗时数周甚至数月,且涉及极高的计算成本,因而通常只有具备庞大计算力的企业或研究机构能够完成。

预训练完成后,模型其实具备的是“自动补全”能力,也就是基于已有文本猜测后续内容的能力,但这并不意味模型能准确回答问题或做出理性推理。 因此,后期训练显得尤为重要,它通常采用监督微调(Supervised Fine Tuning,SFT)技术。通过提供带有明确问答标签的训练数据,模型被进一步教导如何更符合人类的交互需求,变得更加“智能”和“有用”。例如在SFT阶段,模型会被训练回答像“2+2等于多少”或者“印度的首都是哪里”这样具体的问题,确保输出精准且符合人们期望的答案,这才造就了我们熟知的智能助理形态。 除了纯文本,大语言模型的输入和输出也日益多元化,涵盖了图像、音频、视频、PDF文档等各种格式。不过无论输入形式多样,模型核心工作仍是将信息转换成统一的“tokens”——即模型能够识别和处理的最小单元。

Tokenization是将复杂和多样内容拆解成模型可理解并加以处理的数字标识的过程,不同模型采用的分词算法也各不相同。比如GPT-2采用的是Byte-Pair Encoding(BPE)算法,其词汇表大约包含5万个token,而更新版本如GPT-4o则扩展到了20万个token,使模型能够更加细致地理解语义与上下文联系。 在日常使用中,大家可能遇到过“大草莓中的字母r有几个?”这种看似简单的问题,但很多模型最初回答错误,甚至生成毫无意义的答案。这并非是模型智能的缺陷,而是源于token化机制的限制,当“strawberry”这个单词被分成一个或多个token时,模型难以直接分辨并计数里面的单个字符。为解决此类问题,先进系统如Claude引入了专门的系统提示(System Prompt)指导模型逐步分析、逐步计数,甚至通过字符串操作代码进行准确计算,极大提升了模型在此类任务上的准确性和人性化表现。 理解大语言模型不可避免地要熟悉一些专业术语。

缩放规律(Scaling Laws)描述了预训练中模型性能改进的基本法则。研究表明增大模型参数数量、扩大数据集规模并延长训练时间能以对数线性方式降低模型的损失值,从而提高预测精度和泛化能力。模型参数可视为内部的“调节旋钮”,在训练中被自动调整以优化其输出结果,因此参数越多,模型的表达能力和复杂模式理解能力便越强。 另一个经常被提及的重要概念是上下文窗口(Context Window),指模型可一次性处理的最大token数量。上下文窗口决定了模型能处理信息的范围大小。比如GPT-4o拥有大约12.8万个token的上下文能力,相当于能读入数百页文本,满足绝大多数应用场景的需求。

更进一步,谷歌研发的Gemini 1.5 Pro上下文窗口最大可达到200万个token,极大扩展了模型理解超长文档、代码库和多媒体内容的可能性。即便试验性的10M token窗口尝试也成功展现了长上下文检索和推理潜力,但巨大的计算成本成为实际推广的障碍。这种能力尤其适合“针尖上找草堆”的任务,譬如在数小时的视频或百万字的文本中精准定位目标信息,实现对海量数据的深度洞察。 为了解决上下文窗口限制对超大规模数据访问的瓶颈,检索增强生成(Retrieval Augmented Generation,RAG)技术应运而生。RAG将海量数据存储在独立数据库中,依据用户提问调用相关数据,并将检索结果动态放入上下文发送给模型。这样的机制类似于为模型提供一位“智能图书管理员”,通过索引快速找到最相关章节,放入有限上下文窗口,从而实现对超大语料库的有效利用和答案生成,极大提升适用性和准确率。

纵观大语言模型的发展历程和技术细节,我们可以清晰看到它们从海量数据中学习语言模式,到通过预训练形成“文本自动补全”能力,再到后续微调塑造成更善解人意的智能助理的全过程。其背后不仅有深厚的算法基础、海量的计算资源支持,更有从实用角度出发的不断优化和创新。当前技术正使这些模型实现跨模态输入输出、支持更长文本理解和复杂推理,未来还将伴随更强的交互能力和广泛的应用场景。 面对如此迅速迭代的大语言模型,作为用户和开发者,理解其核心运作原理,不仅有助于把握使用技巧,更能洞见人工智能的未来发展方向。在实际应用中合理利用其优势,搭配检索、上下文管理等辅助技术,将带来更加智能、高效和个性化的体验。 未来,大语言模型的研究将继续朝向提升泛化能力、降低计算成本、扩展多模态理解以及优化长文本处理等方向深化。

随着技术门槛的降低以及生态系统的完善,LLM的应用将无处不在,助力各行各业实现智能升级。我们也期待更多原创的研究、开源项目和商业化产品出现,推动人工智能向更高质量、更广适用、更深人心的方向迈进。 总之,大语言模型不再是遥不可及的黑盒,而是一个由庞大数据支撑、精密算法驱动、细致调优成型的智能体。理解其内部构造和训练流程,将极大助力我们理性认知和高效利用这一强大技术,开启面向未来的智能新时代。