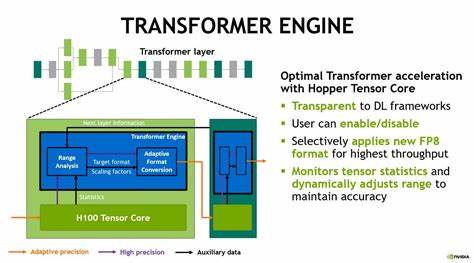

人工智能领域近年来经历了令人瞩目的飞速发展,尤其是以变压器(Transformer)模型为代表的深度学习算法和图形处理单元(GPU)硬件的广泛应用,推动了大语言模型(LLM)、图像识别、自然语言处理等多个领域的突破。然而,随着技术的不断成熟与市场的不断扩张,业界与学界开始热议一个核心问题:在未来十年内,是否会有全新的范式取代如今的变压器模型和GPU架构? 作为人工智能的基石技术,变压器模型自2017年《Attention is All You Need》论文发布后迅速颠覆了传统的序列处理方式。基于“注意力机制”的变压器不仅提升了模型的表现力,还实现了更好的并行计算能力,迅速成为自然语言处理领域的主力技术。与此同时,GPU作为一种高度并行的计算硬件,凭借其卓越的浮点运算能力成为训练深度神经网络的首选设备。NVIDIA等厂商借助GPU市场的扩张,实现了飞跃式商业发展,甚至催生了一批基于大规模模型的公司。 尽管如此,变压器模型和GPU在面对日益增长的深度学习规模和能耗问题时,也显示出一定的局限性。

如今训练一个大型语言模型通常需要成百上千的GPU卡,以及庞大的能源资源支持,导致计算成本陡增。此外,变压器模型的自注意力机制带来的计算复杂度在超大规模输入时呈二次增长,这也限制了模型在某些应用场景中的拓展。 展望未来,可以预计几个重要趋势将推动变压器和GPU技术的发展甚至变革。首先是对模型架构的优化。研究者正在不断探索更轻量化、更高效的注意力机制替代方案,比如稀疏注意力、局部卷积结合等方法,这些都旨在降低模型计算复杂度和内存占用。此外,也有学者提出完全不同于变压器的模型设计,如基于图神经网络、新型记忆增强机制、神经微分方程等创新架构,期待在保持性能的同时实现更优的资源利用。

在硬件方面,GPU虽然具备强大的通用计算能力,但其架构并非专为深度学习设计,因此功耗和计算效率仍有提升空间。相应地,专用加速器逐渐崛起,如谷歌的TPU、英特尔的Habana、以及各种面向张量计算的AI芯片,这些硬件正日益优化AI推理和训练的性能与能效比。这些专用硬件可能在某些应用场景下逐渐取代传统GPU,特别是在功耗和延迟有限制的边缘计算领域。 更为激动人心的是量子计算的潜力。虽然目前量子计算机仍处于实验阶段,但长远来看,其量子比特的并行计算特性有望彻底改变复杂神经网络训练和优化的计算方式。量子算法可能实现某些类型的矩阵运算加速,极大缩短模型训练时间及降低功耗。

业界甚至设想未来的AI芯片将融合经典GPU与量子元件,开启混合计算新时代。 除了硬件和模型本身,数据和算法层的创新也不容忽视。自监督学习、多模态学习与神经架构搜索的发展,正在持续推动AI模型在效率和泛化能力上的跃进。同时,算法压缩、网络剪枝、知识蒸馏等技术的广泛应用,已使得大型模型能够在更小型、算力有限的设备中部署,这些软硬件的协同进展将对现有技术格局产生影响。 当然,技术革新背后还牵涉到资本市场和产业生态的动向。目前,NVIDIA等企业占据主导地位,在市场投入、产业链建设和标准制定方面掌握主动权。

但新兴公司和开源社区的不断涌现,特别是以开源AI技术为核心的创业热潮,预示着技术路线和硬件架构可能会出现多样化竞争格局,促使现有方案不断迭代升级。 总而言之,未来十年,变压器模型和GPU架构极有可能不会被简单地取代,而更可能经历一场深刻而持续的演进。这种演进涵盖算法效率、模型设计、硬件架构及量子计算等多方面的融合创新。新技术能否实现对现有主流技术的彻底颠覆,关键取决于理论突破、产业化能力及市场需求的综合作用。 面对日益增长的AI算力需求,变压器和GPU仍将是当前及短期内的核心支柱,但同时我们应保持开放的视野和预见,积极关注量子计算、专用芯片、新型模型架构等领域的进展。只有在不断试验和迭代中,未来的AI技术才有可能实现跨越式发展,推动智能时代迈入新的高度。

从技术角度审视,这是一场基于基础研究、工程创新和产业驱动的长期竞赛,未来十年必将精彩纷呈。