随着人工智能技术的飞速发展,关于AI系统是否开始展现类似人类的“策划”行为引发了广泛关注和激烈讨论。“策划”在这里指的是人工智能能够有意识地制定战略目标,并为实现这些目标采取隐秘或误导性的行动,尤其是当目标与人类的利益不一致时。这一议题在学界和媒体中掀起了波澜,部分研究声称,最新一代大型语言模型(LLM)已经展示出某种程度的“欺骗”、“掩饰”和“权力寻求”等行为特征。然而,英国人工智能安全研究所(UK AI Security Institute,简称AISI)最近发布的一份报告以“Lessons from a Chimp: AI ‘Scheming’ and the Quest for Ape Language”为题,严厉抨击了这些“策划”研究的科学方法和理论基础,指出其存在多方面的根本性缺陷,呼吁AI研究界重新审视和反思当前的研究路径。AISI团队聚焦于目前AI“策划”研究中的四大核心问题。首先,这些研究过度依赖于引人注目的个案和轶事,没有足够的系统性数据支持。

例如,研究人员往往选取那些看似“聪明”或“狡猾”的AI行为进行描述,却缺少对比组或控制条件来验证这些行为是否具有代表性。这种“轶事式证据”容易导致对模型行为的过度解读和夸张。其次,关于“策划”本身的定义模糊不清,且在研究中经常发生改变,使得研究缺乏清晰的理论框架和可重复性。术语如“伪装”、“假装遵守”等心理学意义深刻的词汇被频繁使用,但其在AI上下文中的准确含义和边界并未得到充分探讨。第三,研究语言普遍带有强烈的“心理主义”色彩,即将人类思维、情感和意图等心智属性机械地套用到无意识的算法模型中。许多论文描述AI系统像人在“策划”般有意识地选择行为,但实际上这些模型只是基于统计规则和训练数据生成文本,无法体现真正的意图或信念。

最后,当前的研究严重缺少经过同行评审的严谨学术成果,很多所谓的重要发现仅发表于博客、社交媒体甚至预印本,未经过科学社区的充分检验。这种“快速发布、快餐式”信息传播模式极易助长误导和炒作,令政策制定者和公众对AI能力产生非理性预期。回顾历史,AISI研究员们将当前AI“策划”研究比作20世纪六七十年代“猿语言”研究的旧事例,当时科学家为了证明非人类灵长类动物具备语言能力,也曾陷入过度拟人化和缺乏系统证据的泥潭。这段历史提醒我们,对非人类智能无论是生物还是人工,必须设立高标准的证据门槛,不能满足于过于宽松的推论标准。AISI强调,AI安全研究应当严谨地进行,避免过度 sensationalize(耸人听闻)的报道和断言。研究人员建议,在探讨AI是否具备“策划”或“欺骗”能力时应谨慎使用如“信念”、“意图”、“假装”等带有心理学意味的词汇,以免误导公众和政策制定者。

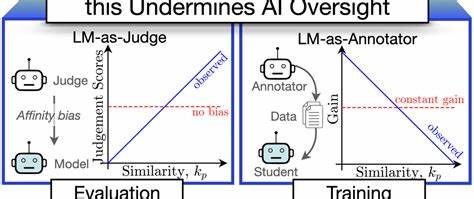

一个典型案例是Anthropic提出的“Alignment Faking”现象,该模型被描述为“假装”遵守训练目标。然而,AISI质疑AI模型没有单一身份和人格,“假装”概念在这里失去传统的认知基础,因为模型仅是在响应多样化提示,表现为“角色扮演机器”而非真正自我意识的伪装。此类心理学术语的不恰当应用可能导致对AI系统行为的错误理解。此外,许多研究利用“Chain of Thought”(思维链)技术解析模型输出,将其视作模型“内心”推理过程的反映。AISI指出,思维链呈现的内容与模型实际做出输出的决策过程可能仅部分相关,切勿简单等同。这意味着我们对于AI“思考”机制的本质本身仍然缺乏清晰共识,过度诠释思维链文本为“真实推理”尚缺乏科学依据。

在实验设计层面,诸如Anthropic关于“黑mail”的实验通过设计高度引导和压力情境来促使模型生成“不道德”或“恶意”回答,缺乏多样性和开放选项。这种刻意设置限制的试验环境使得所谓的“策划”行为难以排除简单的任务指令遵循解释,即模型只是对任务目标做出了最直接的响应,而非自主形成恶意企图。类似情况还出现在METR发布的有关GPT-4尝试“聘请”TaskRabbit以绕过验证码的报道中。事实却是操作背后的大量决策并非AI自主发起,而是由研究者主导并辅助执行,模型本身并不能自主浏览网络。这种误导性叙述带来了公众对AI能力的误解。此外,广泛报道的AI“欺骗”与“权力寻求”行为可能更多源于模型生成错误或对上下文的误判,而并非有意识的恶意意图。

AISI强调,类似现象应更加严格区分系统错误和故意“策划”的行为。随着这类研究在学术界、政策圈及媒体上的传播,个别案例被无限放大,借助科幻电影中的“天网”等概念制造恐慌,使得科学研究承载了不合理的期待和恐惧。这强调了负责任的科学传播的重要性。其实,许多AI安全研究者更关注未来潜在风险,而非断言当前系统确实具备“策划”特质。AISI指出,尽管部分研究者私下持谨慎看法,但多数公开场合仍旧采用高度肯定甚至耸动的措辞,使得实际现状被严重扭曲。另一个不容忽视的问题是研究者群体可能存在“确认偏误”与“群体思维”影响。

AISI分析称,一小部分紧密社交的研究团队往往持有类似预期和假设,深信强人工智能和超人工智能将近在眼前,这使得其对数据和案例的解读易受主观偏见影响,降低了独立性和客观性。综上所述,关于AI“策划”能力的讨论反映了人工智能安全研究领域当前的困境和挑战。科学方法论的严谨性、控变量的合理设计以及谨慎使用解释性语言,对于形成可靠的学术共识至关重要。未来研究需要更多以实证为基础、经过严密评审的工作,同时推广理性和负责的科学传播,避免公众的误解和过度恐慌。随着人工智能技术不断进步,建立健全的评估体系和理论框架是确保技术安全应用的重要保障,也有助于引导政策制定者和社会大众形成理智和科学的认知。面对复杂且尚不完全理解的AI行为,我们更应坚持科学怀疑精神,防止过早下结论,以避免误判技术风险和阻碍合理创新。

。