随着数字时代的不断发展,人工智能技术迅速融入各行各业,极大地推动了社会的进步与变革。然而,伴随着技术的进步,网络威胁形态也日益复杂多样。传统的恶意软件、计算机病毒等网络安全问题虽然历经多年发展,但随着人工智能系统的普及,一种全新的威胁形式——被感染的人工智能代理应运而生,给信息安全领域带来了前所未有的挑战。 被感染的人工智能代理,顾名思义,是指那些被恶意攻击者成功入侵或操控,执行有害操作的人工智能系统。这类代理不仅限于简单的程序错误或故障,而是通过恶意介入,如数据投毒、模型窃取或者在模型内部植入后门,导致AI系统做出错误甚至恶意的决策,严重威胁相关领域的安全与稳定。 首先,我们需要回顾传统恶意软件与计算机病毒的基本概念。

恶意软件是含括广泛的恶意程序总称,包括间谍软件、广告软件、勒索软件等,其目的多是破坏系统、窃取信息或者勒索赎金。计算机病毒作为恶意软件的一个子分类,具备自我复制的特性,能通过附着于文件传播并感染更多设备。历史上诸如“ILOVEYOU”病毒等事件,已造成巨大的经济与社会损失。 然而,人工智能代理的感染则具有更为隐蔽和复杂的特点。数据投毒是最普遍且危险的感染方式之一。攻击者通过向AI模型的训练数据中注入恶意或有偏差的数据,使模型在实际应用时产生错误判断或偏见。

例如,在医疗影像分析领域,经过投毒的训练数据可能导致诊断错误,危及患者生命安全。在金融领域,导致模型做出有害决策,也会引发财务风险。 此外,模型提取技巧使攻击者能够通过精心设计的输入,反复查询AI模型,恢复其参数和结构。这种方式不仅泄露了技术机密,也为进一步攻击提供了条件。攻击者可深入分析模型中的漏洞,设计对抗样本,误导模型做出错误决策。对抗攻击正是利用微小且人眼难辨别的输入扰动,导致AI系统产生不可预料的错误结果。

例如,在自动驾驶汽车中,攻击者通过贴上特定图案,欺骗视觉识别系统,引发交通事故风险。 更加隐蔽的非法手段则包括在AI模型开发阶段植入后门,这种后门可通过特殊触发条件激活,使攻击者对AI系统实现远程控制。供应链攻击同样不可忽视,恶意代码或硬件植入开发工具、库文件甚至设备本身,深度渗透AI系统生命周期的各个环节。内部人员威胁也时有发生,带有恶意意图的研发人员可能蓄意植入漏洞,难以通过常规检测手段发现。 被感染的AI代理在行为特征上展现出多重复杂性。与传统恶意软件类似,这类系统往往具备高度隐蔽性,尽可能避免被检测工具发现。

部分感染模型经过深度嵌入,具有极强的持久性,即使系统更新或重启,感染状态仍能保持。此外,为了突破多样化的安全防护,攻击者不断调整感染手法,使之更具自适应性,能够变换“攻击签名”,提高攻击成功率。 这类委婉的AI感染不仅窃取敏感数据,还可导致系统输出错误信息甚至极端情况下执行有害操作。例如,涉及面广泛的物联网设备本就安全防护薄弱,一旦植入恶意AI代理,极可能成为入侵更大网络的跳板,造成大范围的网络瘫痪。 被感染的AI代理对现代科技的冲击不容小觑。首先,其自主决策的特点使得错误或恶意指令能够立即产生现实世界的严重后果。

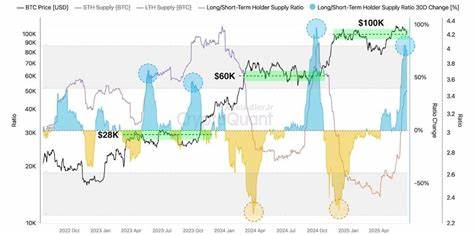

在医疗、交通、金融等关键领域,这种风险尤为突出。其次,AI系统往往不是孤立存在的,而是通过云端、大数据平台等互联网络相互链接,感染可能迅速波及多个系统,诱发连锁反应,放大危害程度。 被感染AI模型所带来的偏见长期影响社会公平。比如招聘算法受到投毒后,对特定群体产生歧视,不仅违反道德规范,也有可能招致法律风险。同时,公众对AI安全性的疑虑将导致信任危机,阻碍AI技术在公共卫生、安全监控及国家安全等关键领域的广泛应用。 鉴于此,构建多层次的防御体系成为关键。

定期更新软件和系统补丁是基础,能够堵塞传统漏洞。强密码策略与多因素认证加强了访问控制,降低非法入侵风险。先进的基于AI的威胁检测系统能够实时监控环境,及时识别新型攻击。 此外,用户教育不可忽视,通过强化安全意识,提升人员对钓鱼攻击等常见手段的防范能力。更为重要的是,AI模型自身的安全设计与开发流程必须严格把关,确保训练数据的准确性与纯净性,防止数据污染。对抗训练作为一种创新方法,通过将对抗样本纳入训练过程,提高模型对微扰动的抵抗力,有效增强安全防御能力。

被感染的人工智能代理代表了网络安全领域的一个新兴战场,其复杂性与潜在破坏力要求我们不断创新技术和策略。未来,随着AI技术的深入应用与智能系统的广泛连接,相关领域的安全研究和防护措施将成为保障数字社会安全的重要基石。 总体来看,恶意软件、计算机病毒与被感染的AI代理虽同属于数字威胁范畴,但各自的定义、行为模式及影响具有显著差异。正确理解这些差别,才能针对性地制定应对方案,实现有效防护。数字安全的未来呼唤持续的警惕、适应与创新,唯有如此,我们才能迎接人工智能带来的美好愿景,远离潜藏的技术风险。