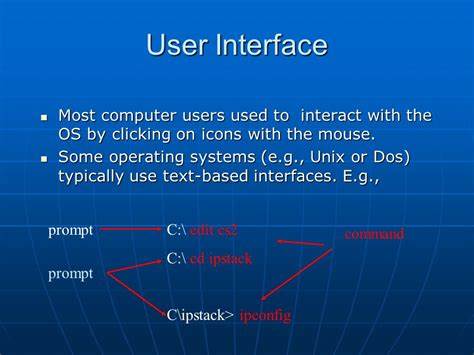

在Linux操作系统中,图形用户界面(GUI)通常通过X Window System或Wayland来实现鼠标的交互功能。然而,在许多场景下,用户需要在纯文本的控制台环境下利用鼠标,例如远程登录到服务器或进行系统维护。尽管Linux控制台默认是字符模式,鼠标交互的实现依然起到了极其重要的作用。本文将深入探讨Linux控制台如何与鼠标进行交互,解析其背后的核心技术、驱动机制及应用实践。 从底层来看,Linux控制台的鼠标交互依赖于输入设备的外围驱动和内核的输入子系统。现代Linux内核通过输入子系统(Input Subsystem)管理所有的输入设备,包括键盘、触摸板和鼠标。

鼠标数据以事件(Event)的形式被内核捕获,并被传递给字符设备节点,诸如/dev/input/mice或/dev/input/mouseX。内核的输入子系统采用事件驱动模型,通过evdev接口向用户空间提供标准化的输入事件描述,方便用户空间应用程序读取和处理。 由于Linux控制台传统上是通过虚拟终端(Virtual Terminal,VT)提供的字符界面,与鼠标的交互需要依赖特定的驱动和协议。最早期的控制台鼠标支持是通过gpm(General Purpose Mouse)守护进程实现的。gpm是一个用户空间的服务程序,专门为控制台提供鼠标支持,允许鼠标移动、点击选择文本,甚至实现中键粘贴等功能。gpm通过读取输入设备节点的数据,根据鼠标动作翻译为控制台的特定命令,模拟选择、复制等操作,从而提升了控制台的交互性。

gpm的工作机制可谓是Linux控制台鼠标交互的基石。启动后,它会监听鼠标设备文件的事件,当检测到鼠标动作时,将其映射为在控制台上的响应。例如,按键点击可触发文本选择,滚轮滚动可以执行滚屏功能。gpm支持多种鼠标协议,包括微软鼠标、PS/2和USB鼠标协议,这使得其能够在多样的硬件环境中稳定工作。尽管gpm是Linux控制台鼠标支持的传统方案,但它依然广泛应用于服务器和纯文本环境中。 在新兴技术和需求推动下,终端模拟器(Terminal Emulator)与鼠标的交互方式也得到了改进和扩展。

许多现代终端模拟器,如xterm、tmux和screen,支持通过标准的终端控制序列来传递鼠标事件,使得鼠标不仅能够选择文本,还能与应用程序内部进行复杂的交互。例如,在vim编辑器或tmux会话中,用户可以利用鼠标点击定位光标、选择文本块,甚至进行拖放操作,这些功能极大提升了控制台的操作便利性。 这种鼠标支持依赖于终端标准中的特殊模式,如"鼠标报告模式"(Mouse Reporting Mode)。当终端模拟器开启鼠标报告模式后,鼠标事件会被编码成控制字符流并传递给终端中的应用程序,后者再根据事件做出响应。坐标、按钮状态和动作类型等信息均被准确传递,实现了鼠标操作的精细控制。比如,xterm和gnome-terminal均支持按不同的编码协议发送鼠标事件,支持多按钮和鼠标滚轮事件的传输。

除了用户空间的驱动和终端功能,Linux内核也不断完善对输入设备的支持,以适应鼠标交互的不断丰富。在内核版本更新中,相关的输入驱动模块被持续优化,兼容更多新型鼠标设备和协议。同时,USB和蓝牙鼠标的即插即用也得益于内核的自动识别与配置机制,保证了控制台环境下对多样鼠标硬件的基本支持。 值得强调的是,Linux控制台鼠标的使用体验受限于控制台本身的特性。由于控制台缺乏图形环境,鼠标交互主要局限于文本选择和简易的点击操作,诸如拖放、复杂的图形界面等依赖图形系统的操作无法实现。然而,在许多系统管理和开发场景,鼠标操作的基本功能已大幅优化了用户的交互效率和体验。

对开发者而言,理解控制台鼠标事件的底层机制极为重要。无论是编写自定义的终端应用程序,还是改进现有的工具,都需要掌握终端鼠标报告模式的协议标准以及如何读取和解码输入设备文件的数据流。合理利用gpm和现代终端模拟器的特性,可以打造出高效且人性化的命令行界面。 总结来看,Linux控制台鼠标交互是由内核输入子系统、gpm服务、终端模拟器鼠标报告模式以及应用程序的协同作用共同实现的复杂体系。尽管受限于字符界面的限制,鼠标依然在提升控制台操作便利性方面发挥着不可替代的作用。随着技术的进步和用户需求的多样化,控制台鼠标支持也将持续演进,期待未来能够实现更加丰富和自然的人机交互体验。

。