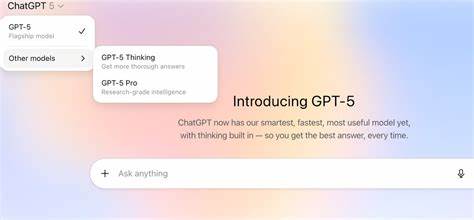

近年来,人工智能技术飞速发展,尤其是大型语言模型(Large Language Models,简称LLM)如GPT系列的不断升级,带来了前所未有的智能交互体验。随着GPT-5的推出,模型的能力显著提升,但与此同时,用户在调试和理解其"思维"过程中遇到了新的挑战。尤其是在调试模型思考过程的透明度和可追溯性方面,用户体验出现了较大波动,这成为技术社区广泛关注的话题。GPT-5作为OpenAI最新发布的旗舰级模型,展现出了更强的自然语言理解和生成能力,能够完成更加复杂的任务,甚至在某些情况下表现出类人般的推理和判断能力。然而,正是这些更为复杂的推理流程,让开发者和用户难以直接洞察模型内部的"思考路径",导致了调试流程的困难和效果降低。回顾早期的版本,比如GPT-3或GPT-4,用户能够借助"推理步骤展示"功能,以逐步的思维链条形式观察模型的内部推理过程。

这不仅提高了调试效率,帮助开发者定位和解决问题,也使得模型的生成更加可控和可信。然而,GPT-5在架构和接口设计上选择了更为封闭和优化的方案,减少了对用户展示中间推理步骤的频率,表面上提升了响应速度和生成质量,但也牺牲了用户追踪思维轨迹的能力。对于开发者来说,缺少观察模型思维细节的窗口,无疑增加了错误排查和结果验证的难度。尤其是当模型给出的答案或者执行的任务结果不符合预期时,用户无法直接判断是输入提示的问题,还是模型理解过程出现偏差,亦或者是任务本身涉及模糊或多解的复杂情况。此类不透明性导致了调试难度升级,影响了模型的普适性和使用信心。深层次来看,OpenAI做出这一设计取舍,既有战略层面的考虑,也是在平衡商业利益和用户体验之间的一种权衡。

隐藏复杂的推理步骤,能够防止潜在的安全风险、误导性信息扩散,同时也能维护模型的专有技术保护。然而,这对构建开放和社区驱动的人工智能生态却带来了挑战,使得一些开发者群体感受到所谓"黑盒效应"的加剧。为了应对这一困境,业界和研究者正在探索多种可能的解决路径。首先,强化模型的可解释性研究,旨在开发新技术让语言模型在保持高效性能的同时,能生成更透明、易于理解的推理过程报告,帮助用户把握关键逻辑点。其次,设计更智能的调试工具,通过自动化分析提示、反馈循环判断和多轮交互,辅助用户查漏补缺。此外,部分开放源代码项目以及替代模型也尝试保留更多的推理链展示,促进社区的协作和创新。

未来,随着人工智能法律法规的完善以及用户对技术透明度需求的提升,这种调试思维的可见性势必会成为各大模型开发者重点考量的因素。此外,行业内部或将形成更标准化的通用调试协议,通过标准接口和工具集成,使得不同模型间的调试体验趋于一致,并降低新手用户的门槛。对于普通用户而言,理解GPT-5思维调试的复杂性,有助于调整期望,合理设计提示词策略,以获得更精准的回答。同时,也激励用户多参与社区讨论,推动开源工具和辅助平台的发展,共同推动AI技术的健康生态建设。总之,调试GPT-5的"思维"不仅是技术问题,更关系到人工智能透明度、用户信任和行业生态的未来。只有通过技术创新、开放合作和政策引导的多维度努力,才能实现更高水平的智能交互,为社会带来更加安全、可靠的人工智能助力。

未来,调试语言模型的工具与方法必将日臻成熟,破解"黑盒"困境,让机器思维更加清晰可见,同时赋予用户更强大的掌控力与创造力。 。