在当今数据驱动的世界中,Unix工具仍然是数据工程和软件开发领域的重要基石。无论是处理文本数据、管理文件系统,还是构建自动化工作流,Unix的命令行工具以其灵活性和高效性赢得了众多工程师的青睐。然而,许多开发者在使用这些工具时常常面临语法复杂、组合难度大以及学习曲线陡峭等挑战。最近,随着大型语言模型(LLMs)的兴起,这一状况正悄然发生改变。大型语言模型不仅可以帮助用户克服语法障碍,还能将自然语言描述转化为高效、可执行的Unix脚本,堪称数据管道构建的“缺失编译器”。 Unix工具的魅力在于其组合性和哲学思想。

它允许开发者通过串联简单的命令组成复杂的处理流程,从而完成数据转换和自动化任务。GNU核心工具如cat、head、join、sort、xargs等构成了每日数据处理的利器,搭配psql数据库查询、Python脚本片段等方式,能迅速构建有效的数据管道。许多工程师习惯于在Makefile中将这些命令组织起来,实现批量执行和环境变量管理。然而,这种方法虽然灵活,却面临着脚本易读性差、维护难度大以及难以掌握工具高级用法的问题。 大型语言模型的发展正好弥补了这一短板。不需要深入研习正则表达式或awk脚本,甚至可以在不了解所有Unix工具细节的情况下,快速完成数据操作任务。

用户只需以接近自然语言的方式描述需求和数据流程,LLM便能根据提示自动生成符合需求的Unix命令序列和脚本。在实际应用中,许多工程师发现他们可以用一句简短的说明取代复杂的脚本编写过程,极大节约了时间和精力。 此外,LLMs还为数据工程师提供了跨工具之间的桥梁。当面对不同的数据源或数据库时,传统方案往往建议使用专业的跨库工具或复杂的框架,如外部表、数据虚拟化引擎等,造成学习和部署成本高昂。但若明确告诉模型使用现有Unix工具组合,如diff进行文件比对、join执行数据关联,LLM能够智能地生成合理而精简的方案,避免引入过度复杂的依赖。这样,数据管道的设计变得更加灵活且易于维护。

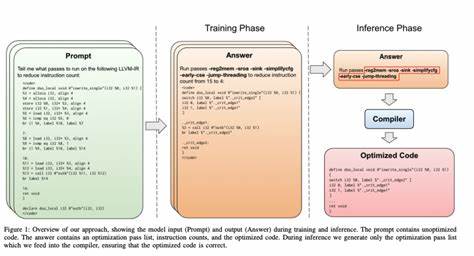

LLM充当了Unix工具的“编译器”,实际上将人类语言转换成机器指令的角色赋予了传统命令行环境。它不仅降低了入门门槛,也丰富了表达能力。开发者无需记忆晦涩的语法和参数,只需专注于业务逻辑和数据场景。通过在项目中结合README文档、Makefile和LLM的协同作用,可以快速生成健壮且易理解的数据处理流程,利于团队协作和项目交接。 值得关注的是,LLMs的介入也在潜移默化深化Unix哲学的现代意义。Unix强调工具的简单、专注以及可组合性,而大型语言模型则赋予这些工具以更强的智能和适应性。

通过自然语言接口,Unix工具链变得更易用,也更具表现力。我们可以看到,无论是迁移旧有遗留脚本,还是设计全新数据管道,LLM都能成为桥梁和加速器。 当然,LLM也非万灵丹,仍需用户谨慎验证生成脚本的正确性和安全性。尽管它们善于模拟人类思维和语言,但复杂的数据逻辑和边缘场景依旧需要工程师亲自把关。与此同时,随着模型能力的提升,未来有望出现结合静态分析和运行时监控的智能工具,进一步提升Unix工具的自动化和可靠性。 从长远来看,LLM不仅仅改变了代码编写的方式,更有潜力推动整个数据工程生态的演进。

它能够将传统分散的知识体系具象化为易用的接口,使更多非专业用户也能轻松驾驭复杂的数据任务,降低对专业技能的依赖。同时,工程师得以把更多精力放在数据价值挖掘和业务创新上,而非繁琐的技术细节处理。 总结来说,大型语言模型作为Unix工具链的“缺失编译器”,正在重新定义数据工程的脚本编写方式和工作流程。它突破了传统工具语法壁垒,通过自然语言转换实现了高效的工具组合,极大提升了数据管道的开发效率和可维护性。未来,随着模型能力不断进化,LLM有望成为数据工作者不可或缺的智能助手,帮助他们在数据洪流中游刃有余,实现更快速、更精准的价值创造。