在人工智能技术飞速发展的今天,强化学习作为智能体自主学习和决策的核心方法,受到了广泛关注。尤其是在复杂游戏环境中,强化学习不仅能够验证算法的有效性,更是推动智能代理不断自我进化的关键手段。然而,面对复杂、高维度且计算资源需求巨大的环境,如何简化强化学习的流程,提高训练效率,成为科研人员和工程师共同面临的挑战。PufferLib应运而生,作为一款专注于复杂游戏环境的强化学习工具库,它不仅提供了高性能的平行仿真支持,还集成了众多便捷的功能,深受学术界和产业界的青睐。 PufferLib最初源自于研发者在博士研究阶段的切实需求,旨在打造一个兼容性强、性能优越且易用的强化学习平台。它不仅支持多种游戏环境,还优化了仿真速度,达到了每秒百万步的惊人水平。

这一性能提升使得训练过程大大缩短,研究者可以在更短时间内完成复杂环境中的算法验证与调优工作。高度模块化和开源的架构也为扩展和自定义提供了良好基础,满足不同项目多样化的需求。 高效的并行仿真是PufferLib的重要特色。传统强化学习中,玩家智能体往往需要在数千上万的环境中并行探索才能获得稳定的学习效果,但这对硬件资源和软件架构提出了极高的要求。PufferLib借助C++与Cuda等高性能编程技术,巧妙实现了仿真层面的资源优化。为复杂游戏场景提供了强大的并发支持,实现仿真和训练的无缝衔接。

这不仅提升了利用率,还降低了单次训练成本,让强化学习真正走向“规模化”训练。 除此之外,PufferLib注重用户体验与社区支持。它搭建了一个完善的文档体系和交流平台,任何使用者都能快速上手并获得即时帮助。在开源精神的推动下,PufferLib拥有活跃的贡献者团队,技术持续迭代与完善。无论是初学者进行算法验证,还是研究人员开展复杂方案开发,都能享受到强大的技术支持和生态资源。 复杂游戏环境对强化学习的挑战不仅体现在计算速度上,还体现在环境设计的细节上。

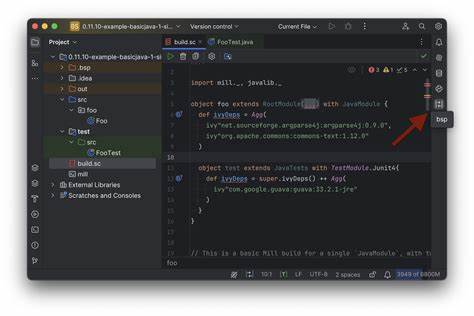

传统RL库难以兼顾灵活性与兼容性,而PufferLib以配置文件驱动的设计,允许用户轻松引入自定义环境,无需深度修改底层代码。这种解耦方式使得不同游戏场景的实验能够快速搭建,服务于多样化的研究需求。同时,PufferLib也预置了多款主流复杂游戏环境,为科研人员提供参考和起点,大大缩短了环境准备时间。 从技术栈来看,PufferLib涵盖了C、C++、Python等多种编程语言,并融合了GPU加速的Cuda技术,确保核心算法和仿真引擎的高效运行。其设计注重兼容性和性能平衡,使得开发者既可以调用高级Python API完成算法实现,也能直接操作底层高性能模块,灵活度极高。开放源码的策略推广了公平共享的理念,促进了跨领域交流与合作。

在实际应用中,PufferLib已广泛应用于多个复杂游戏及模拟环境的强化学习研究。无论是策略类、动作类还是资源管理类游戏,PufferLib均能提供稳定高效的仿真体验,驱动智能代理在场景中不断试错和优化。其优异的可扩展性使得科研机构、创业团队甚至大型企业都能根据自身需求构建专属强化学习平台,从底层性能到用户体验均获得显著提升。 此外,PufferLib团队还提供针对企业的优先服务,助力商业项目快速成长。强大的技术支持和定制服务,帮助机构克服应用落地过程中的技术壁垒。社区内活跃的讨论和多样的案例分享也为用户带来源源不断的创新灵感和应用思路。

通过开放共建,PufferLib正在不断壮大,逐渐成为复杂游戏领域中强化学习研究的标准工具之一。 展望未来,PufferLib将继续聚焦强化学习的核心痛点,推动更高效、更智能的训练算法落地。随着游戏环境的日益复杂和算力的提升,智能代理的能力边界不断拓展,PufferLib的技术优势和社区生态将发挥更大作用。新版本计划引入更多自动化调参工具,进一步降低上手门槛,助力更多开发者迅速展开强化学习项目,促进人工智能技术普及。 总而言之,PufferLib以强大的性能表现和极致用户体验,完美诠释了如何简化复杂游戏环境中的强化学习过程。它既兼顾科研深度,也注重工程实践,为智能决策与自主学习领域提供极具价值的解决方案。

在AI与游戏产业融合的时代,PufferLib无疑是推动智能革命的重要推手,值得所有关注强化学习与游戏智能开发的团队和个人深入了解和使用。