随着人工智能和自然语言处理技术的快速发展,词性标注(POS Tagging)作为文本分析中的关键步骤,越来越受到研究者和开发者的重视。词性标注的核心任务是通过上下文判断单词在句子中的语法角色,从而为后续的语义解析、语法分析、机器翻译等提供基础支持。尽管现代深度学习模型如变换器(Transformer)和循环神经网络(RNN)在该领域表现突出,但基于转换学习的词性标注方法依然因其良好的可解释性、低延迟和易调优优势而备受青睐。理解并掌握这一传统且高效的技术,对于构建高性能的语言处理系统意义重大。词性标注并非简单地将单词与固定标签绑定,而是结合其上下文环境,确定单词的具体语法类别。例如,“tan”一词在不同句子中有截然不同的用法和词性。

在句子“我打算在阳光下晒黑”中,“tan”显然充当动词,而在“我已经很晒黑了,所以待在室内”这句话中,“tan”则为形容词。人类凭借语言天赋轻松完成识别,但机器判别则复杂许多。因此,如何设计精准且高效的词性标注算法,成为自然语言处理中的重要研究课题。传统的词性标注方法往往依赖词典和规则引擎。通过预先构建包含大量单词及其可能词性的词典,结合人工设计的语法规则来限定单词的具体标注。此方法简单直观,适用范围广,但面对歧义性高的上下文以及规模扩展时表现受限。

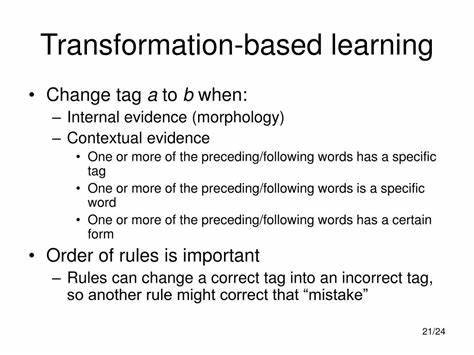

为了克服这一瓶颈,转换学习(Transformation-Based Learning, TBL)提供了一种基于规则迭代改进的机器学习思路。它开始于一个简单的基线模型,例如为每个单词赋予其最常见的词性标签,尽管不够精准,但为后续改进奠定基础。随后,通过系统分析预测与真实标注之间的差异,自动生成大量候选规则并筛选出有效的变换规则,这些规则能够针对具体上下文条件修正错误标注。不断迭代应用这些规则,显著提升整体准确率。TBL的优势不仅体现在切实提升标注性能,还在于规则的直观可解释性。相较于黑盒深度学习模型,TBL生成的规则能够被语言学专家理解和调整,便于针对特定领域优化。

更重要的是,这类模型在推理阶段资源消耗极低,运行速度快,非常适合部署在资源受限的系统中。此外,转换规则可以非常紧凑的形式存储,有利于缩减模型体积。理论上,基于转换学习的词性标注大致可分四个步骤:首先构建简单的基线标注器,通常使用字典为每个词分配最频繁的词性;然后搜集预测错误样本,分析错误集中出现的典型上下文模式;接着利用预定义模板自动生成规则候选,这些模板描述例如词性标签组合、特定词汇位置等信息;最后评估每条候选规则对整体标注准确率的提升,将效果显著的规则依次加入规则集合中完成模型训练。以哈珀(Harper)公司的语言分析系统为例,其早期主要采用字典优先的策略,凭借庞大词库及简易规则实现稳定的词性标注,支持了数万用户的文本校检服务。然而面对复杂任意的边缘情况,单纯词典查找不足以满足更高精度需求。哈珀团队引入转换学习策略后,通过利用来自普适依存句法语料库(Universal Dependencies)的精标数据,系统生成并筛选数十万条候选规则,从而将词性标注准确度由40%提升至95%以上。

在实际应用中,转换规则常涉及对当前单词及邻近上下文多位置的词性进行判定。例如规则可能声明,“若当前词为‘that’,且前一个词被标注为动词时,应把其词性由代词修正为从属连词”,或者“若下一个词是‘there’,并在范围内存在名词标签时,将副词标签改为介词”等。此类规则形式灵活,能够精准覆盖多样化的语言结构和修饰关系。值得注意的是,转换学习并非只能促进词性标注领域,其思想同样适用于其他自然语言处理任务,如分块(chunking)、句法解析等。与深度神经网络相比,转换规则模型训练过程更易解释、调试和复用。此外,由于无需大量算力支撑,拥有快速响应性能,特别适合嵌入式设备和对实时性要求高的应用场景。

虽说神经网络方法近年来发展迅速,堪称语言理解的主流趋势,但规则驱动的机器学习方法依然发挥着不可替代的作用。它既能保证模型的透明度,满足部分需要依据规则审校结果的行业需求,也能节省计算资源,降低部署门槛。总结而言,基于转换学习的词性标注通过循序渐进式地修正基线错误,依托人定义模板产生的候选规则引导模型演化,其独特的优势在于准确率高、模型灵活且低延迟。面对复杂多变的语言环境,它能够让自然语言处理系统获得更稳健的基础表现。未来,融合转换学习与现代深度学习技术的混合模型或许将成为主流,结合两者优点提升整体性能与实用价值。自然语言处理仍处于快速迭代演进中,基于转换学习的传统模型和现代技术的结合将推动语言理解迈向更深入、更智能的阶段。

。