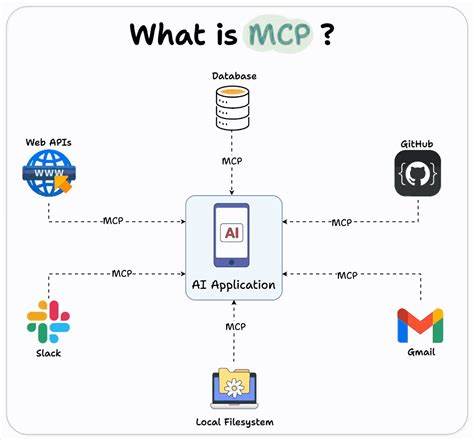

近年来,人工智能和机器学习领域的快速发展促使开发者不断寻求更高效的工具来管理和利用各类模型服务器。其中,llm-tools-openapi作为一款创新插件,引入了将OpenAPI规范应用于大语言模型(LLM)工具的理念,极大提升了模型的集成和操作便利性。而MCP(Model Context Protocol)服务器作为一种基于标准协议的模型服务器,因其灵活性和轻量级通信方式被广泛应用。然而,MCP服务器原生通过标准输入输出(stdio)进行通信,这种方式缺乏标准的网络接口和统一的文档支持,限制了它在复杂应用中的直接使用。针对这一难题,mcpo工具应运而生,通过将任意MCP服务器转化成符合OpenAPI规范的RESTful HTTP服务器,实现了将MCP工具暴露为标准化API的目标。这样一来,无论是开发者还是自动化代理,都能通过开放、标准、安全的HTTP接口访问MCP服务器,极大地简化了集成过程和后续维护。

llm-tools-openapi插件与mcpo的结合,赋予了开发者一种极具实用价值的解决方案。安装llm-tools-openapi插件非常便捷,只需确保与目标LLM模型运行环境相同,并通过简单命令安装即可。借助该插件,用户可以在命令行中直接调用OpenAPI定义的工具,或在Python中通过链式调用接口实现更灵活的应用。mcpo则通过定义简明的配置文件,支持同时运行多个MCP服务器实例,每个实例都能暴露在独立的HTTP路径下,配备自动生成的交互式文档。这种设计不仅确保了多工具环境的可管理性,还使得API调用的清晰性和可追溯性大大提升。 举例来说,在实际应用场景中,开发者只需通过配置文件指定所需运行的MCP工具及其启动命令,启动mcpo后,即可访问对应的HTTP端点和文档页面。

随后,llm-tools-openapi插件通过指定这些OpenAPI端点,便能在大语言模型的推理流程中灵活嵌入API调用,实现对多种模型能力的统一调度。这样的集成模式显著提升了自动化工作流的构建效率,使得复杂任务例如数据抓取、内容生成、模型调用等操作都能在同一生态内协调完成。 值得注意的是,mcpo的设计不仅解决了MCP服务器通信协议不兼容的问题,还通过引入标准的认证、错误处理机制增强了系统的安全性和稳定性。开发者无须再为定制通信协议而烦恼,只需依赖HTTP标准即可实现跨语言、跨平台的无缝调用。同时,自动生成的API文档极大地方便了团队成员了解接口细节,加速了开发周期。 从SEO和内容价值视角来看,llm-tools-openapi结合mcpo的方案满足了当前市场对模型工具集成方案的刚性需求。

随着企业和研究机构对AI模型接入及管理的需求日益增长,能快速实现标准化、高度自动化的方案备受关注。本文精准揭示了这一方案的技术原理、安装流程及应用优势,有效契合了技术人员查询相关集成方案的搜索意图,有助于提升内容在相关关键词下的搜索排名。 此外,借助该方案,用户还可以方便地构建丰富的自动化任务。例如,通过配置playwright MCP工具,配合llm-tools-openapi,用户能自动抓取新闻热点数据并生成结构化笔记,甚至将用户指令与API调用融于一体,实现智能化的知识管理和信息提取。这种应用不仅体现了技术的实用性,也推动了模型驱动软件开发的演进。 面对未来,随着机器学习技术和链式调用机制的不断创新,llm-tools-openapi和mcpo的结合极有可能成为构建大型AI生态系统的基础设施之一。

它不仅支持多种模型灵活组合,还能够在分布式环境下保障服务的稳定性和安全性。开发者和企业可以据此构建更加智能、高效的工具链,满足各类复杂业务需求。 综上所述,llm-tools-openapi与mcpo的配合为传统MCP服务器注入了现代化的API管理能力,打破通信协议限制,实现了接口调用标准化和自动化。它大幅提升了多模型环境下的协作效率,推动了AI应用开发的便捷化与规模化。无论是个人开发者还是大型组织,都可利用该方案搭建高效、安全、易维护的智能模型调用平台,助力数字化转型和智能应用落地。随着社区生态的不断完善,相关工具和文档也在持续更新,值得相关技术人员持续关注和深入探索。

。