在现代数据工程领域,CSV文件仍然是数据交换和存储中使用最广泛的格式之一。尽管CSV文件格式简单直观,但现实中的CSV文件往往杂乱无章,包含格式不一致、缺失值、错误数据类型甚至被破坏的字段。这些问题会让数据导入变得异常复杂,令数据工程师头疼不已。幸运的是,DuckDB作为一款开源的嵌入式列式数据库,提供了强大且灵活的CSV解析与导入功能,帮助用户轻松“驯服”各种混乱的CSV文件,极大提升数据加载的效率和稳定性。本文将深入介绍DuckDB针对复杂CSV数据的高级处理技巧,从诊断文件结构、灵活处理错误行、解决不一致的模式问题,到优化数据类型识别和导入设置,全面提升您的数据处理能力。 深度解读DuckDB的CSV侦测功能是顺利导入文件的关键。

在进行真正的数据加载之前,使用sniff_csv函数对文件进行采样分析,能够准确了解DuckDB是如何解读数据文件的。这个侦测工具自动识别文件的分隔符、转义字符、引号规则、换行符格式,甚至能判断文件是否包含标题行以及每列数据类型的推测结果。当你遇到导入错误或者不确定文件具体格式时,先运行sniff_csv往往能节省大量时间,避免盲目猜测配置参数引起的错误。更进一步,sniff_csv还能生成针对你的具体文件定制的read_csv读入命令模板,只需复制粘贴即可轻松调整,大大简化了调试流程。 DuckDB在侦测过程中采用多阶段策略。首先针对不同分隔符、引号和转义符组合进行多次尝试,以找到最稳定且列数一致的读取方案。

接着,它对样本数据进行类型推断,从最具体的类型(如布尔型、整型、浮点数、时间戳等)逐步回退到字符串,确保类型判断的准确性。与此同时,侦测器会根据首行数据能否被转换成检测出的类型来判断是否为标题行。通过这种严谨的多步检测,DuckDB能够为后续数据导入奠定坚实基础。 在面对包含错误或格式混乱的CSV文件时,DuckDB提供了多种灵活的错误处理方案。最简单的是使用ignore_errors参数,允许导入过程中跳过那些无法解析或类型转换失败的行,保证任务不中断并成功导入大部分有效数据。这在无需停顿纠错、快速获得主干数据时非常有用。

若您希望更详细地了解和追踪被跳过的错误行信息,可以开启store_rejects功能,将不合法行的详细错误信息和原始内容存储在DuckDB的临时表中。这使得错误数据的后续审核、修正和报告变得高效直观,无需人工逐条排查文件。 面对结构不统一或者不断变化的CSV文件集合,union_by_name选项是DuckDB的一大利器。一般情况下,多个文件中列的排列顺序不同,甚至新增或缺失某些列,会导致普通批量导入出现数据错位或导入失败。启用union_by_name后,DuckDB会根据列名而非列序来匹配数据,自动补齐缺失列并用NULL填充,真正实现多文件无缝合并。这对于处理例如按月拆分、版本不断演进的数据报表尤为实用,让数据仓库的维护变得从容不迫。

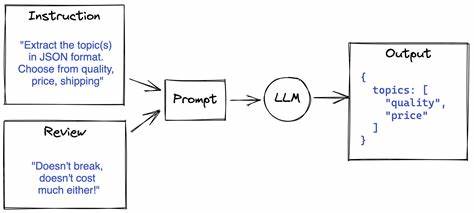

此外,DuckDB允许用户对数据类型进行人工指定与覆盖,以应对自动侦测不足的情况。通过types参数,可以按列名或列序指定所需的数据类型,确保关键字段解析准确无误。强制指定header参数,或命名自定义列名,也可以解决文件头信息缺失或格式异常的问题。针对日期和时间格式不标准的场景,dateformat和timestampformat参数能帮助轻松适配多种格式,避免解析误差。 DuckDB还支持多项解析容错设置,如strict_mode=false允许解析中出现未转义引号、多余或不足字段数时进行宽容处理,null_padding=true则让缺失字段自动使用NULL填充,极大地增加了对非理想CSV文本的适应性。这些特性结合起来,使得导入流程既快速又稳定,即便面对复杂混合问题文件,也能获得高质量的数据读入结果。

在实际应用中,DuckDB的CSV解析性能和稳定性经过了Pollock基准测试的严苛检验。该基准基于超过24万份公开CSV数据集,涵盖数百种非标准格式和RFC-4180规范违规情况。测试结果显示,在配置合理的情况下,DuckDB能够正确导入超过99.6%的测试文件数据,名列各主流库和工具之首。这一成绩不仅印证了DuckDB的技术领先,也昭示其强大的实际价值。 DuckDB的CSV能力不仅是简单的数据加载工具,更是一套应对现实世界“脏数据”挑战的完整解决方案。作为数据工程师,掌握这些高级技巧能让你大幅减少导入前的预处理时间,避免额外维护复杂的转换脚本,同时保证流程的透明度与可控性。

你不再需要在凌晨时分苦苦追踪“行56,789无法转换”之类的错误信息,而是能够快速定位问题,采取合适的容错措施,自信应对多样化的CSV导入需求。 总之,DuckDB凭借其智能侦测、灵活容错、模式合并以及丰富的配置选项,成为了目前数据工程领域处理复杂CSV文件的利器。无论是单个文件还是庞大文件集,无论是规则整齐还是格式混乱,DuckDB都能助你轻松驯服野性的CSV文件,让数据项目更高效、更稳定。下次面对棘手的CSV,不妨试试这些高级功能,也许便能省却无数加班时光,早日投入到更有价值的数据分析与挖掘工作中去。