在当今软件开发领域,智能化工具日益成为开发者提升效率的关键利器。作为历史悠久且备受程序员喜爱的文本编辑器,Vim因其轻量、高度自定义和键盘快捷操作而闻名。然而,面对现代开发需求,单靠传统Vim功能似乎难以满足复杂的编码辅助需求。幸运的是,随着大型语言模型(LLM)技术的迅速演进,越来越多开发者开始尝试将LLM能力融入Vim工作流,实现智能化的编码辅助与自动化。大型语言模型具备强大的自然语言理解和代码生成能力,能够辅助代码补全、错误检查、代码优化建议等多种功能,将单一的文本编辑器转变为智能编程伙伴。本文将围绕如何结合LLM与Vim构建高效工作流展开,覆盖目前主流解决方案、集成方式及用户体验分享。

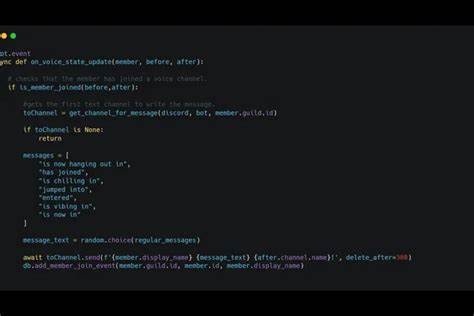

在探索这一主题之前,有必要理解目前主流的AI辅助编码工具生态。从ChatGPT到Google Gemini,再到专门针对代码场景的如GitHub Copilot,这些AI伙伴均具备了与编程相关的自然语言交互能力和代码智能补全功能。对于Vim用户来说,如何将这些AI技术无缝嵌入熟悉的编辑环境,是提升工作效率的关键课题。目前市场上已有多款产品和插件尝试了LLM与Vim的结合。例如CodeCompanion是一个支持与多种大型语言模型交互的工具,可以通过插件或扩展形式实现对单个文件或整个项目的智能辅助。它不仅提供和AI的对话窗口,还能根据上下文推断并执行代码修改建议,极大减少程序员的重复劳动量。

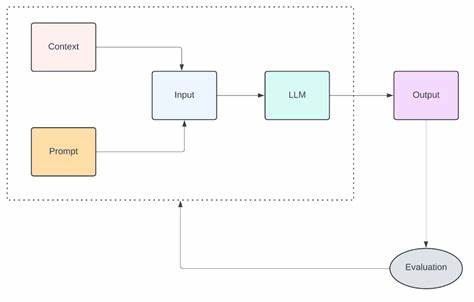

同时,aider等工具也被Vim用户活跃使用,这类工具常采用分别打开LLM交互界面和Vim编辑界面两个独立标签页的方式,虽然界面上不是完全融合,但依旧带来了便捷的智能化体验。此外,针对想要保持纯粹Vim操作体验的开发者,可以考虑使用具备AI能力的编辑器如Zed的Vim模式。Zed内置了智能编码助手,结合了LLM的强大自然语言理解与现代化编辑特性,适合那些既想用Vim快捷键,也期待AI辅助的用户。集成LLM进Vim的方式大致可分为插件式、外围工具配合和替代编辑器三种路径。插件式方案通过安装专门的插件,嵌入AI功能于当前Vim环境,例如neovim社区开展的多种智能代码补全插件。外围工具方式则依赖外部的LLM交互平台,开发者在一个界面中处理AI请求,在另一个界面中编辑代码,实现功能协同。

替代编辑器路径则是由支持Vim模式的全新编辑器整合LLM,比如Zed,为用户带来更现代和统一的体验。无论选择哪种方式,有效管理人工智能对代码的辅助程度是关键。过度依赖可能导致思考能力下降,过少应用又难以发挥AI潜能。合理规划AI询问时机、明确用途场景与人机协作流程才能达到最优效果。在具体操作层面,调试和配置LLM在Vim中的表现同样重要。例如网络连通性、API速率限制、模型调用参数调整均直接影响用户体验。

性能优化与隐私安全考量也不容忽视,尤其当LLM服务方为第三方云时,代码内容的保密性必须得到保障。通过社区交流可以获得丰富的集成经验和最佳实践。Hacker News等技术论坛已经活跃讨论了多种LLM和Vim结合的应用场景。用户反馈表明CodeCompanion搭配Gemini在实际项目中表现优异,既可以自然语言对话,也能对代码结构进行智能理解和修改,操作流畅且准确率较高。另一方面,不同用户对AI辅助的需求深度不同。有些追求简单自动补全,有些则希望实现复杂的代码重构和批量编辑操作。

了解自身项目特点和团队协作模式,有针对性地选用工具尤为重要。总结来看,结合LLM技术的Vim工作流正处于快速发展阶段,既有趋于成熟的产品,也有创新尝试的空间。未来随着模型能力提升和接口集成优化,Vim用户将享受到更加自然和深入的智能编码体验。开发者应积极关注社区动态,尝试多样化方案,持续调整和完善个人工作流,从而在激烈的开发竞争中获得明显优势。总而言之,LLM助力的Vim编码之路已经开启。选择合适的工具和方法,并融入日常开发习惯,可以显著提升编码效率和代码质量。

充分利用AI技术这一强大助手,将帮助老牌编辑器焕发新活力,助力程序员解锁更高效、智能的编程体验。