随着人工智能技术的迅速发展,大型语言模型(LLM)在各类自然语言处理任务中展现出强大的能力。尤其是在商业应用、学术研究和各类实际场景中,如何有效地定制大型语言模型以满足特定需求成为了业界关注的重点。微调(Fine-tuning)和上下文学习(In-context learning)作为两种主流的模型定制方式,因其不同的技术路径和应用效果备受讨论。本文将深入探讨这两种方法在实际任务中的表现、优缺点及应用场景,帮助读者全面理解如何优化和提升大型语言模型的实际效用。微调是指在预训练模型的基础上,使用特定领域或任务的标注数据对模型参数进行额外训练,以增强模型对于某一特定任务或领域的理解能力。通过调整模型内部权重,微调使得模型能够更准确地捕捉和利用任务相关的特征信息,提升下游任务的性能。

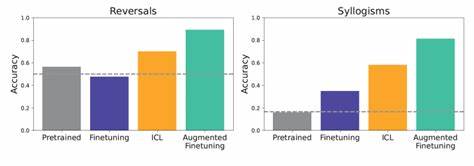

微调的优势在于其能够深度挖掘任务数据的潜在信息,从而显著提升模型的准确率和鲁棒性。尤其是在数据量充足且标注质量较高的情况下,微调后模型通常表现稳定且专业性强。然而,微调也面临一定的挑战。首先,微调过程资源消耗较大,需要较强的计算能力和时间成本。其次,过度微调可能导致模型过拟合,从而降低其泛化能力。此外,每当任务发生变化时,都可能需要重新进行微调,维护成本较高。

相比之下,上下文学习是一种无需修改模型参数,依赖于在输入中提供足够示例或提示的方式,来引导模型生成所需输出的策略。通过在提示中嵌入相关任务的演示样例或指令,模型可以基于已有知识进行灵活推断。这种方法尤其适合模型规模极大、预训练数据广泛的情况下。上下文学习的最大优势在于其灵活性和快速适应能力。无需重新训练,用户只需设计合理的提示即可实现多样化功能,极大降低了使用门槛。此外,上下文学习支持多任务切换,适合快速试错和场景探索。

但其局限也明显,提示设计依赖经验且效果不稳定,容易受到上下文长度限制和模型记忆容量的制约。在复杂或需要高准确度的任务中,上下文学习的表现可能不及微调。实际应用中,微调和上下文学习各有千秋,选择何种策略需结合具体任务需求和资源条件。若目标任务需要高度专业化解读,且拥有充足的标注数据和计算资源,微调无疑是提升性能的有效手段。另一方面,对于多样化、变化频繁的场景,或者资源有限的情况下,上下文学习则提供了便捷且经济的解决方案。随着技术的进步,两者的界限也在不断模糊。

例如,少量微调结合上下文提示的混合策略日益流行,既利用了微调的深度优化优势,又发挥了上下文学习的灵活性。这种混合方法在实际工程中显示出良好效果,推动大型语言模型应用向更加智能和高效发展。此外,社区和企业也在积极探索自动化提示生成、提示优化技术,以及更高效的微调算法,期望进一步降低门槛并提高模型定制的适用范围。未来,随着算力的提升和算法的优化,大型语言模型的定制将更加普及和多样化。用户和开发者能够根据自身需求,灵活选择微调、上下文学习或其结合方法,实现模型在语言理解、文本生成、知识问答等多个领域的高效应用。总结来看,微调与上下文学习作为大型语言模型定制的两大主流路径,分别在深度适应性和快速灵活性方面展现独特优势。

理解和把握它们的特点,有助于推动语言模型技术在真实世界任务中的广泛落地,助力各行业数字化转型升级,并不断拓展人工智能在自然语言处理领域的边界。