近年来,大型语言模型(LLMs)如ChatGPT的崛起,为学术界带来了翻天覆地的变化,尤其在生物医学领域的科研写作和出版方面体现得尤为明显。随着这些模型能够生成和润色文本,符合人类写作水平,研究人员越来越多地依赖它们完成论文摘要、文献综述和讨论等部分。然而,这种变革不仅影响写作效率,也极大地改变了学术出版物中的词汇使用特点,甚至带来了学术语言风格的重大转移。 通过对2010年至2024年期间超过1500万篇生物医学论文摘要的词汇分析,研究者发现,自ChatGPT类大型语言模型在2022年11月发布以来,科学文献中的某些风格词汇使用频率出现了突然激增。这类风格词主要是形容词和动词,区别于以往主要反映科学内容的名词频率变化。数据显示,2024年约有13.5%的论文摘要至少包含了这些由大型语言模型助推的风格词,远超在COVID-19大流行期间词汇变化的规模。

此发现不仅揭示了LLMs在辅助学术写作中的深广应用,也为学术规范与写作伦理提出新的挑战。 大型语言模型的广泛应用直接影响了科研文章的语言表达。此前,科研文本中的词汇变化多因研究方向的兴衰、重大事件或者新技术的发展所驱动,通常体现在内容词汇的频繁更替。例如,新兴疾病爆发期间,病毒名称和防控措施等内容词汇在文献中出现频次极大提升。相比之下,LLMs引起的词汇变革更多体现在修饰性的风格词汇上,如“详尽地”、“重要地”及“综合性地”等。这不仅使得论文语言更加流畅和精致,也体现出模型对行文风格和修辞修饰的偏好。

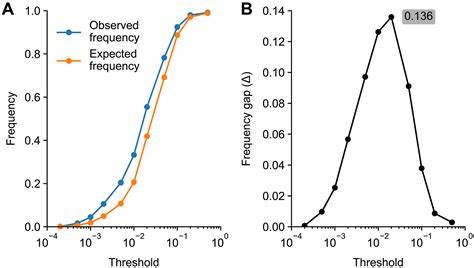

通过构建词汇使用频率的时间序列分析,并采用线性外推法预测若无LLM影响词汇应有的出现频率,研究团队计算了实际频率与预期频率之间的差距。这种差距被定义为“过度频率”,成为衡量LLM影响力的量化指标。结果显示,2024年出现过度频率增加的风格词数量比过往任何年度都多,甚至超过了新冠疫情引发的内容词汇风暴。此外,这种词汇的变化并非随机分布,而是集中在动词和形容词等修饰语言上,凸显了LLM对行文风格的独特影响力。 不同学科领域、国家和出版社对于LLM的采用程度存在明显差异。计算机科学和生物信息学等对技术敏感度较高的领域,LLM辅助写作的痕迹最为明显,词汇风格的过度使用显著高于其他生物医学分支。

在地理区位上,非英语为母语的国家如中国、韩国和台湾地区的论文更频繁展现这种风格词的增加,反映出作者利用LLM辅助提升英文写作质量的趋势。相反,顶级权威期刊如Nature、Science等,其论文中LLM影响的词汇比例则较低,可能与严格的审稿流程和编辑政策有关。 这场写作风格的革命伴随着不少争议。许多科学家认识到LLM助力下的流畅性和表达能力提升,极大减轻语言障碍,促进跨国交流与合作。但与此同时,模型生成的文本可能隐藏事实性错误,甚至夸大研究结论,增加学术不端风险。尤其在文献综述和讨论部分,错误难以辨识,可能对科学传播质量构成隐患。

更甚者,某些不法机构可能借助LLM生产假论文,扰乱学术生态。 对LLM带来的这一词汇质变的认识,亟需学界和出版界共同制定规范。多种建议相继浮现,包括限制LLM在同行评议中的使用,明确对LLM辅助写作的披露要求,以及发展基于“过度词汇”检测的技术手段,实时监控和识别论文中可能的AI协助痕迹。此类措施不仅有助于维护科学诚信,也利于科学语言的多样性与独创性的保持。 从更广泛的视角看,LLM技术推动的学术写作变革,与历史上科技进步对语言和思维方式的影响相呼应。正如印刷术、信息技术革命曾深刻塑造了知识传播结构,LLMs也正重新定义科学文本的构成和传播节奏。

未来,随着模型能力不断提升,LLM对科研写作的影响将更加深入和复杂。科学共同体需持续关注这种技术带来的机遇和风险,积极探索融合创新与规范的共生路径。 总的来说,LLMs引发的生物医学出版界词汇剧变,揭示了人工智能在科研领域的深远影响。通过详尽的数据挖掘和创新分析框架,揭开了传统词汇与风格模式的边界被重新书写的现实。展望未来,科学写作将更加多元与自动化,同时也呼唤更加严格的伦理监督和科学标准。正确应对这一转型,不仅有助于提升科研效率和质量,也将促进全球科学交流的公平和透明。

。