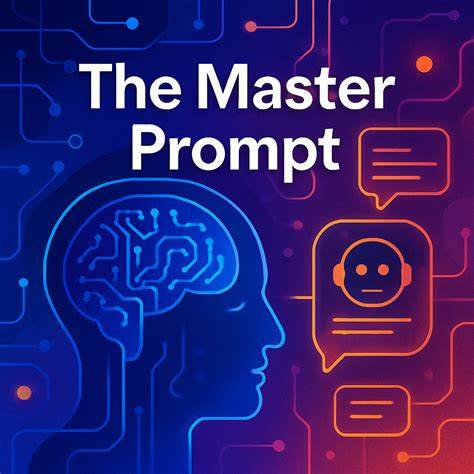

大型语言模型作为人工智能领域的革命性成果,已经被广泛应用在文本生成、自动分类、内容编写等多种任务中。随着技术的普及,越来越多的开发者和用户开始深入了解如何与这些模型互动,通过设计巧妙的提示语来引导模型产出更准确、高效的结果。然而,语言模型在处理复杂任务时,常常展现出过度思考的特点,这不仅增加了计算延迟,也导致输出的不确定性和歧义性。本质上,语言模型并不具备真正的意识或内在思维,它们所谓的“思考”仅是基于概率和上下文的预测。理解这点,对于改进和优化语言模型的使用至关重要。最初,开发者们尝试通过在提示语中加入清晰的分步骤指令来引导模型执行复杂任务,希望借此缩小模型的搜索空间,减少错误。

然而这种方法并不总能奏效,模型往往依然会跳过某些步骤或者产生偏离预期的答案。于是,促使语言模型“写出思考过程”的思路被提了出来。这种“写出思考”的技术,将模型生成的内部推理显性化,让开发者可以审视模型的判断路径,从而判别其合理性或偏差。这种“思考板”(scratchpad)的引入提升了模型的遵循度和可靠性,虽然代价是增加了生成的时延。随后,模型提供商探索了更智能的方式,开发了内置推理能力更强的“推理模型”,例如OpenAI的o1模型、Google的Gemini2.5-Pro和Deepseek的R1,它们能够在内部进行多轮“思考”,形成更连贯的推理链,最终给出答案。这种方法有助于减少人为设置的“思考版”,让模型在无需显式提示的情况下依然能够保持较高的逻辑严密性。

尽管如此,推理模型并非万能解药,尤其是在分类任务中表现出局限性。分类任务需要模型将输入事实与对应标识精确匹配,并正确判断属性。普通模型在处理大量事实时,容易出现记忆缺失和混淆-id的问题。为缓解这一难题,引入了“内联思考”的方式,即模型在生成输出时即时结合上下文信息做决策,而非等所有推理完成后才输出结果。通过让模型先复述事实内容,再给出判断与理由,能够有效增强模型对任务的关注和准确度。在实际应用如知识库建设时,这种分类方法十分重要。

通过将文档分章节提取主题问题,随后精准去重相似问题,能够确保知识点无重复并清晰表达。此处,推理模型的过度思考尤为显著。模型反复分析某两个看似相近问题是否属于同一主题,甚至自我矛盾地反复修正判断。这种行为类似于人类心理学中的“过度思考”现象,既浪费时间也增加判定难度。为应对这一窘境,开发者不得不为模型设定更复杂的规则,限定“何为相似”、“何为不同”,试图引导模型做出更稳妥判断。此过程和心理学家劝导患者停止无谓纠结的过程十分类似——通过设立界限,帮助语言模型放下无止境的内部辩论。

过度思考不仅存在于分类任务,还体现在需要条件判断的场景中。当模型被要求“仅在满足条件Y时执行操作X,否则输出无操作”时,它常常陷入不断推敲条件满足与否的陷阱,导致不可预测的结果。显然,让模型“想太多”并不能提升任务表现,反而带来副作用。为化解这一问题,现实方案是“麻痹”模型的过度思维倾向。这意味着,在设计提示语和选择模型时,应避免复杂指令的循环纠结,采用更直接和适度理性的提示方法。内联思考策略正是在此背景下被提倡。

通过在生成过程中逐步给出简单分析,辅以背景信息,减少复杂规则外加,能够保持必要的推理深度,同时避免陷入无谓反复。例如,在文档主题识别中,给出事实复述后立刻分类,而非让模型先进行多轮深度推理,可以获得更快且更准确的分类结果。推理模型与内联思考模型各自擅长不同任务类型。前者胜在需要“计划执行”或“先解决问题后解释”场景,如复杂写作、逻辑推理题解。后者则更适合“少量思考即可增进判断”的日常自动化工作,如分类、过滤、简单问答。然后,开发者和使用者应根据具体需求灵活选择适当方案,避免过度依赖某一模式,以增强AI产品的实用性和稳定性。

理解并驾驭语言模型的“思考”方式,既是技术挑战也是艺术。就像心理学家耐心引导过度担忧的患者走出思维陷阱,AI开发者也需透析语言模型的行为规律,给予恰当的提示和限制,帮助模型发挥最佳性能,避免陷入无谓的内部纠结。未来随着算法的进步和训练数据的丰富,推理模型有望在保持严密逻辑的同时,具备更强的任务适应能力,减少过度思考带来的副作用。此外,结合强化学习、人类反馈等多元技术,将进一步提升模型在复杂任务中的表现稳定性。总之,成为你语言模型的“心理学家”,了解其思考陷阱与偏误,采取合理干预策略,不仅能提升AI应用的效率,也能带来更可靠、用户友好的智能体验。在人工智能日益普及的时代,拥有这份洞察力,是人人都值得拥有的技能和认知。

。