大型语言模型(LLM)作为人工智能领域的重要突破,凭借其强大的自然语言处理能力和广泛的应用潜力,正不断改变着信息传播、商业决策以及科技创新的面貌。然而,随着技术的普及和成熟,LLM也成为潜在的工业破坏利器,通过系统化、大规模地制造假信息操纵竞争环境。工业破坏并非新现象,但当代技术赋予其新的破坏力和复杂性,使得传统防御机制变得薄弱。本文将探讨LLM驱动的工业破坏的机制、背后的风险因素、实际应用案例以及应对之道。过去,经济间谍活动和信息操纵常常依赖有限的人力资源和手工操作。例如,历史上的情报机构如苏联的克格勃活跃在制造虚假文件、泄露假消息以扰乱对手企业和经济体系。

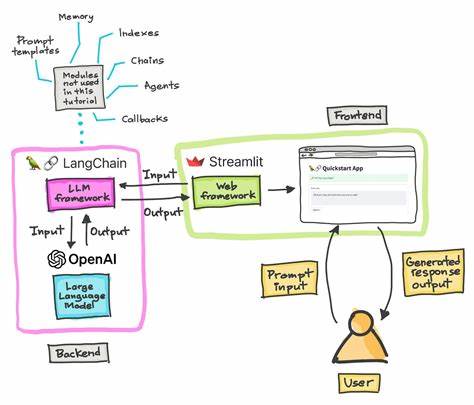

现代环境下,这种策略已演进为信息领域的混合战争,涵盖网络攻击、社交媒体操控和虚假内容传播。大型语言模型的出现极大地“工业化”了这一过程。现在只需通过API调用,便可自动生成大量具有迷惑性的文章、研究报告、虚假网站及社交媒体账号,短时间内在网络空间制造极具迷惑力的虚假信息海洋。这种规模和速度的提升,使得“真相”如同置身于一面满是镜子的大厅,表面繁荣多元,实则源于单一、歪曲的声音。通过这种手段,竞争对手可能误判市场趋势,错误投资,导致产品开发和资本支出决策失误,从而陷入战略失败。经济效益极其显著,这种信息操控的成本远低于带来的潜在收益,使得敌对国家或企业无法抗拒这种低成本、高回报的破坏诱惑。

与此同时,企业内部对大型语言模型的过度信任也成为破坏的温床。人类普遍存在“真实默认理论”,即倾向于信任自信流畅的信息输出,而大型语言模型恰恰利用了这一心理漏洞。许多管理层和产品经理在缺乏专业核查的情况下,将模型生成的虚假数据作为决策依据,这导致了敏感商业资源的错误配置和方向性迷失。另外,随着深度伪造技术的发展,市场操纵更加直观和具备欺骗性。虚假的高管视频、虚构的新闻报道轮番出现,使得真假难辨,即便是专业人士也难以区分真伪。为了抵御这种新型的工业破坏威胁,多个层面上的防范措施必须被提上日程。

首先,数字内容的出处认证技术日益成为必要工具。基于密码学的内容溯源标准如C2PA可以为信息赋予数字签名,保证内容的真实来源和完整性,然而目前主流社交平台和内容发布渠道大多未对其进行强制性应用。其次,提升个体和组织的信息素养至关重要。通过教育与培训让管理者和决策者意识到大型语言模型的局限性和潜在风险,养成多渠道核查和事实复核的习惯,从根本上阻断误导信息对决策的影响。同时,针对LLM的黑盒性质,开展透明度要求和第三方审计变得尤为重要,尤其是在涉及重大商业决策和公共利益的情境中。独立的审计机构应具备充分权限和激励机制,对训练数据来源、模型输出及其偏差进行全面评估,力图发现和防范有意或无意的误导成分。

虽有人建议引入对抗性测试,通过模拟虚假内容攻击增强模型的防护能力,但此举可能反而推动技术进入更复杂的军备竞赛阶段,增加检测难度,需谨慎权衡。未来,随着人工智能技术尤其是大型语言模型的不断进步,工业破坏的形态将更加多样和隐蔽。若缺乏有效监管和防护机制,不仅企业利益受损,国家经济安全也将面临严峻挑战。从历史经验到技术现状,都表明谎言反复重复最终可能被视为真理,真相与虚假的界限将更加模糊。这不仅是技术挑战,更是伦理和社会治理的课题。只有建立多层次的防御体系,包括技术保障、法律法规和社会共识,才能有效抑制基于大型语言模型的工业破坏行为。

归根结底,信任需要建立在严格求证和多方核实的基础上。企业管理者尤其需要摒弃盲目信任工具的惯性,强化信息验证意识,培养批判性思维,才能在这个充满复杂信息的时代做出明智而稳健的决策。正如经典反乌托邦作品所言,过去的谎言一旦被遗忘,便成为新的“真理”。今天,我们正处于一个需要警惕和抵御这一过程的新阶段。面对LLM驱动的工业破坏,唯有提前洞察风险、构筑坚固防线,方能在未来激烈的全球经济竞争中占据主动,维护公平与正义的市场秩序。