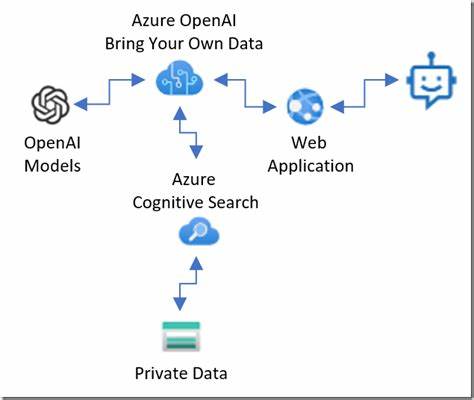

随着人工智能技术的飞速发展,尤其是大规模语言模型的广泛应用,关于这些先进系统的运行基础设施受到了越来越多关注。其中,OpenAI作为领先的人工智能研发机构,其模型推理过程实际在何处服务器上执行,成为众多技术爱好者、研究者甚至企业用户关心的问题。本文将深入探讨OpenAI服务器部署的位置、云服务提供商合作情况以及背后的技术布局,帮助读者理解人工智能推理背后的物理基础设施。 首先,OpenAI并未自建大规模服务器集群来承担所有推理工作,而是选择与大型云服务提供商合作,以确保模型推理的高效性和可扩展性。微软Azure是OpenAI最主要的合作伙伴之一。自2019年以来,OpenAI获得了微软巨额投资,双方不仅在资金层面紧密结合,更在云基础设施建设方面展开深度协作。

微软Azure为OpenAI提供了全球范围内多个数据中心的计算资源,这些数据中心具备强大的算力,能够支持GPT、DALL·E以及其他复杂人工智能模型的推理与训练。 微软Azure在全球拥有分布广泛的数据中心网络,涵盖北美、欧洲、亚洲等主要区域,这些数据中心配备了最新的GPU和定制AI加速硬件,专门优化模型推理性能和响应速度。通过利用Azure的数据中心基础设施,OpenAI能够实现模型推理的高并发处理,同时保证低延迟和高可用性。这对于提供实时交互体验至关重要。 除了微软Azure,OpenAI也可能使用其他云服务商的资源,尤其是在某些地理区域或特定服务场景下。但迄今为止,公开信息和行业分析普遍认为Azure是其主要的服务器运行环境,支持其核心模型的实际推理工作。

通过集中资源于成熟的云平台,OpenAI避免了庞大硬件管理和维护的复杂性,将更多关注点放在模型算法优化和服务创新上。 从物理角度来看,OpenAI的推理服务器主要位于微软的高安全性数据中心内。这些数据中心通常具备完善的电力供应系统、强大的冷却设施以及多重安全防护措施,保证数据处理的稳定性和安全性。这些因素对于处理海量数据、执行复杂运算的人工智能模型尤为重要,避免因硬件故障或安全事件导致服务中断或数据泄露风险。 部署在这些数据中心的服务器通常安装有高性能NVIDIA GPU或其他专用AI芯片,支持大规模并行计算,满足复杂神经网络推理的巨大算力需求。这些服务器通过高速网络连接实现数据和模型参数的快速传输,确保模型响应时间符合用户交互期待。

在软件层面,OpenAI运行的模型推理依托高度优化的分布式计算框架和容器化技术。这使得推理任务能够动态调度至不同服务器,实现负载均衡和资源最优利用。这样的架构设计不仅提升了推理效率,也增强了系统的弹性和可扩展性,能够适应用户访问量快速增长的挑战。 此外,OpenAI高度重视数据隐私和合规性。其在部署服务器的地理位置选择上也考虑到不同国家和地区的法律法规,确保用户数据在处理过程中的合规使用。微软Azure的数据中心具有符合多项国际安全标准的认证,为OpenAI模型推理提供了强有力的合规保障。

未来,随着人工智能技术的不断演进和应用场景的拓展,OpenAI的服务器布局也将持续优化和扩展。除了继续深耕微软Azure资源,OpenAI可能会探索混合云或多云环境,以进一步提升计算能力和服务覆盖范围。同时,伴随新型计算硬件的发展,其数据中心硬件配置也会不断更新换代,以支持更高效、更强大的模型推理性能。 总结来看,OpenAI的人工智能推理主要依赖于微软Azure庞大且先进的数据中心基础设施,涵盖全球多个地区的高性能服务器。通过整合顶尖硬件资源与高效的云计算管理,OpenAI能够为全球用户提供快速、稳定且安全的AI推理服务。理解这一基础设施布局,有助于更全面地认识现代人工智能系统的运行机制,为相关技术研究和产业应用提供有价值的参考。

。