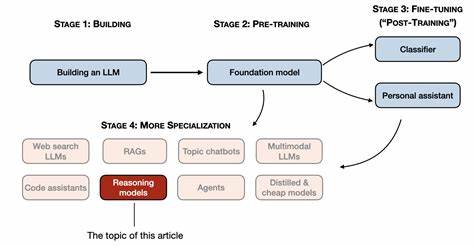

随着人工智能技术的高速发展,大型语言模型(LLMs)在自然语言处理领域展现出卓越的推理能力,尤其是在跨领域任务中的表现令人瞩目。近年来,凭借长链式思维链(Long Chain-of-Thought, Long CoT)训练,大规模推理模型(Large Reasoning Models, LRMs)在解决复杂推理问题时逐渐展现出更强的迁移和泛化能力。然而,尽管这些模型的应用效果显著,支持其跨领域通用推理的内在机制却鲜有深入解析。来自Feng He等研究团队最新提出的ProtoReasoning框架,为理解这一现象提供了全新的视角,将推理原型(Reasoning Prototypes)作为实现通用推理能力的基础,开启了推理研究的新篇章。 ProtoReasoning的核心假设认为,不同任务之所以能够共享推理能力,关键在于其背后蕴藏共通的抽象推理原型。这些原型本质上反映了问题的核心逻辑结构,剥离了具体领域和情境的细节差异,从而揭示看似不同的问题之间内在的关联性。

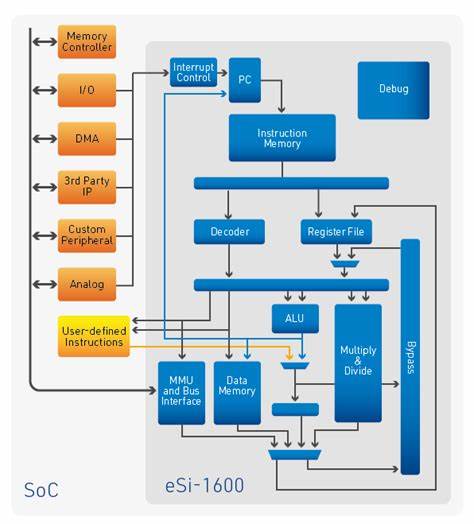

通过捕捉这些共享的基础推理模式,模型具备了在多样任务间迁移知识和技能的能力。这种方法突破了传统单一领域训练的限制,推动模型在逻辑推理、规划和数学等多种场景下都能取得显著提升。 ProtoReasoning框架的另一个重要特色是其自动化的原型构建流程。该流程能够将复杂的自然语言问题转换成对应的原型表示,其中逻辑推理使用Prolog语言表达,规划任务则借助PDDL(Planning Domain Definition Language)来描述。这种原型化表示不仅形式规范,便于模型理解和处理,还实现了逻辑清晰且结构严谨的表达,为推理验证和反馈机制提供了基础。借助Prolog和PDDL解释器,系统可对推理过程进行全面的自动验证,确保输出的准确性和合理性,同时还能为模型训练提供即时且可靠的监督信号。

ProtoReasoning还具备高度的可扩展性,能够在原型空间内合成多样化的推理问题,保证合成任务的正确性。这样,模型不仅能通过大量真实数据学习,还能在合成数据帮助下扩展其认知边界,摸索更广泛的推理路径和策略。实验表明,采用ProtoReasoning训练的模型在多个评测数据集上均表现出明显优于传统方法的成绩。在Enigmata-Eval逻辑推理任务中取得了4.7%的提升,规划任务上提高了6.3%,通用推理测试MMLU中增长4.0%,数学领域的AIME24成绩也上升了1.0%。这些数字不仅体现了原型思维的有效性,更强化了其作为基础推理模式的科学价值。 值得关注的是,消融实验进一步验证了在原型空间进行学习相比仅依赖自然语言训练的方法具有更强的泛化能力。

模型在遇到结构相似但内容不同的新问题时,能更准确地应用先前学习到的推理原型,从而降低对具体语料的依赖,提升跨领域迁移的效率和效果。这证明了将推理模式抽象化为可操作的原型,是实现大型语言模型跨任务、跨领域推理能力通用化的重要路径。 从技术视角看,ProtoReasoning代表了推理技术中符号推理与深度学习结合的典范。它巧妙地将符号系统(如Prolog、PDDL)作为解释器和反馈工具,融合神经网络的学习能力,避免了纯数据驱动方法在逻辑一致性和推理严密性上的缺陷。这不仅为学术界提供了新的研究思路,也为工业界打造具备高鲁棒性和可验证性的智能系统打开了广阔空间。 未来,ProtoReasoning有望在更多复杂推理任务中发挥作用,例如法律判决辅助、科学发现自动化以及智能规划系统等领域。

同时,进一步优化自动原型构建流程和验证机制,将帮助模型更快适应多变的现实问题环境。随着多模态数据的融合和跨语言推理需求的增加,原型化推理框架也将在多领域协同智能的构建中扮演更加关键的角色。 总的来说,ProtoReasoning不仅提供了一种全新的理解大型语言模型通用推理能力的理论框架,更通过技术创新实现在实际任务中的性能突破。其提出的推理原型概念,有望引领未来人工智能系统在复杂认知任务上迈出更坚实、更通用的一步。随着研究的深入和技术的成熟,基于ProtoReasoning的推理模型将成为推动智能系统更广泛应用的关键动力,助力人工智能迈向真正的“通用智能”时代。