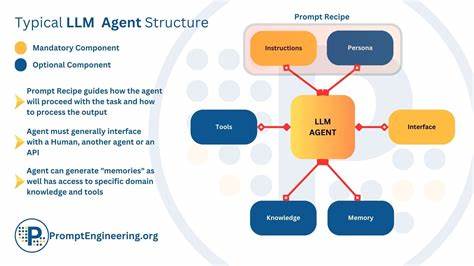

近年来,人工智能技术在软件开发领域展现出前所未有的潜力,尤其是在AI双人编程(AI pair programming)场景中,智能代码助手的出现令开发效率飞速提升。然而,随着代码库规模的日益庞大,如何确保AI助理准确且高效地理解上下文,成为刻不容缓的挑战。智能上下文聚合(Intelligent Context Aggregation)技术因此应运而生,旨在自动识别、排序并汇总最相关的代码和信息内容,为AI模型提供精准且紧凑的上下文环境,显著提升AI的推理质量和响应准确性。 本文聚焦于打造智能上下文聚合体系的核心理念与实现细节,结合开源项目tenets的创新实践,详尽阐述了其对当前AI双人编程架构的革新影响。首先,需要了解传统AI代码助理在上下文获取上的局限。以现有主流工具为例,它们往往采用简单的字符串匹配或者关键词搜索,直接在代码库中进行遍历,但这种"蛮力"搜索导致大量无关代码被引入上下文,消耗宝贵的令牌预算,且难以保障结果的相关性。

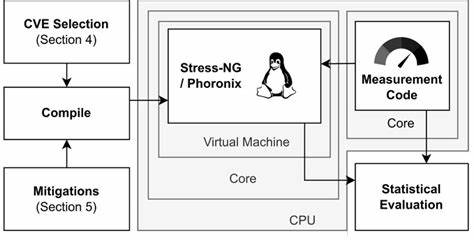

这很大程度上限制了AI智能辅助的精准度与开发体验。智能上下文聚合的优势在于它通过多维度的信号综合分析,赋予AI更"理性"的选择能力。tenets项目采取了一套融合规则匹配、统计排名、语义理解等多层机制的框架,利用全文检索算法BM25对关键词相关性进行加权排名,进一步结合文件结构、导入关系、代码复杂度、Git提交历史等丰富代码元信息,实现多信号加权的综合评判体系。 这种多信号融合不仅提升了文件排序的准确度,还可以针对不同开发任务(如调试、重构、新功能开发)的特点,动态调整权重分配,确保上下文选择的场景适配性与实效性。同时,智能上下文聚合技术在令牌预算受限的限制下,运用了动态规划的文件打包算法,巧妙决定哪些文件应全量加载,哪些可进行抽取式摘要,从而最大化上下文利用率。这一点极为关键,它弥补了大模型上下文窗口狭窄的不足,为长代码库提供了高效解决方案。

此外,针对代码的特殊性,tenets设计了代码感知的分词策略,其细粒度地拆解CamelCase与下划线命名标识符,有效避免了传统NLP分词带来的语义丢失问题。这种代码敏感型的分词增强,使得搜索结果中关键变量名、函数名的相关度评分更精准,更符合程序语义逻辑。另一方面,项目深度挖掘Git历史中的变更频率和最近提交信息,利用时间加权指数体现代码热点和维护优先级,为上下文的时效性筛选提供决策依据。 机器学习技术同样融入智能上下文聚合,通过采用句子嵌入模型与双编码器架构,实现对语义相似度的捕捉。这使得搜索不仅停留在文本匹配层面,而是能够理解代码片段间深层次意义的关联。进而,对排名结果利用交叉编码器进行细粒度重排序,解决了语义级别的正负相关精判断,保障了结果的准确度和可信度。

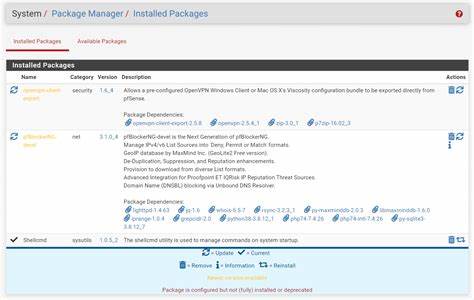

并且,这些操作均在本地完成,避免了额外API调用成本,同时兼顾响应速度。 随着智能上下文聚合技术在实际开发环境中的应用,其在提升AI协同编程效率、减少无关代码噪声、增强研发团队知识协同性等方面价值日益显现。tenets作为一种基于Python生态的轻量级MCP(Model Context Protocol)服务器,完美融合CLI工具和程序库形式,支持与主流开发工具链(如VS Code、Claude Desktop、Cursor等)无缝对接,极大拓宽了应用范围和用户便捷度。不仅如此,tenets还能在会话管理上实现文件和规则的"固定",保证连续上下文的一致性,帮助AI持续聚焦于关键模块,提高多轮交互的准确率和开发连续性。 同时,智能上下文聚合带来的还有代码质量和复杂度的可视化分析。通过集成代码复杂度测量、热点文件检测、责任归属等功能,团队能够更清晰地了解项目脉络与风险点,辅助做出更科学的技术决策。

对应的团队开发节奏和日志轨迹洞察也促使研发效率逐步提升。 从技术架构角度讲,构建智能上下文聚合平台面临的关键挑战在于性能与可扩展性。tenets采用多进程并行计算评估多维排名信号,合理缓存冷热数据,利用动态懒加载机制避免不必要的模块加载,使得整个系统兼顾响应速度与功能丰富度。同时设计独立且统一的接口CLI与Python API,使得不同使用场景灵活切换,满足从个人开发者到大型团队的多样需求。 在未来,AI双人编程将不仅仅依赖于模型本身的能力,而是与智能上下文聚合等辅助技术紧密结合,形成生态闭环。上下文智能拼接、机制约束甚至多轮推理验证将成为普适趋势,促使代码智能助手成为开发流程中不可或缺的智慧伙伴。

总的来说,智能上下文聚合是破解当前AI编码助手场景瓶颈的制胜法宝,其集成先进检索算法、语义理解与代码特定特性于一身,能够精准匹配开发者需求,提升编程交互体验,降低时间成本。开发者应积极探索这一技术,结合自身项目实际,借助开源工具如tenets,推动团队向更高效的AI协作编程新时代迈进。 。