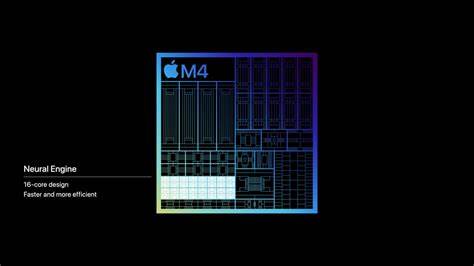

随着人工智能技术的不断进步,硬件与软件的深度融合成为提升模型性能的关键因素。Anemll 近期发布了对 Apple 神经引擎(Apple Neural Engine,简称 ANE)的 Qwen3 支持,这一举措不仅彰显了 Anemll 在 AI 加速领域的技术实力,也为苹果设备上的机器学习应用注入了新的动力。Qwen3 作为一款先进的大型语言模型,具备极高的理解和生成能力,配合 Apple 神经引擎的强大计算资源,将为用户带来更为流畅、高效的人工智能体验。 Apple 神经引擎是苹果公司专门设计的 AI 加速器,集成于其最新的芯片架构中,能够极大地提升机器学习任务的执行速度和能效比。传统上,AI 模型在通用 CPU 或 GPU 上运行,由于计算架构的不同,往往无法充分发挥硬件性能。Apple 神经引擎通过深度定制,为神经网络推理提供高效的计算支持,从而实现低延迟和低功耗的模型运行。

Qwen3 是由领先人工智能研究团队打造的具有前瞻性的语言模型,具备强大的自然语言理解和生成能力,广泛应用于智能问答、文本生成、语义搜索等领域。将 Qwen3 与 Apple 神经引擎相结合,能够充分利用神经引擎的硬件优势,显著优化模型推理速度,提升设备端的人工智能应用表现,而无需依赖云端计算服务。 Anemll 团队针对 Apple 神经引擎的架构特点,深入优化了 Qwen3 模型的运行机制,实现了模型参数与神经引擎指令集的高效匹配。这种深度适配不仅保证了模型推理的准确性,还极大减少了计算资源的消耗,延长了设备续航时间,对于移动端用户而言尤为重要。通过这次技术升级,用户能够享受到更快速响应的智能服务,更流畅的交互体验。 此外,Anemll 在支持 Qwen3 的过程中注重兼容性和易用性的提升,确保开发者能够无缝将这一功能集成到现有应用中,无需对底层架构做出复杂修改。

Anemll 提供了详细的开发文档和丰富的 API,助力开发者快速入门并发挥神经引擎的最大潜能。与此同时,通过开源社区的协作,Anemll 正在不断完善和增强该支持功能,推动整个生态体系的持续进步。 这项技术进步对于苹果设备用户和 AI 应用开发者来说意义深远。对于终端用户而言,借助 Apple 神经引擎加速的 Qwen3 模型,能够体验到更加智能化的应用场景,例如更精准的语音助手、更智能的文本输入和更丰富的内容推荐服务。而对于企业和开发者来说,借助 Anemll 的技术支持,可以更快速地推出创新型智能应用,降低了应用开发的门槛和成本。 随着计算机视觉、自然语言处理等 AI 领域的发展,对高效、本地化机器学习的需求越来越迫切。

Anemll 针对 Apple 神经引擎的 Qwen3 支持,无疑为智能设备的 AI 应用打开了新的可能性。未来,随着模型训练技术与硬件设计的不断演进,这种软硬件协同优化的趋势将更加明显,推动人工智能向更加普适、智能和节能的方向发展。 总体来看,Anemll 对 Apple 神经引擎的 Qwen3 支持标志着 AI 技术迈向更高效、更智能的阶段。这不仅提升了苹果生态系统内的人工智能性能,也为全球 AI 发展注入了新动力。在未来,依托持续创新的技术力量,更多突破性的人工智能应用将实现落地,改变人们的工作和生活方式。