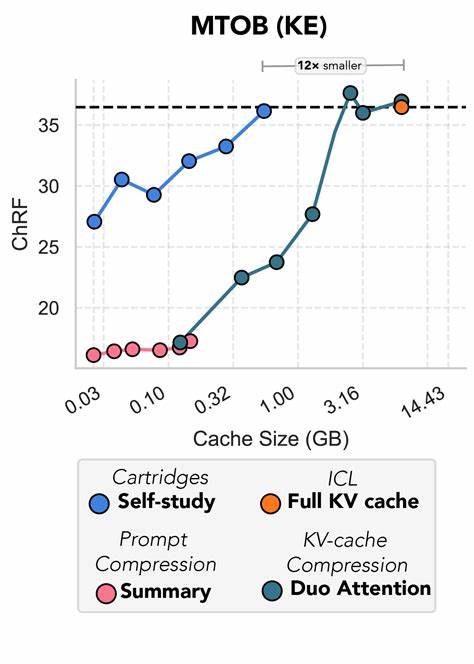

在自然语言处理领域,长上下文的管理与高效存储一直是研究与应用中的重要难题。随着大型语言模型的广泛应用,处理大型文本语料时所需的计算资源和存储压力迅速增加,特别是在键值(KV)缓存的规模上更是表现得尤为突出。Cartridges项目基于自我学习(self-study)技术,通过训练一个小型KV缓存,成功实现了对大规模文本信息的浓缩表示,不仅大幅降低推理成本,同时无需牺牲生成文本的质量,成为长上下文存储领域的创新典范。Cartridges的方法带来了性能与效率的双重提升,极大地推动了大规模语言模型在实际场景中的落地与应用。 长上下文带来的挑战主要集中在模型推理的计算瓶颈上。传统的大型语言模型将上下文中的文本直接编码并存储在巨大的KV缓存中,随着文本长度增加,缓存空间需求呈指数增长,导致推理速度显著减缓,硬件负载激增。

Cartridges提出的核心思路,是离线训练一个小型的KV缓存——即所谓的“微型缓存”——对整个大规模文本库进行有效表示,从而在推理时替代传统一维度庞大的上下文缓存。这种方法不仅保留了丰富的语义信息,还大幅降低了计算资源消耗,使得模型能以接近原始性能的效果,快速响应长文本查询需求。 项目采用了一种名为自我学习的训练策略。这一策略设计了一对AI代理——一个负责提出基于文本内容的问题或请求,另一个则利用给定上下文回答问题,从而生成合成会话数据。模型随后通过上下文蒸馏(context-distillation)方式,在这些合成数据上进行训练,使得微型缓存能够准确逼近原始长上下文的表示效果。这种训练机制巧妙地利用语言模型自身的推理能力生成高质量训练数据,极大提高数据合成的真实性和多样性,为微型缓存训练提供坚实基础。

在实际训练流程中,首先需要对目标文本资源进行切块处理。Cartridges支持多种数据格式,包括纯文本文件、LaTeX文档、Slack消息及电子邮件内容等,能够灵活适配不同背景和需求。切块过程通过确定合适的分块大小以及含有代表性关键字的种子提示,实现对文本的精准分割,保证每个文本块都涵盖足够的信息量,便于后续合成会话生成。通过这种定制化的资源配置,训练过程更加高效。 合成会话的生成依赖于强大的推理服务器。Cartridges项目推荐使用专门优化的服务框架Tokasaurus,具备高吞吐率和易于定制的优势。

通过将推理负载分布至多GPU,配合Modal等容器编排平台,能够实现训炼和推理任务的快速切换和水平扩展,显著缩短实验反馈时间。这为研究者和开发者提供了一个便捷、高效的开发生态。 训练阶段采用上下文蒸馏技术,将合成会话作为输入,优化微型缓存的参数。训练配置灵活支持多种模型架构,如基于Qwen系列的因果语言模型,并允许初始化方法多样化,包括随机文本初始化和预训练缓存初始化。这种多样性使得用户能够根据具体任务和资源限制选择最适合的训练方案。 除了基础训练外,Cartridges重视训练过程中的评估机制。

模型定期在留出的验证集上进行困惑度(perplexity)评测,量化微型缓存对文本生成质量的影响。此外,还支持基于生成文本的质量评估,通过采样生成多样化回答并人工或自动评估其相关性和合理性,确保训练出符合预期效果的缓存模型。这一完善的评价链条保证了模型的实用性和可靠性。 Cartridges的应用场景丰富多样。在代码库、科研论文、聊天历史、邮件存档等长文本场景中,传统模型面临显著的内存和计算瓶颈,而微型缓存则为这些应用注入新的活力。尤其是在对话系统和文档问答等需要实时响应的场景,Cartridges缩减了上下文存储的开销,使得模型能够迅速调用核心信息,提升用户体验。

此外,Cartridges项目提供了便捷的本地交互和服务器部署方案。用户可以通过命令行工具直接与训练好的微型缓存模型对话,或者利用Tokasaurus服务器实现高效的远程推理服务。值得一提的是,Tokasaurus支持从HuggingFace和本地文件加载多个缓存模型,满足复合任务和多领域知识组合的需求,极大地增强了模型的灵活性和扩展性。 虽然Cartridges已经在长上下文表示领域展现出优异表现,团队也诚实地指出目前存在的一些挑战和发展方向。部分数据并行训练时会遇到通信超时问题,团队正在通过更换后端框架和优化分布式策略进行修复。同时,模型与缓存上传到公共平台的流程也正不断完善,期待未来用户能够更便捷地分享和复用训练成果。

总结来看,Cartridges利用自我学习驱动的上下文蒸馏方法,成功将海量文本信息压缩为小巧却表达力强的键值缓存。通过这一创新,长文本处理的计算效率获得显著提升,同时确保生成文本的质量和连贯性。该项目不仅为自然语言处理模型的长上下文管理提供了有效解决方案,也为相关领域的研究者和工程师研发高效大规模语言模型提供了宝贵参考。随着软硬件设备的持续进步及算法优化,Cartridges有望在人工智能复杂交互和知识管理领域发挥更加重要的作用,推动智能系统向更高效、更智能的方向迈进。